ImagenTime模型利用图像转换和扩散模型,实现对短、长和超长时间序列的统一生成建模,并在多个基准测试中达到SOTA。

原文标题:NeurIPS 2024 ImagenTime:利用图像转换实现变长时间序列生成的处理

原文作者:数据派THU

冷月清谈:

该模型的核心思想是将时间序列数据转换为图像,然后利用成熟的视觉扩散模型进行处理。具体而言,它使用延迟嵌入和短时傅里叶变换(STFT)将时间序列转换为图像。转换后的图像被输入到一个扩散模型中,该模型学习如何对图像进行去噪。在生成过程中,模型通过反向迭代逐步去除噪声,最终生成新的时间序列数据。

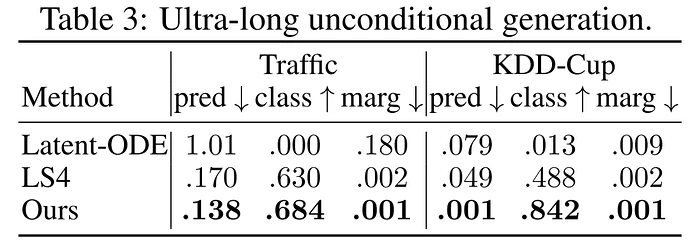

实验结果表明,ImagenTime在多个数据集上实现了最先进的性能,尤其在超长序列的生成上表现出色。在无条件生成任务中,ImagenTime在短期判别得分上比之前的扩散模型提高了58.17%,在(超)长分类得分上提高了132.61%。此外,ImagenTime在条件生成任务(例如插值和预测)中也表现出色,优于现有的许多方法。

该模型的优点在于其能够在一个统一的框架内处理不同长度的时间序列,并且可以利用视觉领域先进的扩散模型技术。这种跨领域结合的思路为时间序列生成建模提供了新的方向。

怜星夜思:

2、文章中提到了扩散模型在推理过程中计算成本较高的问题,如何改进或优化这个问题,以提高模型的效率?

3、ImagenTime 模型在条件生成任务中表现出色,但实际应用中条件生成的任务往往更加复杂,例如多变量时间序列的插值和预测。如何将 ImagenTime 扩展到更复杂的条件生成场景?

原文内容

来源:EvolGroup本文约2500字,建议阅读5分钟本文提出了一种基于信号到图像变换和视觉扩散骨干的新模型实现在一个框架中同时考虑短期、长期和超长期时间序列。

|

标题

|

Utilizing Image Transforms and Diffusion Models for Generative Modeling of Short and Long Time Series

|

|---|---|

|

作者

|

Ilan Naiman,Nimrod Berman,Itai Pemper,Idan Arbiv,Gal Fadlon,Omri Azencot

|

|

论文

|

https://arxiv.org/pdf/2410.19538

|

|

代码

|

https://github.com/azencot-group/ImagenTime

|

摘要

-

利用先进的扩散视觉模型;

-

在同一框架内显著处理短序列和长序列输入;

-

利用时间序列到图像文献中最近提出和建立的工具。

1.引言

-

将时间序列生成建模视为视觉问题,利用图像转换和视觉模型技术;

-

开发了一个灵活的生成模型,无需重大调整即可处理不同长度的序列;

-

在无条件及条件生成任务上达到最先进水平,尤其在超长序列基准上表现卓越。

2.问题陈述

3.时间序列到图像的转换

4. 方法

思路形成

模型框架概述

-

时间序列到图像的模块;

-

扩散模型;

-

图像到时间序列的模块。