字节跳动推出INFP技术,可将静态照片转化为可进行实时对话的动态数字人,实现自然的多轮对话交互。

原文标题:字节整新活!照片+音频让蒙娜丽莎秒变播客主理人

原文作者:机器之心

冷月清谈:

INFP的技术方案分为两个阶段:首先,通过Motion-Based Head Imitation从对话视频中学习交互和运动行为,并将其映射到运动隐空间;然后,通过Audio-Guided Motion Generation将双轨对话音频映射到预训练的运动隐空间,生成相应的运动潜码,驱动肖像照片生成动态视频。

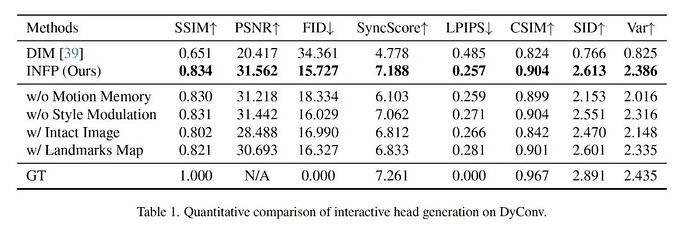

实验结果表明,INFP在多方面优于现有技术,即使在单一交互场景下也能达到SOTA效果。该技术目前仅用于学术研究,并受到严格的权限控制,以防止滥用。

怜星夜思:

2、INFP技术如何确保生成内容的安全性和避免被滥用?除了限制访问权限,还有哪些技术手段可以防止其被用于生成虚假信息或进行恶意攻击?

3、INFP技术未来可能的应用场景有哪些?除了虚拟主播和在线客服,它还能在哪些领域发挥作用?

原文内容

AIxiv专栏是机器之心发布学术、技术内容的栏目。过去数年,机器之心AIxiv专栏接收报道了2000多篇内容,覆盖全球各大高校与企业的顶级实验室,有效促进了学术交流与传播。如果您有优秀的工作想要分享,欢迎投稿或者联系报道。投稿邮箱:[email protected];[email protected]

-

论文链接:https://arxiv.org/pdf/2412.04037

-

项目网页:https://grisoon.github.io/INFP