SAFE框架利用慢速与快速参数高效调优策略,提升预训练模型在持续学习中的性能,有效避免灾难性遗忘。

原文标题:【NeurIPS2024】SAFE: 慢速与快速参数高效调优用于基于预训练模型的持续学习

原文作者:数据派THU

冷月清谈:

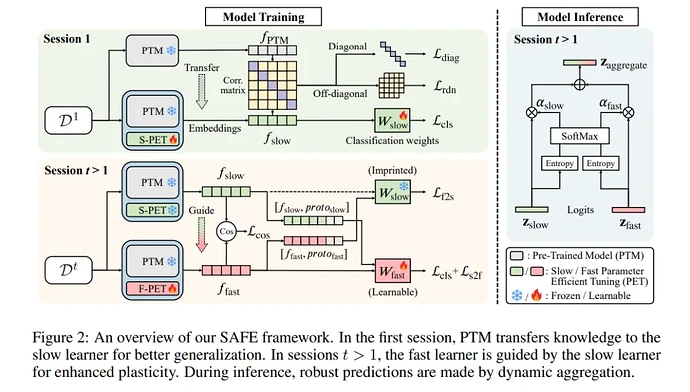

首先,SAFE通过迁移损失函数,衡量预训练模型和应用参数高效调优后模型之间的相关性,保留预训练模型中的通用知识。这使得慢速高效调优的参数能够捕捉更多信息特征,提高对后续类别的泛化能力。

其次,SAFE在增量学习阶段平衡了稳定性和适应性。它固定慢速高效调优的参数,并持续更新快速参数,并利用跨分类损失和特征对齐方法来避免灾难性遗忘。

最后,在推理阶段,SAFE采用基于熵的聚合策略,动态地利用慢速和快速学习者之间的互补性。

实验结果表明,SAFE在多个基准数据集上优于现有的持续学习方法。

怜星夜思:

2、文章提到了使用跨分类损失和特征对齐来避免灾难性遗忘,这两种方法具体是如何工作的?它们之间有什么联系和区别?

3、基于熵的聚合策略在推理阶段是如何动态利用慢速和快速学习者的?这种策略相比于简单的平均或加权平均有什么优势?

原文内容

来源:专知本文约1000字,建议阅读5分钟

我们提出了一个慢速与快速参数高效调优(SAFE)框架。