探讨微调对LLM新知识整合的影响,未知知识可能引发幻觉。

原文标题:微调真的能让LLM学到新东西吗:引入新知识可能让模型产生更多的幻觉

原文作者:数据派THU

冷月清谈:

怜星夜思:

2、幻觉现象的根本原因是什么?

3、如何更有效地利用RAG方法来进行知识更新?

原文内容

来源: DeepHub IMBA本文约1800字,建议阅读5分钟

本文研究了一个经过微调的模型会发生什么,以及它在获得新知识后的反应会发生什么。

大型语言模型(llm)是在巨大的文本语料库上训练的,在那里他们获得了大量的事实知识。这些知识嵌入到它们的参数中,然后可以在需要时使用。这些模型的知识在培训结束时被“具体化”。在预训练结束时,模型实际上停止学习。

对模型进行对齐或进行指令调优,让模型学习如何充分利用这些知识,以及如何更自然地响应用户的问题。但是有时模型知识是不够的,尽管模型可以通过RAG访问外部内容,但通过微调使模型适应新的领域被认为是有益的。这种微调是使用人工标注者或其他llm创建的输入进行的,模型会遇到额外的事实知识并将其整合到参数中。

模型如何集成这些新的附加知识?

在机制层面上,我们并不真正知道这种相互作用是如何发生的。根据一些人的说法,接触这种新知识可能会导致模型产生幻觉。这是因为模型被训练成生成不以其预先存在的知识为基础的事实(或者可能与模型的先前知识冲突)。模型还有可能会遇到罕见的知识(例如,在预训练语料库中较少出现的实体)。

因此,最近发表的一项研究关注的是分析当模型通过微调得到新知识时会发生什么。作者详细研究了一个经过微调的模型会发生什么,以及它在获得新知识后的反应会发生什么。

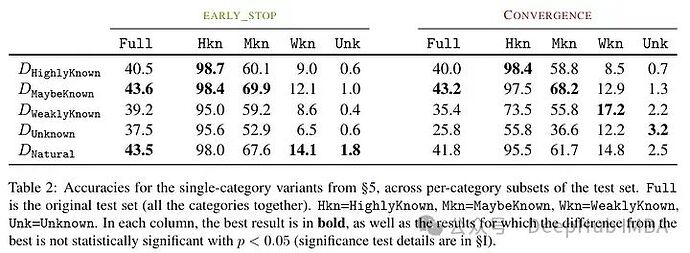

他们尝试在微调后对示例进行知识级别的分类。一个新例子固有的知识可能与模型的知识不一致。例子可以是已知的,也可以是未知的。即使已知,它也可能是高度已知的,可能是已知的,或者是不太为人所知的知识。

然后作者采用了一个模型(PaLM 2-M)对其进行了微调。每个微调的例子都是由事实知识构成的(主体、关系、对象)。这是为了允许模型用特定的问题、特定的三元组(例如,“巴黎在哪里?”)和基本事实答案(例如,“法国”)查询这些知识。换句话说,它们为模型提供一些新知识,然后将这些三元组重构为问题(问答对)以测试其知识。他们将所有这些例子分成上述讨论的类别,然后评估答案。

对模型进行了微调然后测试幻觉,得到了下面的结果:未知事实的高比例会导致性能下降(这不会通过更长的微调时间来补偿)。

未知事实在较低的epoch数下几乎是中性的影响,但在更多的epoch数下会损害性能。所以未知的例子似乎是有害的,但它们的负面影响主要体现在训练的后期阶段。下图显示了数据集示例的已知和未知子集的训练精度作为微调持续时间的函数。可以看出,该模型在较晚阶段学习了未知样例。

Lastly, since Unknown examples are the ones that are likely to introduce new factual knowledge, their significantly slow fitting rate suggests that LLMs struggle to acquire new factual knowledge through fine-tuning, instead they learn to expose their preexisting knowledge using the Known examples.

作者尝试对这种准确度与已知和未知例子之间的关系是进行量化,以及它是否是线性的。结果表明,未知的例子会损害性能,而已知的例子会提高性能,这之间存在很强的线性关系,几乎同样强烈(这种线性回归中的相关系数非常接近)。

这种微调不仅对特定情况下的性能有影响,而且对模型知识有广泛的影响。作者使用分布外(OOD)的测试集表明,未知样本对OOD性能是有害的。根据作者的说法,这与幻觉的发生也有关系:

另外一个有趣的结果是,最好的结果不是用众所周知的例子获得的,而是用可能已知的例子。换句话说,这些例子允许模型更好地利用其先验知识(过于众所周知的事实不会对模型产生有用的影响)。

相比之下,未知和不太清楚的事实会损害模型的表现,而这种下降源于幻觉的增加。

This work highlights the risk in using supervised fine-tuning to update LLMs’ knowledge, as we present empirical evidence that acquiring new knowledge through finetuning is correlated with hallucinations w.r.t preexisting knowledge.

根据作者的说法,这种未知的知识可能会损害性能(这使得微调几乎毫无用处)。而用“我不知道”标记这种未知知识可以帮助减少这种伤害。

Acquiring new knowledge via supervised fine-tuning is correlated with hallucinations w.r.t. pre-existing knowledge. LLMs struggle to integrate new knowledge through fine-tuning and mostly learn to use their pre-existing knowledge.

综上所述,如果在微调过程中出现未知知识,则会对模型造成损害。这种性能下降与幻觉的增加有关。相比之下,可能已知的例子反而有有益的影响。这表明该模型难以整合新知识。也就是说在模型所学到的知识和它如何使用新知识之间存在冲突。这可能与对齐和指令调优有关(但是这篇论文没有研究这一点)。

所以如果想要使用具有特定领域知识的模型,论文建议最好使用RAG。并且带有“我不知道”标记的结果可以找到其他策略来克服这些微调的局限性。

这项研究是非常有意思,它表明微调的因素以及如何解决新旧知识之间的冲突仍然不清楚。这就是为什么我们要测试微调前和后结果的原因。

论文地址: