介绍了一种新方法PiSSA,利用奇异值分解提升模型微调效率。

原文标题:PiSSA :将模型原始权重进行奇异值分解的一种新的微调方法

原文作者:数据派THU

冷月清谈:

怜星夜思:

2、对比PiSSA和LoRA,哪一种更适合实际应用?

3、有什么其他已知的方法与PiSSA相似?

原文内容

来源:DeepHub IMBA本文约600字,建议阅读5分钟我们开始看4月的新论文了,这是来自北京大学人工智能研究所、北京大学智能科学与技术学院的研究人员发布的Principal Singular Values and Singular Vectors Adaptation(PiSSA)方法。

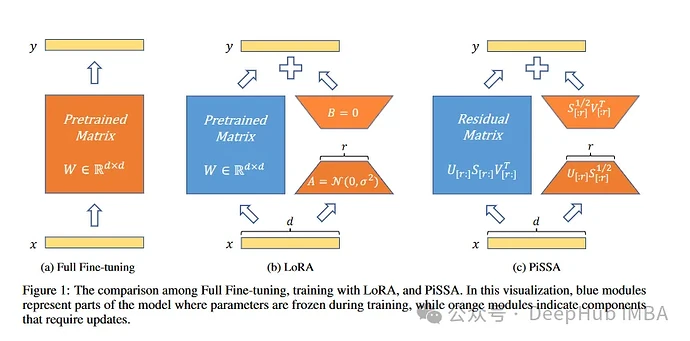

PiSSA和LoRA一样,都是基于这样的前提:对模型参数的改变会形成一个低秩矩阵。

这种方法通过将模型中的矩阵表示为两个可训练矩阵的乘积,辅以一个用于错误校正的残差矩阵,优化了紧凑的参数空间。利用奇异值分解(SVD),PiSSA初始化主奇异值和奇异向量以训练这两个矩阵,同时在微调过程中保持残差矩阵静态。

PiSSA与LoRA的架构相一致,继承了诸如可训练参数减少、轻松部署等好处。但是与LoRA不同,使用PiSSA进行微调的过程与完整模型过程相似,会避免无效的梯度步骤和次优结果。

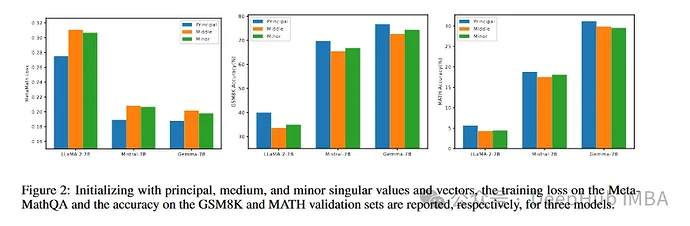

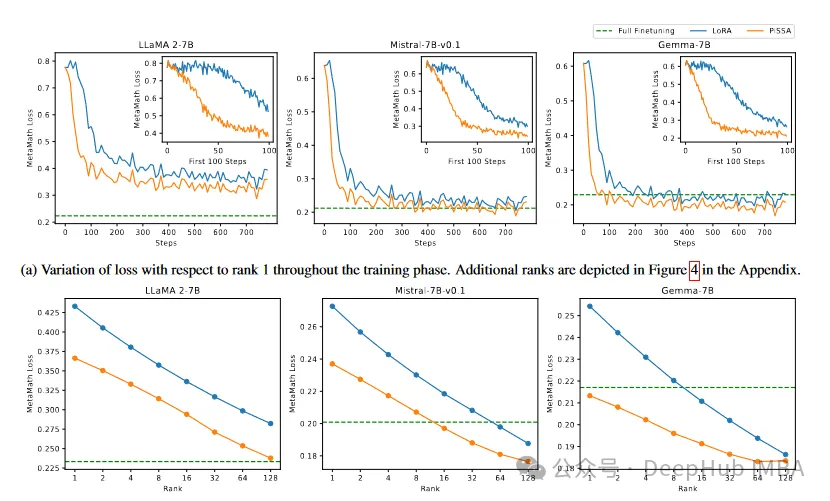

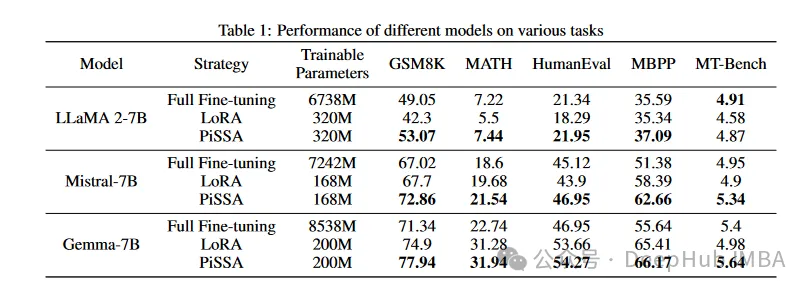

在LLaMA 2-7B、Mistral-7B-v0.1和Gemma-7B模型的多个任务的比较实验中,PiSSA凭借卓越的表现脱颖而出。以主奇异值和向量初始化的微调适配器产生了更好的结果。

PiSSA展示了加速的收敛速度、与训练数据的稳健对齐,并在类似的可训练参数配置下胜过LoRA。

利用快速SVD技术有助于PiSSA在初始化速度和性能之间取得平衡。

论文中将奇异值分解应用于预训练模型的权重矩阵,以提取主要成分。然后使用这些成分来初始化一个名为PiSSA的适配器。微调PiSSA在开始阶段可以密切复制完整模型微调的效果,同时保持良好的参数效率。通过大量实验,展示了PiSSA的微调性能显著超过了LoRA。

论文地址:https://arxiv.org/abs/2404.02948

论文还提供了代码可以直接拿来测试:https://github.com/GraphPKU/PiSSA

编辑:文婧