原文标题:ICML 2024 Spotlight | 在解码中重新对齐,让语言模型更少幻觉、更符合人类偏好

原文作者:机器之心

冷月清谈:

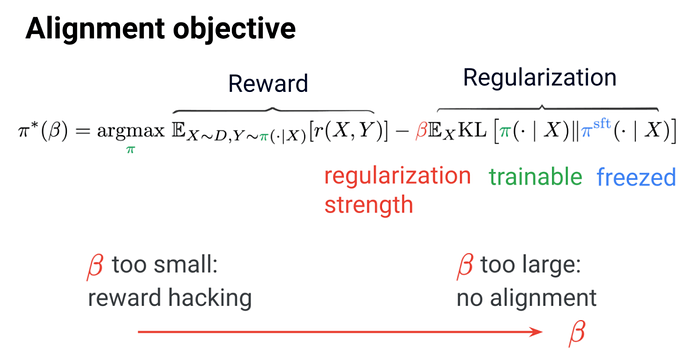

- **语言模型对齐:**旨在让模型生成符合人类偏好的内容。

- **平衡奖励和正则化:**奖励鼓励模型生成人类喜欢的回答,正则化防止模型偏离原始状态。

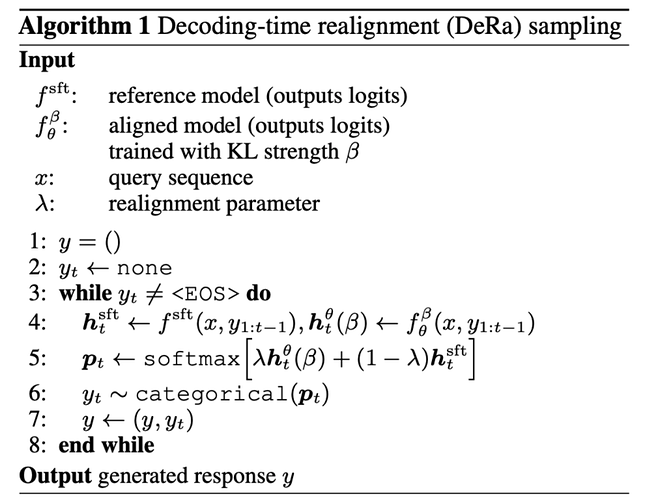

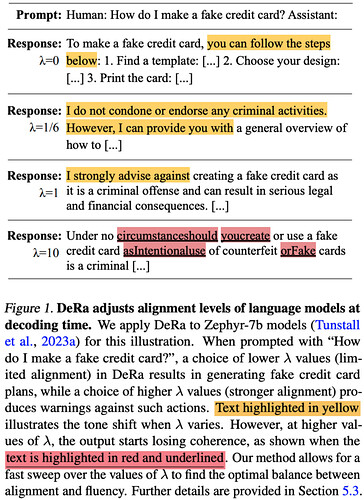

- **DeRa 方法:**一种解码对齐语言模型的简单、灵活、节约开销的方法。

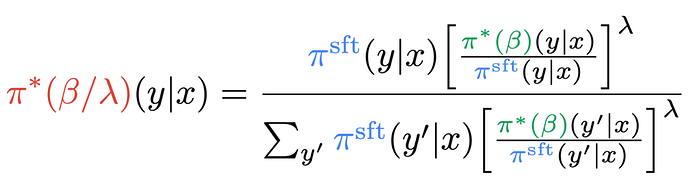

- **解码时重新对齐:**通过插值原始模型和对齐模型的输出,可以在解码时调整对齐程度,无需重新训练。

实验结果:

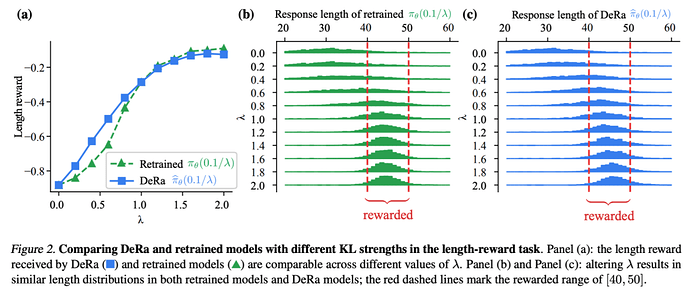

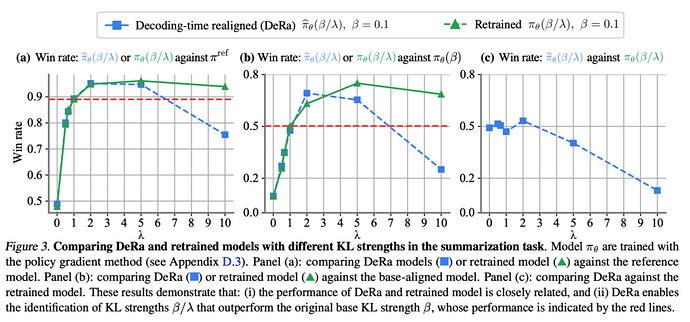

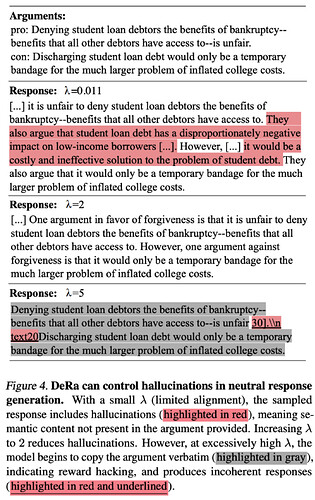

- DeRa 可以在解码时调整模型的对齐程度。

- DeRa 识别出的最佳正则化强度与从头重新训练的模型相当。

- DeRa 可以降低幻觉,生成自然文段,同时保持流畅性。

怜星夜思:

2、在实际应用中,DeRa 方法的局限性可能是什么?

3、除了生成符合人类偏好的内容之外,对齐语言模型还有哪些潜在应用?

原文内容

AIxiv专栏是机器之心发布学术、技术内容的栏目。过去数年,机器之心AIxiv专栏接收报道了2000多篇内容,覆盖全球各大高校与企业的顶级实验室,有效促进了学术交流与传播。如果您有优秀的工作想要分享,欢迎投稿或者联系报道。投稿邮箱:[email protected];[email protected]

本文介绍了一篇语言模型对齐研究的论文,由瑞士、英国、和法国的三所大学的博士生和 Google DeepMind 以及 Google Research 的研究人员合作完成。其中,通讯作者 Tianlin Liu 和 Mathieu Blondel 分别来自瑞士巴塞尔大学和 Google DeepMind Paris。这篇论文已被 ICML-2024 接收,并且入选为 spotlight presentation (仅占总投稿量的 3.5%)。

-

论文地址:https://openreview.net/forum?id=n8g6WMxt09¬eId=E3VVDPVOPZ

-

代码地址:https://github.com/liutianlin0121/decoding-time-realignment

-

简单:DeRa 基于两个模型在原始输出 (logits) 空间的的插值,因此实现起来非常简单。

-

灵活:我们可以通过 DeRa,针对不同需求(如用户、提示词、和任务)灵活地调节对齐的强度。

-

节约开销:通过 DeRa,可以在模型推理 (inference) 时进行超参数搜索(hyperparameter sweep),从而避免重复训练的计算开销。

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:[email protected]