原文标题:李飞飞「空间智能」系列新进展,吴佳俊团队新「BVS」套件评估计算机视觉模型

原文作者:机器之心

冷月清谈:

简介

李飞飞教授近年来大力倡导「空间智能」概念,推动计算机视觉领域的发展。近期,其团队发表了后续研究成果——BEHAVIOR Vision Suite(BVS)。该工具套件旨在为计算机视觉模型评估和训练提供定制化合成数据集。

BVS工具套件

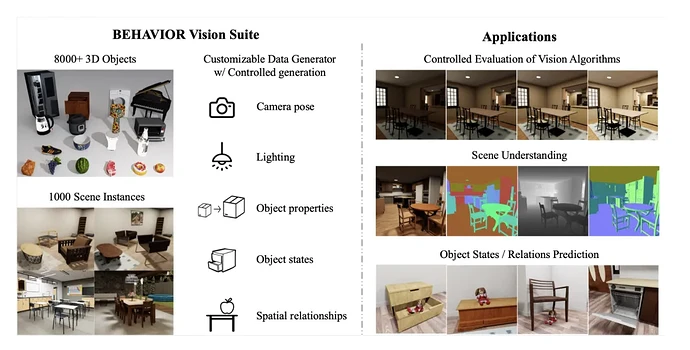

BVS包括两部分:数据部分和可定制数据生成器。

数据部分基于BEHAVIOR-1K进行了拓展,包含8841个3D物体模型和1000个室内场景实例,涵盖丰富的语义类别。

可定制数据生成器允许用户根据场景级别、物体级别和相机级别参数生成满足特定需求的图像数据集。这些参数包括光照、物体摆放、关节配置、视野等。

应用场景

BVS在以下三个方面展现了优势:

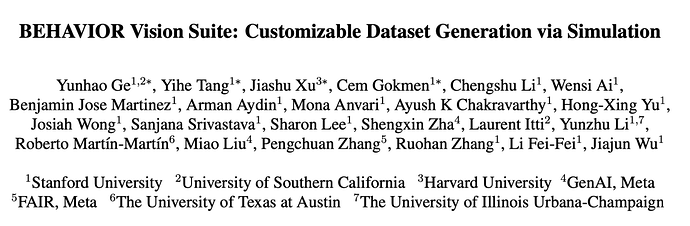

- **可控参数评估模型鲁棒性:**评估模型在环境参数(遮挡程度、亮度、拍摄角度等)连续变化时的表现。

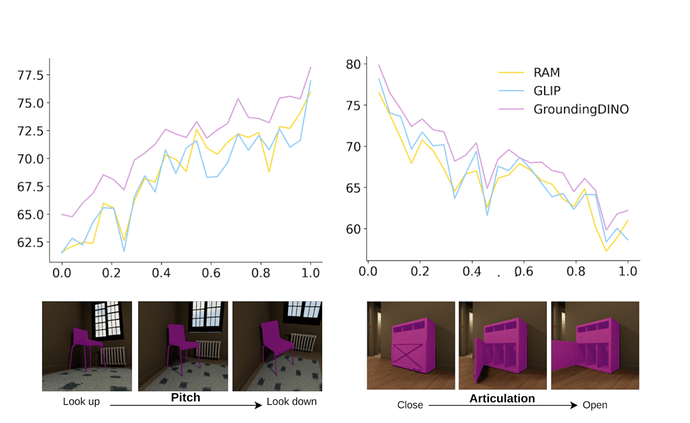

- **评估场景理解模型:**利用全面的标注图像系统评估各种场景理解模型的性能。

- **训练新视觉任务模型:**在合成数据上训练对象状态和关系预测模型,并评估其从模拟到真实应用的迁移能力。

评估和训练结果

研究人员通过实验发现,现有SOTA模型在常见分布之外的数据上的表现仍有不足,BVS有助于评估模型在特定条件下的鲁棒性。

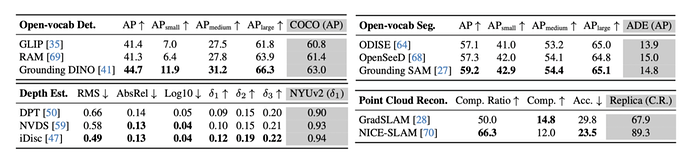

在场景理解模型评估中,BVS生成的高质量数据真实地反映了现实数据,不同任务的预测模型在BVS数据上的表现顺序与在对应任务真实数据基准上的表现一致。

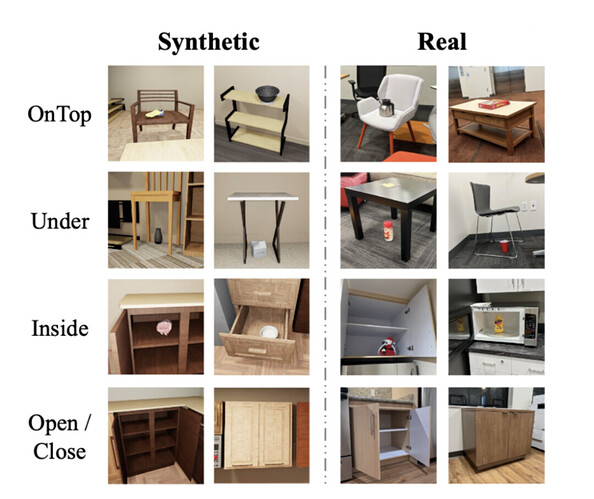

此外,BVS还可用于训练难以在现实场景中收集或标注数据的任务。研究人员利用BVS训练了一个物体空间关系和状态预测模型,在真实场景下仍取得了较好的表现,体现了优秀的仿真到现实的迁移能力。

总结

BVS为计算机视觉研究人员提供了生成定制化合成数据集的新方法。通过系统地控制和调整数据生成过程中的各项参数,研究人员可以更全面地评估和改进计算机视觉模型的性能,为未来的研究和应用奠定坚实基础。

怜星夜思:

原文内容

AIxiv专栏是机器之心发布学术、技术内容的栏目。过去数年,机器之心AIxiv专栏接收报道了2000多篇内容,覆盖全球各大高校与企业的顶级实验室,有效促进了学术交流与传播。如果您有优秀的工作想要分享,欢迎投稿或者联系报道。投稿邮箱:liyazhou@jiqizhixin.com;zhaoyunfeng@jiqizhixin.com

在不久之前的 2024 TED 演讲中,李飞飞详细解读了 空间智能(Spatial Intelligence)概念。她对计算机视觉领域在数年间的快速发展感到欣喜并抱有极大热忱,并为此正在创建初创公司

在此演讲中,曾提到斯坦福团队的一个研究成果 BEHAVIOR,这是他们「创建」的一个用来训练计算机和机器人如何在三维世界中行动的行为和动作数据集。

如今,吴佳俊带领团队发表了后续研究——「BEHAVIOR Vision Suite(BVS)」。论文也获得 CVPR 2024 Highlight。

在计算机视觉领域,系统评估和理解模型在不同条件下的表现需要⼤量数据和全⾯、定制的标签。然⽽,现实世界中的视觉数据集往往难以满⾜这些需求。尽管⽬前的合成数据⽣成器为具⾝ AI 任务提供了有前景的替代⽅案,但在资产和渲染质量、数据多样性及物理属性的真实性⽅⾯,仍存在诸多不⾜。

-

项目链接:https://behavior-vision-suite.github.io/

-

论文链接:https://arxiv.org/pdf/2405.09546

-

代码链接:https://github.com/behavior-vision-suite/behavior-vision-suite.github.io

-

参数可控地评估视觉模型在环境参数连续变化时的鲁棒性:探究模型在不同环境参数(遮挡程度,环境亮度,拍摄角度,物体关节移动,视野)连续变化情况下的表现,例如评估物体检测模型在冰箱门从完全关闭到完全打开过程中,模型能正确检测出存在冰箱的准确率,确保模型在实际应⽤中能够应对各种环境变化。还可以探究模型在不同极限参数条件的能力边界。

-

评估场景理解模型:使⽤拥有全⾯标注的图像,系统评估各种场景理解模型的性能。

-

训练新视觉任务模型:在合成数据上训练对象状态和关系预测的新视觉任务模型,并评估其从模拟到真实应⽤的转移能⼒,确保模型在真实环境中的有效性。

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:content@jiqizhixin.com