Karpathy:Agent十年成熟是事实,然而AI Agent的应用已在当下,工程师迎来新机遇!

原文标题:Andrej Karpathy:Agent 还需十年才能成熟

原文作者:图灵编辑部

冷月清谈:

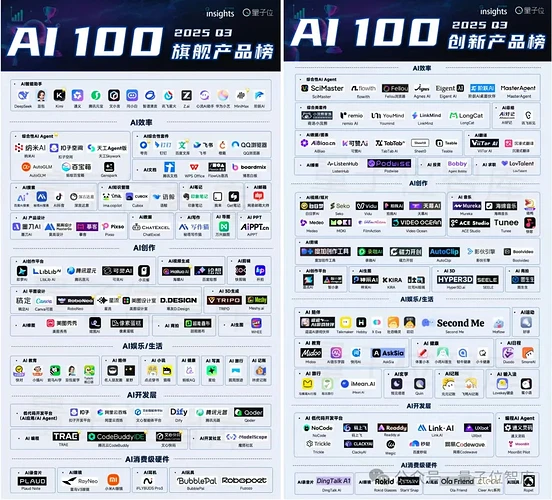

然而,文章强调,在商业落地层面,Agent技术已是“进行时”,应用速度远超预期。量子位智库榜单显示,Agent产品正向系统化智能协作发展,并深度融入科研、投资等行业,解决实际痛点,提升效率。

文章指出,当前(2024-2025年)是Agent工程师的时代,核心在于将大模型嵌入具体场景、设计上下文、编排工具链及评估反馈。它强调“十年成熟”并非“现在不用学”,而是意味着早期入场的巨大机会。

Agent的本质是生产力革命,它能自动化业务流程、完成跨系统任务,对企业和创业者而言是效率提升的关键,对工程师则是一种新的架构思维。

最后,文章呼吁工程师们把握当前Agent工程的红利期,通过学习构建可评估、可扩展、可维护的智能体系统,从“构建未来的工具人”角度出发,成为AI的构建者而非仅仅使用者,并推荐了相关实战训练营。

怜星夜思:

2、文章说2024-2025年是Agent工程师的时代,重点是“嵌入场景、设计上下文、编排工具链调用与评估”。对于刚想入行或正在转型的工程师来说,你觉得这几个能力里,哪个是最容易被忽视但又最核心的?应该怎么培养?

3、随着Agent渗透进各个行业,它“自动化业务流程”、“替代实习生”等能力会带来什么社会影响?对于普通人来说,是会感到“被赋能”还是“被取代”的焦虑更多?你觉得怎么平衡这种发展?

原文内容

近日,OpenAI 创始成员、特斯拉前 AI 总监安德烈 · 卡帕西(Andrej Karpathy)在接受播客节目 “Dwarkesh Patel Show” 采访时畅谈了他对 AGI 时间线、智能体、大模型认知、强化学习等 AI 圈核心问题的看法。

他直言,当前 AI Agent 技术尚处早期,还存在“无法持续学习、非真正的多模态、不能自如操作电脑”等核心缺陷,要实现真正的实用化还需要十年左右。

但如果你细品,会发现卡帕西并不是在唱衰。他只是指出一个事实:当前的 Agent 还没有形成「闭环系统」——缺乏可靠的记忆机制、缺少持续的评估反馈,也没能真正实现长期自主决策。

没错,这在学术定义上完全正确。但换个角度看,在商业落地层面——Agent 已经不是“未来式”,而是“进行时”。

现实中,Agent 已经悄悄发力

就在过去几个月,Agent 的应用速度远超很多人想象:

量子位智库最新发布的 2025Q3 AI100 榜单量子位智库最新发布的 2025Q3 AI100 榜单中的 Agent 产品,在智能体技术优化、应用落地等方面蓬勃发力,越来越像人类的 “AI 伙伴”。

智能体技术演进日趋成熟,从单点智能化工作向系统化智能协作发展,追求更加高效、强大、稳定的任务处理能力,如扩展上下文长度并融合多模态信息深度理解复杂场景任务,云端服务与本地操作系统深度集成,无缝接入用户工作流提供个性化服务。

应用落地呈现从通用工具向行业“智能伙伴”深化的鲜明趋势,嵌入千行百业的业务流程解决特定痛点。例如,科研领域 Agent 助力实现实验流程自动化,投资领域 Agent 为用户提供长周期个性化投资策略组合建议。

这些都不是演示 demo,也不是概念验证,它们实实在在地提升了效率,创造了价值。

所以说,Karpathy 说的没错 —— 要是按 “人类级智能体” 的标准,Agent 还差得远;但从 “能解决实际问题” 来看,它已经在改变各个行业了。

越是冷静期,越是工程师的红利期

如果把 AI 的浪潮分阶段:

-

2018 年:是模型算法研究者的时代;

-

2020~2022 年:是 Prompt 工程师和应用开发者的时代;

-

而 2024~2025 年,正在成为 Agent 工程师 的时代。

你不需要重新发明 GPT,也不需要自己训练模型。 你只要懂得如何:

-

把大模型嵌入具体场景;

-

设计合理的上下文结构;

-

编排工具链调用与评估反馈。

这,就是 Agent Engineering(智能体工程)。它的核心不是“再造模型”,而是让模型能做事。

“十年才能成熟” ≠ “现在不用学”

很多人听到到 Karpathy 的观点,就下意识退了一步:“既然还早,那我再观望一下吧。”

但投资圈有句老话:“风口未起时入场,才有超额回报。”

现在的 Agent 确实还在早期,但这意味着门槛低、机会多。几乎每一家创业公司、每个工程师团队,都能在内部试验 Agent。在这个阶段,只要你能“做出一个能跑的东西”,就已经是很稀缺的能力了。

那么问题来了:该从哪里开始学?

可问题是,很多人并不是不想学,而是不知道该从哪里下手——工具太多、框架太杂、教程太碎。

如果有一门课,能带你从 0 到 1,少踩坑、能实操,那就能迅速打开局面。

这正是「Agent 实战营」存在的意义。

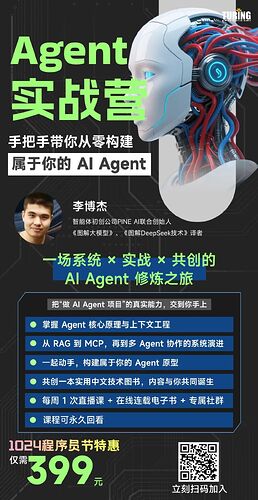

由李博杰老师主讲的「Agent 实战营」,是目前国内少见的、聚焦工程落地的系统课程,超干货。

它不搞那些花哨的技巧,就是帮你从 0 到 1,真正做出能用的 Agent。

🧩 课程亮点

-

9 周时间,从基础到实战,手把手教你构建能跑的 Agent;

-

内容涵盖:上下文工程、RAG 架构、工具调用、评估体系、Agent 流水线设计;

-

你将亲手实现多个实战项目,从「知识问答 Agent」到「多工具决策 Agent」;

-

学完之后,能独立搭建企业级 Agent,直接应用到公司或创业项目中。

李博杰是智能体初创公司 PINE AI 的联合创始人、首席科学家,译有《图解大模型》《图解 DeepSeek 技术》,曾是华为计算机网络与协议实验室副首席专家,入选华为首批“天才少年”项目,博士毕业于中科大与微软亚洲研究院联合培养项目。在 SIGCOMM、SOSP、USENIX ATC、PLDI 等顶会都有论文成果。

更重要的是,他现在每天都在实实在在地做 Agent 系统。这门课教的不是空洞的理论,而是实战中积累的经验和避坑技巧。

为什么说这是“创业者和工程师”的必修课?

因为 Agent 的本质不是“学术突破”,而是生产力革命。

在企业中:

-

它能自动化业务流程;

-

能结合 API 完成跨系统任务;

-

能像实习生一样帮你跑流程、查数据、做初步判断。

对创业者来说,Agent 能让效率大大提升; 对工程师来说,Agent 是一种新的架构思维; 对整个行业来说,它是继 Web、App、GPT 之后的又一次重构浪潮。

学习 Agent,不是为了追风,而是为了“构建未来的工具人”

冷静想想,Karpathy 的那句“十年成熟”其实更像是提醒——“我们需要更好的系统工程能力。”

这正是「Agent 实战营」要培养的核心:让你学会搭建可评估、可扩展、可维护的智能体系统。

因为最终能留下来的,不是那些拼命蹭概念的人,而是那些真正能让模型做事的人。

最后想说

Agent 不是用来炫技的,而是默默提供帮助的 “隐形助手”。它不会一夜之间改变世界,但它正在改变每一行代码、每一个流程。

如果你希望未来五年,不只是会用 AI,还能构建 AI,现在,就是最好的入局时机。

现在就扫码加入 “Agent 实战营”,让你的下一个项目,不只是调用模型,而是让模型真正 “行动” 起来。