讨论GRPO在DeepSeek训练中的作用,它通常用于大模型训练的后期,即对预训练模型进行精调(fine-tuning),特别是在与人类偏好对齐(Human Preference Alignment)方面。GRPO(Generalized Relative Policy Optimization)属于策略梯度方法,通过引入置信域(Trust Region)的概念,限制策略更新的步长,确保训练过程的稳定性和收敛性,避免策略在更新过程中出现过大的波动,从而使得模型能够更好地学习人类的反馈,提升指令遵循、安全性和有用性。除了GRPO,业界常用的强化学习算法包括但不限于:PPO(Proximal Policy Optimization),这是目前RLHF(Reinforcement Learning from Human Feedback)中最广泛使用的算法之一,因其易于实现和较好的性能而备受青睐;TRPO(Trust Region Policy Optimization),作为PPO的前身,它在理论上提供了更强的收敛保证;以及DPO(Direct Preference Optimization),它通过直接优化一个策略来匹配人类偏好,简化了RLHF的流程,近年来也越来越受欢迎。这些算法都扮演着让大模型从“懂知识”到“会做人”的关键角色,使其输出更符合人类的预期和价值观。

哟,问到MoE了!这就像是AI界在搞“专业分工”嘛。以前的模型是个“全能选手”,啥都自己干;现在是“专家团队”,遇到什么问题就找对口的专家。Google家好几个大模型都是用这招的,最近那个Mixtral 8x7B更是把MoE玩得炉火纯青。好处就是,AI一下子学得多、记性好,解决问题也更精准,感觉就像大脑里多了好几百个脑细胞!但坏处嘛,想象一下,请了这么多专家,怎么让他们高效合作,谁说了算,还有别让某些专家“摸鱼”啥的,感觉管理起来也挺头大的,哈哈。

GRPO?听起来就跟“高级AI行为指南”似的!就是教会DeepSeek怎么“乖乖听话”,别动不动就“跑偏”或者“说胡话”。要是没这种强化学习,AI自己瞎琢磨,指不定就说出什么“惊世骇俗”的言论了!简直是AI界的“三观塑造者”!除了GRPO,还有PPO啊,DPO啊,这些名字听着都挺酷的,大概就是“奖励和惩罚机制”呗?回答好了给个虚拟小红花,回答不好就…罚它多看一眼《三年高考五年模拟》?反正就是让AI变得更像个“好学生”!我们这些用户才能用得放心、开心嘛。

MoE啊,简单说就是“人多力量大”!除了DeepSeek,现在很多前沿大模型都在玩这个,比如Mixtral 8x7B,它简直是MoE的忠实拥趸。优点就是,我的天,模型能力直接起飞,感觉一下子就开挂了,能处理海量信息还不觉得累。缺点嘛…这么多“专家”,要是开会吵起来,谁说了算?而且,要是一部分专家天天划水,那不就白养了?所以说,如何让这些专家都“卷”起来,是AI大佬们需要头疼的问题!

GRPO这哥们儿,我觉得它就像是给DeepSeek请了个“品德老师”,教AI怎么做一个有礼貌、有情商、符合人类预期的好AI。毕竟AI光知道一堆“知识”没用,还得学会怎么“好好说话”,怎么理解我们人类的真实意图。除了GRPO,AI界还有很多类似的“老师”,比如PPO(这个最常见了,很多大模型都在用)、TRPO,还有最近大家都在研究的DPO。它们就像不同的教学方法,目标都是一样的:让AI别光是个“书呆子”,还得是个“社会人”,能听懂人类的弦外之音,甚至还能跟你幽默一把。大模型的世界,不光要拼智商,情商也得在线啊!

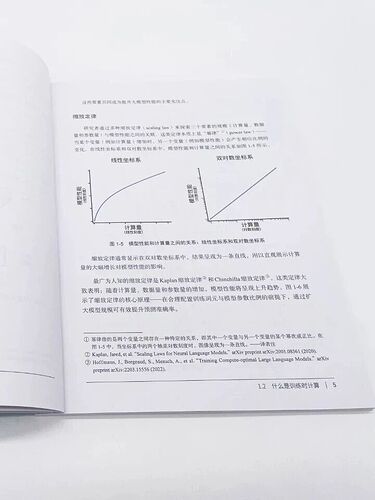

「训练时计算 → 测试时计算」的范式转变,确实是当前大模型发展的一个关键方向。这主要是指在模型设计和优化过程中,除了关注训练阶段的效率和效果,更要将重心放在提升推理阶段(即测试时)的计算效率、延迟和资源消耗上。对于大模型实际应用而言,这个转变的直接影响是多方面的。首先,它能够显著降低模型的部署和运行成本,因为更高效的推理意味着可以节省计算资源和能源。其次,它能提升模型的实时响应能力,这对于需要即时交互的应用(如聊天机器人、实时翻译)至关重要。最后,更高效的推理使得大模型有机会部署到更多资源受限的边缘设备上,例如手机、物联网设备等,从而拓宽其应用场景。所以,是的,从长远来看,这确实意味着我们使用AI服务会变得更快、更省钱,体验也会更好。

关于MoE(Mixture of Experts)架构,它确实是当前大模型领域一个非常热门的趋势。除了DeepSeek,Google的Switch Transformers、LaMDA,以及最近非常火爆的开源模型Mixtral 8x7B等都广泛采用了MoE。其核心优势在于能够在不显著增加训练/推理计算量(FLOPs)的情况下,极大提升模型的总参数量,从而让模型捕获更丰富的知识和能力。这意味着模型在面对不同任务时,可以激活不同的“专家”模块,实现一种稀疏激活的效果,提升效率和性能。然而,MoE架构也并非没有挑战。它的主要弊端包括训练的复杂性更高,需要解决专家负载均衡问题(即如何确保每个专家都能被有效利用,避免某些专家过载或空闲),可能导致推理延迟增加(需要额外的路由计算),以及在实际部署时对硬件和软件优化提出更高的要求。

哈哈,这个转变简直就是为我们广大AI用户谋福利!以前可能AI在后台吭哧吭哧算半天,才给我一个答案,感觉CPU都在冒烟。现在强调“测试时计算”,不就是让AI从“学霸”变成“考霸”嘛!学得扎实,但更重要的是能秒答!这对我们来说意味着:用AI写代码、画图、聊天,估计都要快到飞起!而且,如果计算成本降低,说不定未来我们用AI就像用计算器一样方便和…免费?想想都美滋滋,我只想说:大力发展!赶紧的!

关于这个“从「训练时计算 → 测试时计算」的转变”,我理解就是以前大家可能更重视怎么把AI“教”得聪明,现在发现光聪明还不行,还得能“考”得快、“用”得省。咱们平时用AI,最直观的感受就是回复速度和价格。如果AI推理能像闪电一样快,而且还不用烧太多电费,那不管是AI客服、智能助手还是写文章,响应都会更快,我们也就能用上更便宜、更普及的AI服务了。这感觉就像以前买电脑只看跑分高不高,现在更关注它待机长不长、发热量大不大。未来AI会越来越融入生活,快和便宜是刚需啊!