创智Deep Cognition:AI从工具到认知伙伴,每次收藏都为AI积累智慧,实现人机共同进化。

原文标题:创智「小红书」震撼上线,让AI从效率工具进化为认知伙伴

原文作者:机器之心

冷月清谈:

怜星夜思:

2、文章提到AI会学习用户的“收藏”内容,来提升自己的认知。这是否意味着用户在平台上的所有学习偏好和认知积累,都会被AI掌握?长远来看,这种“认知伙伴”模式对个人数据隐私和AI伦理会带来哪些新的挑战和机遇?

3、“交互即智能”的理念非常超前,但目前Deep Cognition主要围绕科研和信息提取场景展开。这种模式在艺术创作、情感交流或者更复杂的社会互动等非结构化领域,是否也能有效应用?它的局限性在哪里?

原文内容

我们似乎正处在一个“收藏即掌握”的时代。

不管是知乎、论文库,还是小红书,只要看到一句金句、一篇好文、一个值得学习的案例,我们的第一反应往往是点个收藏,留着以后看。然而,我们真的会“回头再看”吗?

让我们先来看一个令人震惊的统计:

-

📚 知乎收藏:平均每人收藏文章 547 篇,实际回看率仅 3.2%;

-

📖 论文收藏:研究生平均收藏论文 284 篇,深度阅读率不足 12%;

-

🎨 小红书收藏:用户平均收藏内容 1,203 条,二次浏览率仅 1.8%。

你收藏夹里有多少吃灰的链接?你今天阅读了 50 篇论文,都消化掉了吗?

这背后反映的残酷现实是:

-

❌ 输入 ≠ 努力:看了不等于学了;

-

❌ 收藏 ≠ 拥有:存了不等于会了;

-

❌ 思考 ≠ 积累:想了不等于留了。

如果有一个平台,让你像刷小红书一样轻松,但每一次浏览与收藏都是给自己的认知 + 1,每一次思考都能和 AI 共同进化呢?上海创智学院发布创智 "小红书"(Deep Cognition)—— 全球首个可以主动构建认知并且让认知真正积累的 AI 平台,一个可以创造智慧的小红书!

「线上体验」:https://opensii.ai/

信息过载的时代,如何识别高价值的洞见、认知是无数人的痛点需求。在创智 "小红书" 中,每一张卡片都承载着一条最新的认知洞察。这里汇聚着数据驱动的洞察,将最新研究的核心发现以直观的方式呈现;凝聚着理论突破的精华,用简洁明了的表达诠释复杂深奥的理论;沉淀着实践智慧的结晶,通过经验总结完成知识的深度萃取。

点击体验一个具体的 “认知卡片” 实例:https://www.opensii.ai/share/cognition/6874a6d69382ee3ddd828b77

为什么 "收藏认知" 会提高你 AI 的认知?

通过下面这个例子,我们来看,如何实现” 你的每一次浏览与收藏,你的 AI 模型认知都会随之增加 ”。

具体来说,用户日常刷认知收藏的所有认知,AI 都会默默学习记录下来,习得该认知内容。下一次你和 AI 对话的时候,AI 会带着这些最新认知去思考问题,以及与你互动。因此,每一张卡片,都是思考提炼的认知,每一次收藏,都是认知资产的积累。“收藏” 这个操作已经被赋予了更多的价值,当你实在没有时间仔细阅读的时候,点击 “收藏”,至少你把属于你的 AI 模型认知提高了,下一次 AI 可以更好的帮助你解决问题。

例如,询问如下问题:

随着大模型在 context engineering 方面的能力提升,它们开始具备处理多轮对话、长期任务和研究语境的能力。我们该如何构建一个可以持续参与科研过程、协同解决问题,真正成为 “AI 科学家同事” 的智能代理?

当你向系统提出这个关于 "AI 科学家同事" 的问题时,系统会自动搜索你之前收藏过的相关认知卡片。

AI 会综合这些你曾经收藏的认知资产,结合最新的技术理解,给出个性化的回答:

"基于你之前关注的多智能体框架和长期记忆机制,我建议构建一个具备以下能力的 AI 同事系统:1)持续学习你的研究偏好和工作习惯;2)维护项目上下文的长期记忆;3)主动提出研究假设和实验设计;4)具备跨任务的知识迁移能力..."

这样,你的每一次收藏都在为未来更精准的 AI 对话做准备,真正实现了 "收藏即学习,对话即智慧"。

通过这样的方式,将认知系统化构建以及平台化,还可以获得其它许多独一无二的功能:

1. 认知榜单 & 周报总结

展示本周热门认知话题排行榜(如评估指标、基准测试、人工标注等)以及社区学习动态总结

2. 特色功能:认知个性化订阅 & 分享

根据自己专注的技术领域(如机器学习、数据科学等)和领域名人收藏专属的认知内容,并与社区分享。

3. 特色功能:认知合成

认知合成将分散的观点思维融合,形成新的深度理解和认知。

创智 “小红书” 背后的技术原理是什么?

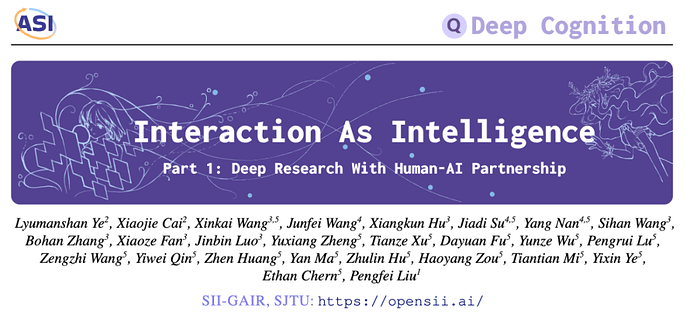

创智学院同时也公开了相关的技术论文《交互即智能》,揭示了人机协作关系的变革。

-

论文题目:Interaction as Intelligence: Deep Research With Human-AI Partnership

-

论文地址:https://arxiv.org/pdf/2507.15759

-

项目首页 / 试用网址:https://opensii.ai/

具体来说,创智 "小红书" 所解决的认知积累问题,实际上揭示了当前人机交互模式的根本性缺陷。认知无法积累的表面原因是平台设计问题,但深层原因是 AI 仍停留在 "效率工具" 阶段,而非 "认知伙伴"。

传统的 "效率工具" 模式采用 "存储 - 检索" 逻辑:用户负责收藏和存储信息,平台负责保存和检索内容,认知处理完全依赖人类大脑的记忆和联想。这种模式的根本问题在于:它将人和机器割裂开来,把认知处理的重担完全推给了人类。用户在信息过载中疲于奔命,AI 系统却只能被动响应,无法主动参与认知的构建和积累过程 [2],在完成长复杂任务的过程中,往往会带来错误积累 [3, 4]。

该技术论文指出,当前的假设根本上误解了智能本身的性质,互动本身构成了智能的基本维度。未来,人与 AI 交互的范式将从最小化人类参与的 “效率工具” 模式,进化为 “认知伙伴” 关系。

该工作定义了一种新范式 “交互即智能(Interaction as Intelligence)”,论文提出了一个根本性的重新认知:智能 —— 无论是人类还是人工智能 —— 本质上都是交互式的、情境化的、协作的。最复杂的人类思维很少孤立发生,而是通过对话、反馈、精化和多元视角整合而涌现。

正如论文开篇引言所述:

"智能不是孤立心灵的属性,而是在心灵之间的舞蹈中涌现的。问题不在于各个组件有多聪明,而在于它们如何精彩地交互。"

基于 "交互即智能" 的理论基础,该工作提出了认知监督(Cognitive Oversight)这一全新的人机协作范式。它将人类从被动的工具操作者转变为主动的认知协作者,与 AI 形成真正的智能共同体。

从 “刷认知” 到 “使用认知” -

Deep Cognition 系统

创智 "小红书" 作为认知平台,与深度研究系统形成完美的理论 - 实践闭环,形成了 Deep Cognition 系统,可以不仅进行认知学习,还可以用习得的认知去解决高价值场景复杂的问题。具体来说:

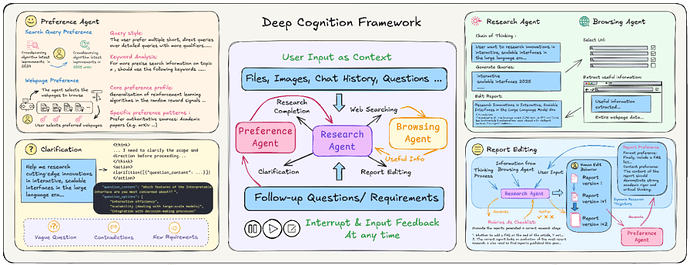

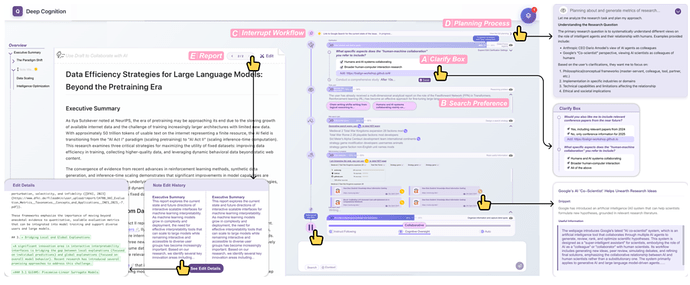

一、深度研究系统:多智能体协同认知框架

1. 研究智能体(Research Agent)研究智能体作为系统的核心大脑,能够接收多模态输入并采用 "交替思考 - 行动" 的先进方法进行深度推理,集成了 o1、DeepSeek-R1、Claude Sonnet 4 等最先进的推理模型,确保研究过程的严谨性和前沿性。

2. 浏览智能体(Browsing Agent)浏览智能体则充当系统的感知器官,通过智能 URL 选择、并行网页抓取和基于 LLM 的质量评估,为研究提供高质量的信息支撑,同时过滤噪音和无关内容。

3. 偏好智能体(Preference Agent)是整个框架的学习中枢,基于上下文强化学习(ICRL)范式,持续学习和适应用户的个性化偏好。它跟踪用户在查询、网页浏览和报告生成三个维度的行为模式,将每一次用户交互转化为优化系统性能的宝贵信号。

深度研究系统具备如下强交互特性:

-

特征一:透明的研究过程:界面通过多种机制建立透明度,使用户可以看到和理解系统的决策过程。通过直接展示模型的推理过程和生成的查询词,搜索策略的可解释性得以支持。界面左侧的编辑器显示不断演进的研究文档,并提供 “编辑” 按钮允许用户直接修改。所有发现都恰当地链接回原始来源,方便用户追溯。

-

特征二:实时干预:系统实现了一个 “暂停” 功能,使用户在整个研究过程中保持控制权。用户可以在任何时刻中断系统,包括在显示 “正在分析技术突破,请参考...” 等进度指示时。

-

特征三:细粒度交互:当用户提出模糊的研究问题时,界面会弹出一个澄清框,提出有针对性的问题以帮助缩小范围,就像研究馆员在问 “您具体在找什么?”。用户可以优先选择偏好的搜索查询,并指定希望重点关注的特定网页或知识来源。

-

特征四:用户研究偏好自适应:系统在多个维度上适应用户的偏好和要求,提供个性化的研究辅助。系统会根据用户的历史数据和选择生成参考画像,从过去的交互中学习,以更好地匹配个人的研究方法。随着研究目标的演变,系统能在不丢失先前交互上下文的情况下适应新的需求。

该系统体现透明度、细粒度、实时交互特性的 Multi-Agent-Human 协作机制设计。

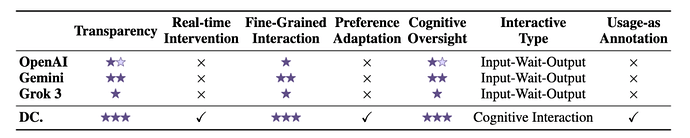

对比 Deep Cognition 和主流深度研究系统的创新点。

二、认知平台系统:创智 "小红书"

创智 "小红书" 作为认知平台系统,是 Deep Cognition 从理论研究走向实际应用的关键桥梁,它将复杂的 AI 研究能力转化为用户友好的认知服务体验。

4. 认知卡片生成引擎:认知卡片生成引擎是平台的核心创新,它能够自动将深度研究系统产生的复杂成果转化为结构化、可视化的认知卡片,每张卡片都承载着经过精心提炼的核心洞察、关键数据和重要结论,并配备可视化的知识图谱和思维导图,让复杂的研究成果变得易于理解和吸收。

5. 认知积累机制:认知积累机制则是平台的智能推荐系统,它基于用户的行为数据驱动个性化推荐,通过认知关联度的智能算法组织卡片内容,实现认知资产的复利增长效应,确保用户的每一次学习都能在现有认知基础上产生价值叠加。

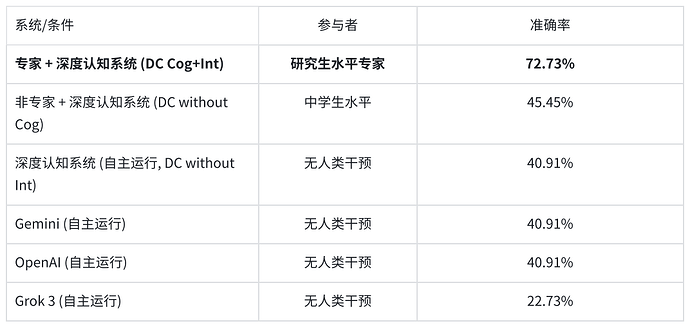

实验 1:量化验证认知监督的威力

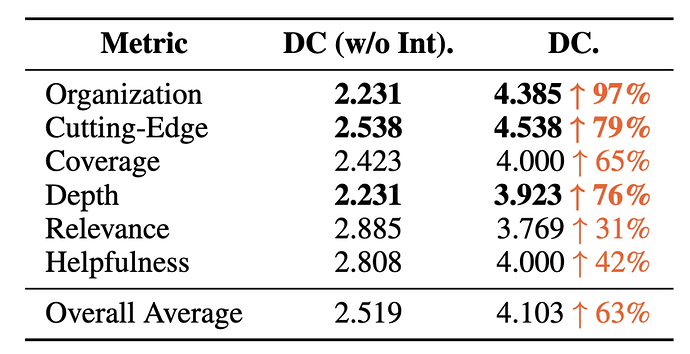

为了衡量 “交互” 本身所带来的价值,研究进行了一项关键的消融实验:将具备完整功能的 “深度认知”(Deep Cognition,DC)系统与一个移除了交互模块、只能以 “输入 - 等待 - 输出” 模式运行的版本(DC non-interaction)进行对比。结果是惊人的,如下表所示,交互的引入带来了全方位的、巨大的质量提升 [1]。

数据显示,交互的引入使得最终报告的平均质量提升了 63%。其中,提升最为显著的是报告的 “组织性 (Organization)”(+97%)、“前沿性 (Cutting-Edge)”(+79%)和 “深度 (Depth)”(+76%)。这一结果有力地证明了研究的核心论点:最大的性能飞跃并非来自一个更强大的底层模型,而是来自一个更优越的交互范式。当用户能够实时引导、修正和注入知识时,AI 生成的最终成果质量发生了质变。

表 1:交互对报告质量的提升效果(DC vs. DC without interaction)

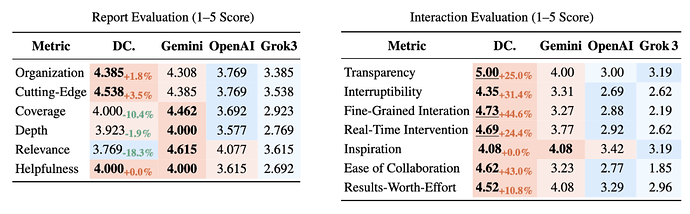

在与当前市场领先的商业深度研究系统(Gemini, OpenAI, Grok)的直接对比中,“深度认知” 系统同样展现出全面的优势。评估从两个维度展开:一是用户对最终报告质量的主观评分,二是用户对交互过程体验的评分 [1]。

左图:专家用户针对专业领域科研问题,对最终报告质量的评分对比(本系统 vs Gemini/OpenAI/Grok);右图:各系统交互体验评分。

专家用户对系统交互功能各项指标的评价结果分布,各功能都获得了用户的高度认可。

在交互体验方面,“深度认知” 系统在七项评估指标中的六项上占据主导地位。尤其是在体现其核心设计理念的指标上,优势尤为突出:

-

透明度 (Transparency): 获得了完美的 5.00 分,比表现最好的竞品高出 25.0%。

-

细粒度交互 (Fine-Grained Interaction): 获得了 4.73 分,领先优势高达 44.6%。

-

协作性 (Cooperative): 获得了 4.62 分,领先优势达到 43.0%。

这些数据表明,该研究不仅在理论上是先进的,其最终实现的产品也为用户带来了更具协作感和可控性的使用体验。

实验 2:"专家思维放大" 效应:

这项测试要求系统在复杂的网络环境中寻找难以发现的信息,极大地考验了系统的推理和执行能力。研究结果清晰地揭示了 “认知伙伴关系” 的巨大威力。

表 2:BrowseComp-ZH 基准测试准确率对比 [1]。DC (cog+int.) 指与研究生级用户实时交互协作的模式;DC (non int.) 指无人干预的自主模式。

这一结果堪称深度研究领域的 “半人马时刻”(Centaur moment),它呼应了当年国际象棋比赛中,人类棋手与 AI 程序组成的 “半人马” 团队击败最强超级计算机的历史性事件 。数据揭示了几个关键事实:

1. 协作远胜单打独斗: “专家 + AI” 组合的 72.73% 准确率,远高于任何一个独立运行的 AI 系统(最高约 41%)。

2. 专家知识是关键: 同样的系统,在专家手中(72.73%)和在非专家手中(45.45%)的表现差异巨大。

3. 交互是释放专家潜能的钥匙: 即使是 “深度认知” 系统,在没有人类交互的情况下自主运行时,其表现也仅与普通商业 AI 持平(40.91%)。

这组数据背后隐藏着一个深刻的价值主张。它表明,当前主流的自主型 AI 工具,实际上正在浪费其最有价值的资源 —— 人类专家的智慧。一个独立运行的 AI 在复杂任务上可能只有 41% 的成功率,这意味着它在多数情况下是失败的。然而,当同一个任务交由一位专家使用 “深度认知” 系统来完成时,成功率跃升至近 73%。这之间大约 32 个百分点的巨大差距,就是被 “深度认知” 框架所释放和放大的、专家的认知价值。

因此,这项研究的真正价值主张并非简单地宣称 “我们的 AI 更强”,而是 “我们的系统让您的专家变得更强”。它将 “认知伙伴关系” 和 “互补性” 这些抽象概念,用一个具体、可量化的性能指标呈现出来,这对于任何依赖专家知识进行决策的组织或个人而言,都具有无与伦比的吸引力。这正是系统在 “投入产出比”(Results-Worth-Effort)指标上同样领先的原因。

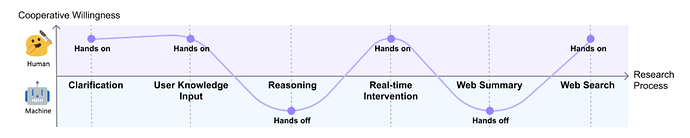

实验 3:人机回环:解密「动态自主性」

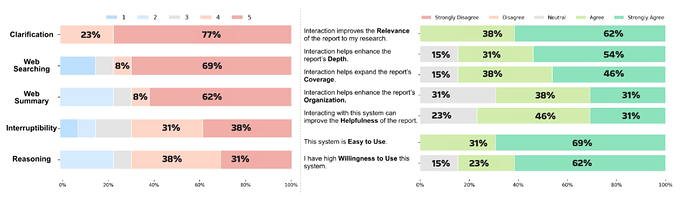

该研究中关于人类行为的定性发现揭示了用户在与高度交互式 AI 协作时所表现出的复杂模式,展示了该系统设计对人类认知习惯的深刻理解。

超越开关模式:人机交互的战略性舞蹈

研究发现,高效的人机协作并非一种恒定的、高强度的互动状态。相反,用户会根据任务的不同阶段和认知需求,在 “亲力亲为”(Hands-on)和 “放手信任”(Hands-off)两种模式之间进行动态、战略性的切换。研究将这一现象概括为 “动态自主性”(Dynamic Autonomy)。

这种模式的发现,本身就是对传统人机交互设计理念的一次重要超越。它表明,用户的需求不是一个简单的 “开 / 关”—— 要么完全控制,要么完全放手。真实的需求是一种灵活的、可调节的控制权分配。

认知协作的六个阶段

通过对用户行为的细致观察,研究将复杂的深度研究过程分解为六个不同阶段,并清晰地描绘出用户在每个阶段的协作意愿变化,如上图所示 :

亲力亲为(Hands-on) - 人类智慧主导

1. 问题澄清 (Clarification): 在研究初期,面对模糊、开放式的问题,用户会高度参与,与 AI 一同迭代、细化研究范围。例如,参与者 P1 最初提出宽泛问题后,会主动补充具体技术方向,并认为 AI 提出的澄清问题 “包含了自己未曾想到的方面” (1)。这是人类战略性思维和框架构建能力发挥最大价值的时刻。

2. 专家知识注入 (User Knowledge Input): 当用户拥有明确的领域知识、特定的参考文献或个人见解时,他们会再次高度介入,主动引导 AI 关注关键信息源。

3. 实时干预 (Real-time Intervention): 在 AI 浏览信息的过程中,当用户发现有价值或存在偏差的内容时,会立即介入,调整 AI 的行为以符合预期。

4. 网络搜索 (Web Search): 对于需要主观判断或开放式解读的问题,用户同样倾向于亲身参与,因为这类任务对现有工具最具挑战性。

放手信任(Hands-off) - AI 能力主导

5. 推理过程 (Reasoning): 有趣的是,在 AI 进行内部推理和分析时,用户的协作意愿反而降低。他们更倾向于退后一步,观察 AI 如何自主处理指令,并评估其决策的透明度和质量。如 P12 所述,他们希望看到 “模型在面对开放问题时如何决定关键技术路线” 。

6. 网页摘要 (Web Summary): 在需要对大量信息进行整合与摘要时,用户表现出对 AI 自主性的高度信任。他们需要的是经过 AI 处理后的综合性见解,而非原始信息的堆砌,因此愿意让 AI 长时间自主运行。

这一 “动态自主性” 模型的提出,为设计更高效、更少挫败感的人机协作系统提供了一份宝贵的蓝图。当前 AI 助手的一个常见设计缺陷,是它们往往强迫用户接受一种单一的交互模式:要么需要用户进行繁琐的微观管理,要么就提供极少的控制权,让用户感到失控 。该研究通过对用户真实行为的观察发现,用户真正需要的不是一个固定的控制级别,而是在不同认知子任务间灵活切换控制权的能力。

例如,在需要创造性、发散性思维的 “问题澄清” 阶段,用户渴望 “亲力亲为” 的主导权;而在需要机械性、收敛性处理的 “网页摘要” 阶段,用户则乐于 “放手信任”,将任务委托给 AI。这一发现的设计启示是深刻的:未来的 AI 系统不应预设一种最佳交互风格,而应被设计成能够支持这种控制权动态转移的平台。这意味着,系统需要为高参与度阶段提供强大、易用的控制工具,同时为低参与度阶段提供稳定、值得信赖的自动化能力。

总结

Deep Cognition 和创智 "小红书" 进一步证明:AI 的价值不再只取决于参数规模,而是认知深度。而认知深度的实现,需要人机之间的深度交互和协作,更需要从 "效率工具" 向 "认知伙伴" 的根本性转变。

创智 "小红书" 开启的不仅是一个产品,更是一个时代:

-

认知民主化:让每个人都能轻松积累和分享智慧

-

智慧社会化:构建基于认知共享的新型社会关系

-

文明加速化:推动人类认知水平的整体跃迁

当认知成为可积累、可分享、可增值的资产,当交互成为智能本身,当 AI 从工具进化为伙伴,我们正在重新定义人类与 AI 共同进化的未来。

参考文献:

[1] Interaction as Intelligence: Deep Research With Human-AI Partnership

[2] "help me help the ai": Understanding how explainability can support human-ai interaction

[3] Why do multi-agent llm systems fail?

[4] Ironies of automation

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:[email protected]