DCE这类多专家系统确实在部署时面临资源挑战。核心在于专家数量、模型复杂度和动态选择器的开销。理论上,更多专家意味着更大的参数量和推理延迟。在资源受限场景,可能需要进行模型蒸馏、剪枝或量化等优化,将大型模型压缩为轻量级版本,或者采用非同步推理架构。对于小型企业,如果没有高配GPU支持,直接部署原文描述的SOTA模型可能会比较困难,需要综合考虑性能与成本的平衡。

增量学习这个概念,听起来就很有“生命力”,符合我们人类学习的模式。我觉得只要是跟“时间”和“变化”挂钩的场景,都离不开它。

甚至可以引申到语言模型,比如ChatGPT这样的,它也得时不时地学习新的词汇、新的流行语,甚至新的知识点,但不能因为学了新的就把以前的给忘了。而某些特定领域(比如小语种、专业术语)的数据可能本身就很少,这就成了典型的“不平衡”问题,所以DIL在这个领域估计也有用武之地。

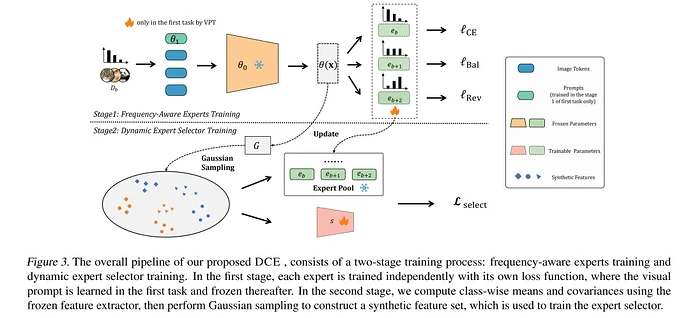

处理数据不平衡,就像治大锅饭里的“偏食”问题。有人喜欢吃肉(多数类),有人喜欢吃菜(少数类),长期下去肯定营养不良(模型性能差)。DCE这种“频率专家”,就好比针对不同食材(数据频率)请了不同的厨师,各管一摊,确保每种食材都能被处理好。而“平衡高斯采样”,我觉得像是在食材不足时,用科学方法“合成”一些仿真食材,保证你的模型有足够的“营养”来学习。

至于其他方法,就像有人会说“多吃点肉”(过采样),有人说“少吃点菜”(欠采样),或者“偏食就打PP”(代价敏感),方法很多,但没有银弹。在增量学习里,挑战更大,因为你还得考虑“吃新饭不忘旧饭香”的问题,这可太难了!

吃不吃资源?肯定吃啊!这就像请了一堆“专家”来帮你分析问题,每个人都要吃喝拉撒(算力、内存),还得有个“总管”(动态选择器)来协调。你想想,是请一个全能型选手省钱,还是请一屋子术业有专攻的专家省钱?当然,专家多了准确率肯定高。但对于一般项目来说,除非你对准确率有极致要求,或者你家矿多,否则还是得掂量掂量。或许未来会有更轻量级的DCE变种出现呢。

“不平衡”这个问题,简直是炼丹师的噩梦!你花大价钱搞了个模型,结果一到真实环境,那些“稀有物种”它就认不出来,或者认错得离谱。我以前也遇到过。除了DCE这种“请专家会诊”的高级招数,最简单的就是“加量不加价”——把少的样本复制几份(过采样),或者“抽丝剥茧”——把多的样本挑着删掉一些(欠采样)。但这些简单粗暴的方法在增量学习里,如果操作不好,很容易让模型把旧的“大头”特征给忘了,或者学偏了。所以DCE这种用“伪特征”来引导学习器,同时又用专家来细分频率,感觉是更精细化的操作。

这简直是AI落地的“日常”啊!除了文章提的,我想到的有几个:

* 自动驾驶: 道路环境、交通规则、天气状况都是动态变化的。模型需要不断学习新的路况(比如最近修路了,或者有了新的交通标志),同时不能忘了以前学过的正常行驶规则。如果某个地区特殊情况样本太少,那不平衡问题就来了。

* 网络安全入侵检测: 攻击手段层出不穷,每种新型攻击一开始样本肯定很少,但危害巨大。旧的攻击还在发生,新的又要学,DIL在这里简直是刚需,而且对“不平衡”异常敏感,误报漏报都很麻烦。

* 智能制造: 生产线上的设备故障模式、产品质量缺陷可能随着设备老化、工艺调整而变化,需要模型持续学习新的异常情况。

哈哈,问到点子上了!这种“专家组”听起来就很高大上,但实际落地可能就是个资源黑洞。想想那些动辄上百亿参数的大模型,它们训练一次的电费都够普通人好几个月工资了。DCE具体没说专家组数量,但哪怕是几个,外加一个复杂的选择器,实时推理的延迟和算力消耗肯定不小。个人开发者想玩估计得靠租GPU云,小型企业则要掂量下ROI,毕竟不是所有场景都非得用SOTA,有时候“够用”比“最好”更重要。

处理数据不平衡确实是机器学习中的一个核心挑战,尤其是在增量学习背景下。除了文章提到的“频率感知的专家组”和“平衡高斯采样”来合成伪特征,常见的宏观策略包括:

1. 数据层面:

* 过采样(Oversampling): 如SMOTE(Synthetic Minority Over-sampling Technique)及其变种,通过插值等方式生成少数类新样本。

* 欠采样(Undersampling): 随机或启发式地减少多数类样本。

* 混合采样: 结合过采样和欠采样。

2. 算法层面:

* 代价敏感学习(Cost-Sensitive Learning): 通过调整损失函数或分类器阈值,对少数类别分类错误施加更高的惩罚。

* 集成学习: 比如利用Bagging或Boosting思想,针对不平衡数据进行模型融合,如EasyEnsemble、BalanceCascade。

在增量学习中,特别需要注意如何平衡对旧知识的保留(避免灾难性遗忘)与对新知识、尤其是新领域中少数类别知识的学习。合成伪特征和专家组这种思路,正是试图在“保留”和“适应”之间找到平衡点。

“领域增量学习”在动态行业中应用前景广阔,特别是那些数据分布随时间显著变化的领域。例如,在金融风控中,欺诈模式和用户行为不断演变,旧的反欺诈模型需要持续学习新的风险特征并适应新的欺诈手段,同时不能忘记历史的欺诈模式,这里就可能出现“新模式少、老模式多但分布变化”的场景。医疗诊断也类似,新的疾病变种、药物副作用、治疗方案等会不断涌现,诊断模型需要增量学习这些新知识,同时保持对常见疾病的准确判断。此外,推荐系统也在不断面对用户兴趣漂移和新增商品的问题,也属于DIL的应用范畴。