智源发布 OmniGen2,一键解锁 AI 绘图新体验!支持文本生成图像、图像编辑等多种任务,模型权重、代码和数据全面开源。

原文标题:智源新出OmniGen2开源神器,一键解锁AI绘图「哆啦 A 梦」任意门

原文作者:机器之心

冷月清谈:

怜星夜思:

2、OmniGen2 全面开源模型权重、训练代码及训练数据,这对AI图像生成领域会带来哪些影响?

3、OmniGen2 引入的 OmniContext 基准,专门用于评估个人、物体和场景的一致性。你认为在AI图像生成领域,这种一致性评估的重要性体现在哪些方面?

原文内容

2024 年 9 月,智源研究院发布了统一图像生成模型 OmniGen。该模型在单一架构内即可支持多种图像生成任务,包括文本生成图像(Text-to-Image Generation)、图像编辑(Image Editing)和主题驱动图像生成(Subject-driven Image Generation)。用户仅需使用多模态的自然语言指令,便可灵活实现上述功能,无需依赖额外的上下文提示、插件或预处理模块。凭借其功能的高度通用性与架构的高度简洁性,OmniGen 一经发布便获得社区的广泛好评。随后,随着 Gemini 2.0 Flash 和 GPT-4o 等闭源多模态模型的相继发布,构建统一图像生成模型成为当前最受关注的研究与应用方向之一。

在这一背景下,OmniGen 迎来重大技术升级,正式发布 OmniGen2。新一代模型在保持简洁架构的基础上,显著增强了上下文理解能力、指令遵循能力和图像生成质量。同时,OmniGen2 全面继承了其基座多模态大模型在上下文理解与生成方面的能力,同时支持图像和文字生成,进一步打通了多模态技术生态。同时,模型权重、训练代码及训练数据将全面开源,为社区开发者提供优化与扩展的基础。这些特性都将推动统一图像生成模型从构想向现实的转变。

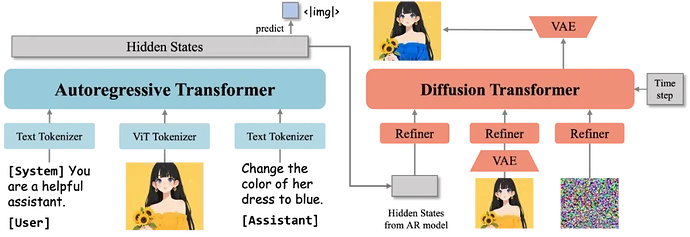

1. 分离式架构 + 双编码器策略

OmniGen2 采取了分离式架构解耦文本和图像,同时采用了 ViT 和 VAE 的双编码器策略。不同于其他工作,ViT 和 VAE 独立作用于 MLLM 和 Diffusion Transformer 中,提高图像一致性的同时保证原有的文字生成能力。

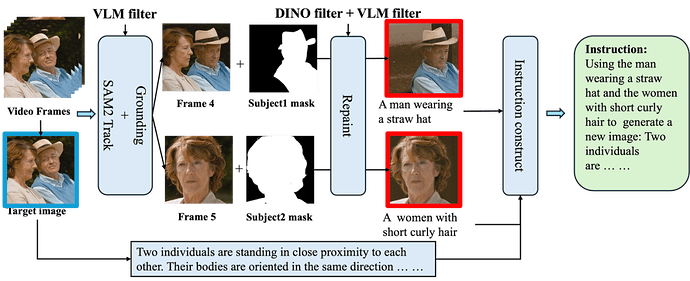

2. 数据生成流程重构

OmniGen2 也在探索解决阻碍领域发展的基础数据和评估方面的难题。相关的开源数据集大多存在固有的质量缺陷,尤其是在图像编辑任务中,图像质量和质量准确度都不高。而对于图片上下文参考生成任务,社区中缺乏相应的大规模多样化的训练数据。这些缺陷极大地导致了开源模型和商业模型之间显著的性能差距。为了解决这个问题,OmniGen2 开发了一个从视频数据和图像数据中生成图像编辑和上下文参考数据的构造流程。

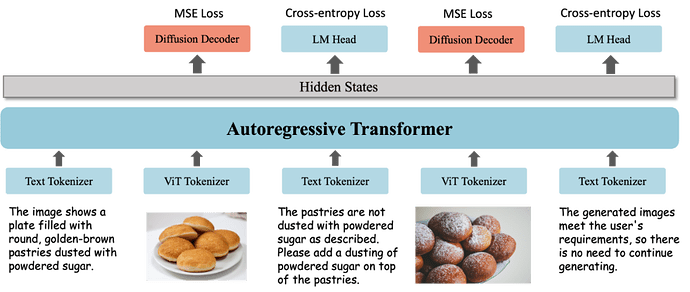

3. 图像生成反思机制

受到大型语言模型自我反思能力的启发,OmniGen2 还探索了将反思能力整合到多模态生成模型中的策略。基于 OmniGen2 的基础模型构建了面对图像生成的反思数据。反思数据由文本和图像的交错序列组成,首先是一个用户指令,接着是多模态模型生成的图像,然后是针对之前生成输出的逐步反思。

每条反思都涉及两个关键方面:

1)对与原始指令相关的缺陷或未满足要求的分析,

2)为解决前一幅图像的局限性而提出的解决方案。

经过训练的模型具备初步的反思能力,未来目标是进一步使用强化学习进行训练。

OmniGen2 发布一周 GitHub 星标突破 2000,X 上相关话题浏览量数十万。

现在科研体验版已开放,可抢先尝试图像编辑、上下文参照的图像生成等特色能力。

科研体验版链接:https://genai.baai.ac.cn

OmniGen2 的玩法简单,只需要输入提示词,就能解锁丰富的图像编辑与生成能力。

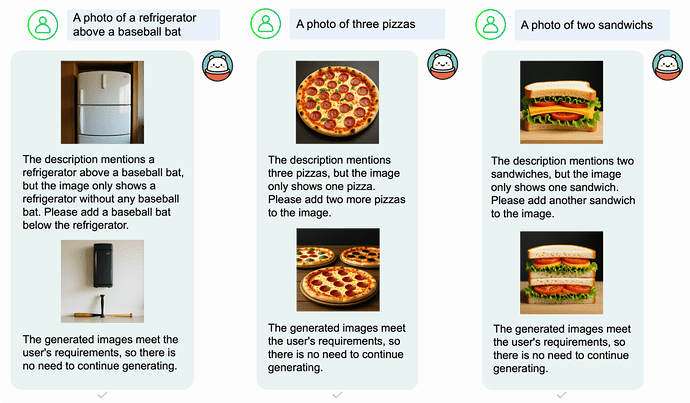

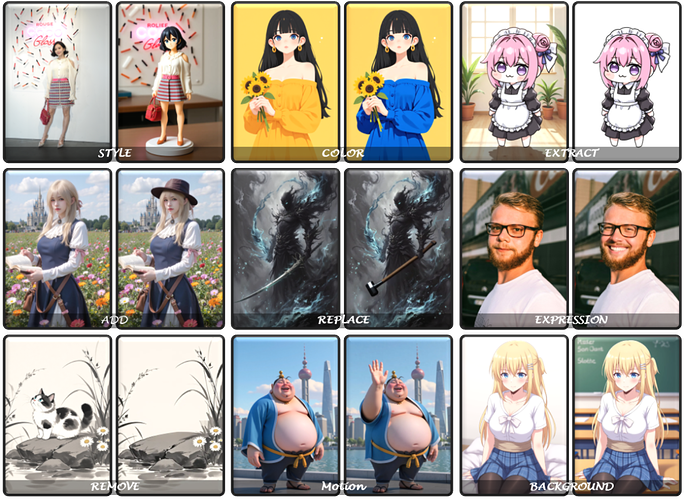

1. 基于自然语言指令的图像编辑

OmniGen2 支持基于自然语言指令的图片编辑功能,可实现局部修改操作,包括物体增删、颜色调整、人物表情修改、背景替换等。

2. 多模态上下文参考的图像生成

OmniGen2 可从输入图像中提取指定元素,并基于这些元素生成新图像。例如,将物品 / 人物置于新的场景中。当前 OmniGen2 更擅长保持物体相似度而不是人脸相似度。

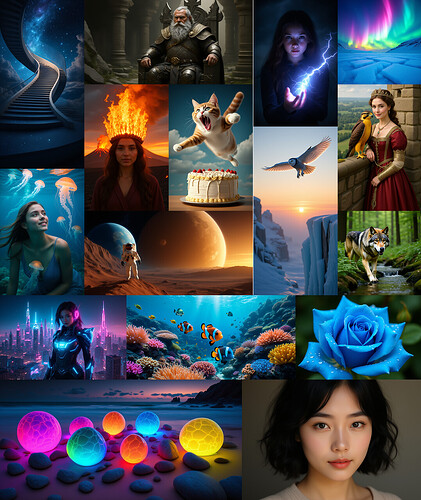

3. 文生图

OmniGen2 能够生成任意比例的图片。

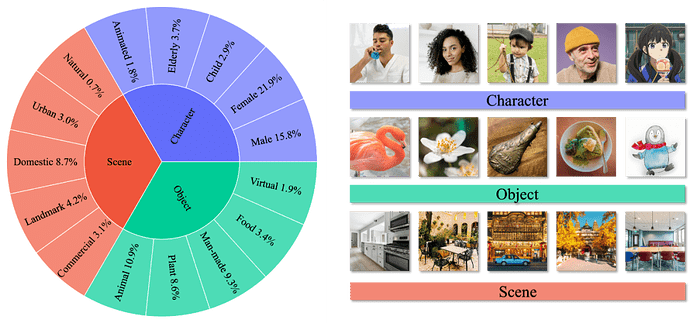

OmniGen2 在已有基准上取得了颇具竞争力的结果,包括文生图,图像编辑。然而,对于图片上下文参考生成(in-context generation) 任务,目前还缺乏完善的公共基准来系统地评估和比较不同模型的关键能力。

现有的上下文图像生成基准在捕获实际应用场景方面存在不足。它们不考虑具有多个输入图像的场景,并且受到上下文类型和任务类型的限制。同时,先前的基准使用 CLIP-I 和 DINO 指标来评估上下文生成的图像的质量。这些指标依赖于输入和输出之间的图像级相似性,这使得它们不适用于涉及多个主题的场景,并且缺乏可解释性。

为了解决这一限制,团队引入了 OmniContext 基准,其中包括 8 个任务类别,专门用于评估个人、物体和场景的一致性。数据的构建采用多模态大语言模型初筛和人类专家手工标注相结合的混合方法。

OmniGen2 依托智源研究院自研的大模型训练推理并行框架 FlagScale,开展推理部署优化工作。通过深度重构模型推理链路,并融合 TeaCache 缓存加速策略,实现 32% 的推理效率提升,大幅缩短响应时间并强化服务效能。同时,框架支持一键式跨机多实例弹性部署,有效提升集群资源整体利用率。团队将持续推进软硬协同优化,构建高效推理部署能力体系。

OmniGen2 的模型权重、训练代码及训练数据将全面开源,为开发者提供优化与扩展的新基础,推动统一图像生成模型从构想加速迈向现实。

OmniGen2 相关链接:

-

Github: https://github.com/VectorSpaceLab/OmniGen2/

-

论文:https://arxiv.org/abs/2506.18871

-

模型:https://huggingface.co/BAAI/OmniGen2

-

科研体验版链接:https://genai.baai.ac.cn

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:[email protected]