周志华团队发现LLM中已存在内源性奖励模型,理论证实强化学习有效。无需人工标注,性能超越现有方法,或将革新LLM开发。

原文标题:周志华团队新作:LLM中存在奖励模型,首次理论证明RL对LLM有效性

原文作者:机器之心

冷月清谈:

怜星夜思:

2、研究中提到内源性奖励模型可以通过提示词进行调用,实现特定领域的应用。那么,如何设计有效的提示词,以最大程度地发挥内源性奖励模型在不同领域的潜力?

3、文章提到强化学习能够修正标准模仿学习中的累积误差。那么,内源性奖励驱动的强化学习在哪些具体场景下,比传统的模仿学习更具优势?

原文内容

机器之心编辑部

将大语言模型(LLMs)与复杂的人类价值观对齐,仍然是 AI 面临的一个核心挑战。当前主要的方法是基于人类反馈的强化学习(RLHF)。该流程依赖于一个通过人类偏好训练的奖励模型来对模型输出进行评分,最终对齐后的 LLM 的质量在根本上取决于该奖励模型的质量。

因此,创建一个先进的奖励模型需要建立庞大且高质量的人类偏好数据集,而这一过程通常既缓慢、昂贵,又难以扩展。

这种对人类标注数据的依赖促使研究者探索其他对齐方法。一个重要的研究方向是基于 AI 反馈的强化学习(RLAIF)。该方法利用强大的专有大语言模型生成奖励信号或偏好标签,从而规避人类标注需求。虽然成本效益显著,但这些方法缺乏严谨的理论基础,且容易继承评判模型本身的风格偏差与固有偏见。这引发了一个关键问题:高质量奖励信号是否必须依赖外部来源?

来自南京大学的研究者发现,一个强大的通用奖励模型并非需要构建,而是可以挖掘出来的, 因为它已经潜在地存在于通过标准的下一个 Token 预测训练的任何语言模型中,称之为「内源性奖励(endogenous reward)」。

本文的核心贡献是为这一观点提供严格的理论基础。本文证明了可以从标准的下一个 Token 预测目标中恢复出一种特定形式的离线逆强化学习(IRL)奖励函数,该目标用于预训练和监督微调(SFT)。这一见解能够超越启发式方法,并建立一种原则性的方法,来引出语言模型在训练过程中隐式学习到的奖励函数。

具体来说,本文展示了语言模型的 logits 可以直接解释为 soft Q 函数,通过逆 soft 贝尔曼算子可以从中恢复出奖励函数。

至关重要的是,这一理论联系不仅仅提供了一种奖励提取的方法。本文还证明了,使用模型自身的内源性奖励进行微调可以使策略在误差界限上优于基线模型。强化学习过程有效地修正了标准模仿学习(即下一个 Token 预测)中的累积误差,将性能差距从任务视野的二次依赖关系 O (H²) 降低到优越的线性关系 O (H)。

据了解,这是首次理论证明强化学习在 LLM 中的有效性。广泛实验验证了这一理论,表明这种内源性奖励不仅优于现有的 LLM-as-a-judge 方法,而且可以超越那些通过昂贵的人类标注数据显式训练的奖励模型的表现。

-

论文标题: GENERALIST REWARD MODELS: FOUND INSIDE LARGE LANGUAGE MODELS

-

论文链接:https://arxiv.org/pdf/2506.23235

这篇论文提出了解决 LLM 的对齐问题,通过利用模型内部的奖励机制,而不是依赖外部的人类反馈,这可能会改变未来 LLMs 的开发和应用方式。

本文在实验中旨在评估以下核心问题:

Q1:在与启发式基线方法和显式训练的最新奖励模型对比时,免训练内源性奖励模型(EndoRM)在常见奖励模型基准测试中的表现如何?

Q2:内源性奖励是否具备强大的指令遵循能力,能否作为可通过提示词调用的通用奖励模型?

Q3:基于内源性奖励的强化学习能否产生更优策略,实现理论预测的自我改进效果?

多样偏好对上的奖励准确率(Q1)

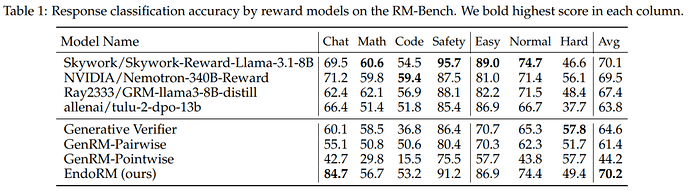

为回答 Q1,本研究通过预测 RM-Bench 中被选中的回复来评估奖励模型性能。更高的准确率意味着奖励质量更优。

由于本评估的方法无需训练,因此本评估将其与其他无需训练的方法进行对比:生成式验证器(Generative Verifier)、GenRM-Pairwise 和 GenRM-Pointwise 。

所有基线方法及本评估的 EndoRM 均采用 Qwen2.5-7B-Instruct 作为基础模型以确保公平比较。此外,本评估还列出了四个显式训练的高性能奖励模型的结果作为参考。

表 1 中的结果显示,EndoRM 不仅显著优于所有使用相同基础模型的无需训练基线方法,还以更高的平均得分超越了最先进的显式训练奖励模型。

这一发现表明,EndoRM 相比依赖高成本偏好数据筛选和训练的奖励模型更具有效性。

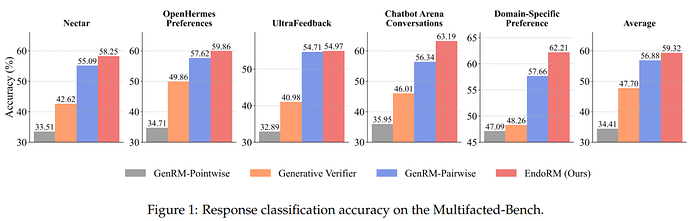

图 1 中进一步展示了 Multifaceted-Bench 的实验结果,从中可以观察到 EndoRM 在五个领域上始终优于所有基线方法。考虑到 Multifaceted-Bench 中可能包含数以千计的偏好对,这一结果证明了即使在任务复杂度和偏好多样性增加的情况下,EndoRM 仍能实现可扩展的鲁棒性。

这一发现进一步验证了本评估的核心假设:强大的奖励信号已潜在存在于基础模型之中。

验证指令遵循能力(Q2)

一个关键论点是内源性奖励并非静态的,而是可以通过提示来引导。

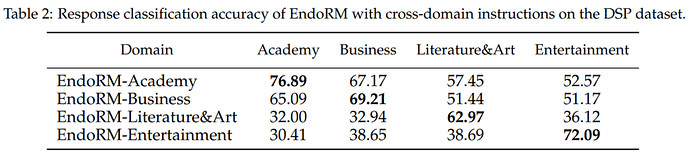

为验证这一点,本文使用了 DSP 数据集,该数据集包含四个不同的领域。本评估通过将 DSP 论文中相应的系统提示作为输入,创建了四个特定领域的版本的内源性奖励。

然后,本评估测试每个特定领域的内源性奖励在所有四个测试集上的响应分类准确率。

表 2 中的结果显示出强烈的对角模式:每个 EndoRM 在其自身领域上表现最佳。例如,EndoRM-Academy 在学术数据上达到了其最高准确率(76.89%)。

这证实了内源性奖励不是一个固定的评估器,而是一个动态的、可提示的评判器,继承了基础大型语言模型强大的指令遵循能力。

通过强化学习实现自我提升(Q3)

最后,本评估测试了定理 2 中的核心理论主张:带有内源性奖励的强化学习可以通过减轻复合误差来改进基础策略。

本评估在 MATH-lighteval 数据集上通过强化学习对基础模型 Qwen2.5-Math-7B 进行训练。内源性奖励模型同样是 Qwen2.5-Math-7B,在策略学习期间其参数保持固定。提示和响应的最大长度均设为 1024,KL 系数设为 0.01。

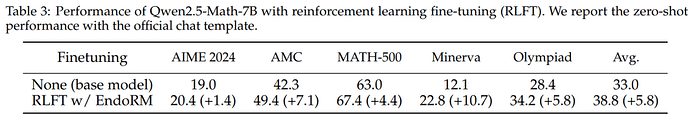

表 3 中的结果表明,带有内源性奖励的强化学习微调有助于模型在所有五个基准测试中一致地优于基础模型。

本评估还在附录 E 中给出了模型在强化学习前后的响应示例,从中可以看出,对于同一个问题,在基于内源性奖励进行优化之前,模型无法解决问题,并且随着响应的进行开始胡言乱语,甚至输出 Python 代码。

相比之下,本评估的方法提供了一个清晰简洁的解决方案。

了解更多内容,请参考原论文。

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:[email protected]