斯坦福博士论文聚焦以人为本的自然语言界面,旨在拓展AI的可及性,强调LLMs设计中的安全、风险评估以及更广泛用户群体的需求。

原文标题:【斯坦福博士论文】通过以人为本的自然语言界面拓展 AI 的可及性

原文作者:数据派THU

冷月清谈:

怜星夜思:

2、论文提出了一个新的评估框架,强调评估重点应放在生成语言所触发的行为上,而非语言本身的质量。那么,如何设计一个有效的评估体系,来衡量LLM生成内容对人类行为的潜在影响?

3、论文提出自然语言处理(NLP)研究应更好地支持更广泛用户群体的需求,那么,在实际研究中,我们应该如何识别并纳入此前被忽视的任务与需求?

原文内容

来源:专知本文约1000字,建议阅读5分钟在本篇论文中,我从自然语言界面的视角出发,提出三项研究工作,以推动我们对 LLMs 设计与理解的深入。

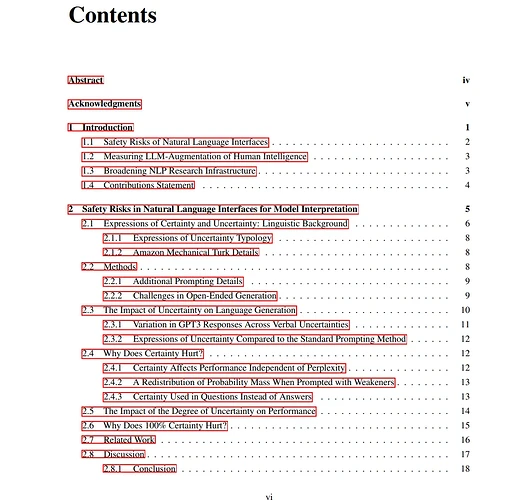

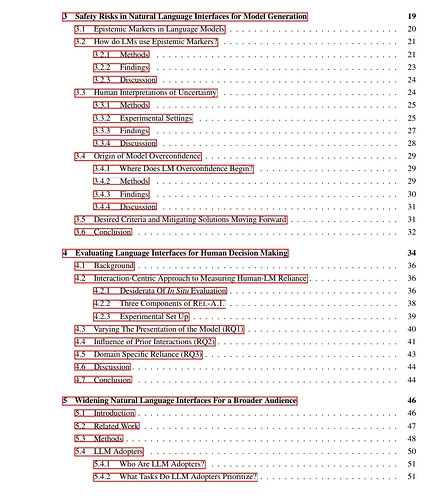

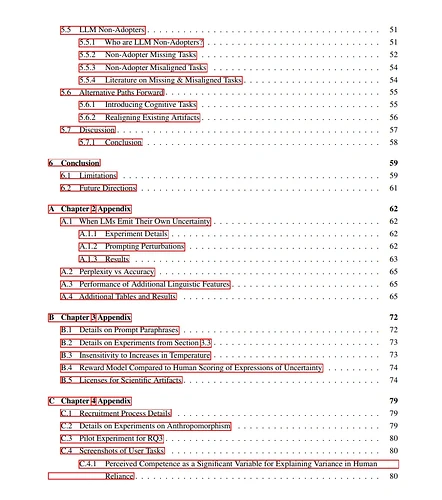

随着自然语言逐渐成为人机交互的默认界面,我们亟需思考:应如何设计大语言模型(LLMs),以安全地支持多样化的人类任务。在本篇论文中,我从自然语言界面的视角出发,提出三项研究工作,以推动我们对 LLMs 设计与理解的深入。这一过程不仅是技术挑战,更涉及对**人为因素(human factors)**的全面考量。

首先,我探讨了 LLMs 在传达风险与自身局限性方面所面临的关键安全隐患。研究发现,LLMs 在“理解”与“生成”关于确定性(certainty)的表达方面均存在困难。

其次,我提出了一个新的评估框架,用于识别人类与语言模型交互中可能产生的伤害,强调应将评估重点放在生成语言所触发的行为上,而非语言本身的质量。

最后,我探索了自然语言处理(NLP)研究如何更好地支持更广泛用户群体的需求,主张在研究议程中引入此前被忽视的任务与需求。

综上所述,我的工作识别了新的安全风险、提出了相应的缓解方案、构建了新的评估框架,并拓展了我们对 LLMs 如何安全地服务更广泛用户群体的理解。