OpenAI 为缓解 GPU 紧缺并降低依赖,开始租用谷歌 TPU 芯片,标志着 AI 基础设施多元化趋势。

原文标题:OpenAI转向谷歌TPU:宿敌也能变朋友?

原文作者:机器之心

冷月清谈:

怜星夜思:

2、谷歌愿意出租性能不是最顶尖的TPU给直接竞争对手OpenAI,这种行为背后有哪些商业策略和风险考量?

3、OpenAI 选择 TPU 是否意味着英伟达 GPU 在 AI 领域的统治地位开始动摇?未来 AI 芯片市场格局会如何演变?

原文内容

编辑:Panda

据路透社等多家媒体报道,一位知情人士称,OpenAI 最近开始租用谷歌的 AI 芯片来支持 ChatGPT 及其其他产品。

现目前,OpenAI 是英伟达 GPU 的最大买家之一 —— 这些设备在 AI 大模型的训练和推理阶段都必不可少。

看起来,OpenAI 不仅试图远离微软,现在也在开始远离英伟达了。

但与谷歌合作?也着实让人意外,毕竟拥有 Gemini 系列模型的谷歌可以说是 OpenAI 最直接且最强大的竞争对手之一。

如果考虑到 OpenAI 还曾聘请了谷歌云 TPU 高级工程总监 Richard Ho 作为其硬件负责人,并有传言说 OpenAI 还在推动自研 AI 芯片项目,这样的合作就更让人惊讶了。

Richard Ho 曾在谷歌工作近九年,全程参与 TPU 系列的研发,担任高级工程总监级别;后进入 Lightmatter 担任 VP;2023 年加盟 OpenAI

OpenAI 为何这样选择呢?

一个原因是 OpenAI 用户增长很快(近日宣布已有 300 万付费企业用户),正面临严重的 GPU 紧缺问题。为了保证 ChatGPT 推理能力不受影响,他们必须寻找替代方案。

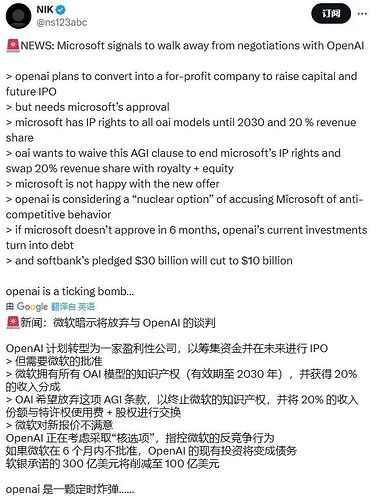

另一个原因可能是希望降低对微软的绑定程度,这也是 OpenAI 近段时间一直在做的事情。这两家公司最近也相当不愉快。

𝕏 用户 @ns123abc 对近期几篇相关报道的总结

据了解,这是 OpenAI 首次真正开始使用非英伟达芯片,这可能会推动 TPU 成为英伟达 GPU 更便宜的替代品。

具体使用方式上,据 The Information 报道,OpenAI 是希望通过谷歌云租用的 TPU,但谷歌云有员工表示,由于 OpenAI 与谷歌在 AI 赛道的竞争关系,谷歌并不会向其出租最强大的 TPU。

谷歌 Cloud TPU 定价

那对谷歌来说,这意味着什么呢?

谷歌目前正在扩大其张量处理单元(TPU)的对外开放程度,并已经赢得了苹果、Anthropic 和 Safe Superintelligence 等客户。

要知道,过去几年,AI 模型训练与推理几乎清一色依赖英伟达 GPU。如今,全球最核心的 AI 公司之一 OpenAI 开始采购谷歌的 TPU,这不仅意味着谷歌终于将内部使用多年的 TPU 成功商品化,而且还获得了「重量级背书」。谷歌在高端 AI 云市场的话语权得到提升,有望吸引更多大模型公司迁移阵地。这还表明 TPU 性能、稳定性、生态工具链已达到 OpenAI 的高要求。

谷歌已经发布了第 7 代 TPU Ironwood,参阅报道《》

同时,这也传递出了一个清晰的市场信号:AI 基础设施不等于英伟达,多元化已开始成为趋势。

参考链接

https://www.theinformation.com/articles/google-convinces-openai-use-tpu-chips-win-nvidia

https://www.reuters.com/business/openai-turns-googles-ai-chips-power-its-products-information-reports-2025-06-27/

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:[email protected]