阿里云计算巢MCP Server社区版,一键批量部署多MCP工具,兼容OpenAPI和MCP调用,助力AI应用实现“万物互联”。

原文标题:MCP进阶:一键批量搞定MCP工具部署

原文作者:阿里云开发者

冷月清谈:

怜星夜思:

2、文章中提到的计算巢MCP Server,相比传统的MCP市场,最大的优势是什么?这种优势对开发者来说意味着什么?

3、文章提到了在Dify中使用MCP工具时,需要将SSE工具版本降低到0.0.10。你觉得这可能是什么原因导致的?你在实际使用中还遇到过哪些坑?

原文内容

简介

在AI应用日益复杂的当下,传统MCP工具集成面临三大痛点:单工具部署效率低下(每次仅支持单个工具部署),调用方式割裂(无法兼容OpenAPI与MCP双,动态管理困难(工具增减需重复部署)。为突破这些限制,我们提出基于阿里云计算巢的一站式解决方案——通过标准化协议实现多MCP工具批量部署,提高云上的资源利用率,并首创OpenAPI与MCP双通道调用能力,使Dify、Cherry Studio,OpenWebUI等主流AI助手均可无缝接入。

背景

MCP(Model Context Protocol,模型上下文协议)是Anthropic于2024年11月发布的开源通信标准,其核心目标是通过建立统一的交互范式,消除大型语言模型(LLM)与异构数据源、工具间的集成壁垒。该协议通过三层次革新解决AI领域的数据孤岛问题,实现本地数据和互联网数据,基于MCP就可以实现事实上的”万物互联“,包括但不限于,数据和文件系统,操作阿里云上任意资源,浏览器自动化等等。

这项技术突破使得AI应用真正实现"万物互联"——从个人设备的文档处理到企业级云资源调度,均可通过统一协议完成智能交互。

图1 MCP协议官方架构图

传统MCP市场 VS 计算巢MCP服务

目前市面上已有多家MCP市场,但是遗憾的是,都存在着一些问题,针对这些问题,我们基于计算巢提供了首个多MCP工具批量一键部署ECS方案!

|

对比 |

传统MCP市场 |

计算巢MCP Server社区版 |

|

部署方式 |

每次只能选择单个MCP工具进行部署 |

支持选择多个MCP工具同时部署,复用ECS资源,提高资源利用率 |

|

调用兼容性 |

不能同时兼容OpenAPI和MCP的方式调用工具,这导致只能适配部分平台 |

支持通过OpenAPI和MCP两种方式调用,支持Dify,Cherry Studio,OpenWebUI等AI助手,支持百炼平台等 |

|

工具管理 |

增减要使用的MCP工具麻烦 |

支持通过变配动态增删要使用的MCP工具 |

原理剖析

图二 计算巢MCP服务架构

本方案的核心依赖于开源项目mcpo[1]和Higress[2]实现。整体工作步骤如下:

1. 工具选择与配置生成

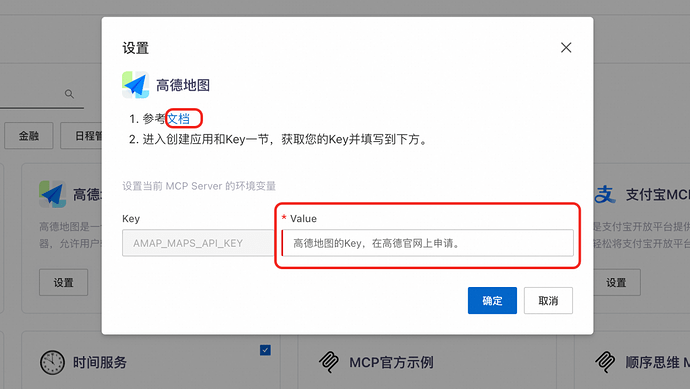

用户可选择多个MCP工具(如时间服务、高德地图等),系统将用户选择转化为标准化的JSON配置。每个工具的配置包含以下关键字段:

-

args: 工具启动参数数组 -

serverCode: 服务唯一标识符 -

env: 环境变量配置(包含API密钥等敏感信息) -

command: 执行命令类型(如uvx、npx等)

示例配置展示了时间服务和高德地图服务的不同参数结构和环境需求。

{

"args": [

"mcp-server-time"

],

"serverCode": "time",

"env": {},

"command": "uvx"

},

{

"args": [

"-y",

"@amap/amap-maps-mcp-server"

],

"serverCode": "amap-maps",

"env": {

"AMAP_MAPS_API_KEY": "dadasdaad"

},

"command": "npx"

}

2. 拉起MPCO服务

MCPO开源服务作为核心MCP工具功能提供方,通过解析第一步骤的JSON配置后在本地环境暴露标准化的OpenAPI接口,便于服务发现和调用。

3. 协议转换阶段

OpenApi-To-Mcp自动化工具执行关键的协议转换工作:

-

提取原始OpenAPI规范文档(通常为Swagger/OpenAPI格式);

-

分析API端点、参数结构和响应模式;

-

生成符合MCP协议规范的配置文件;

4. 服务注册与路由配置

自动化注册工具与Higress网关集成,完成:

-

服务元数据注册(包括服务来源、健康检查端点等);

-

动态路由规则配置;

-

MCP配置注入;

-

服务依赖关系建立与维护;

5. 统一服务暴露与安全控制

最终架构通过双通道方式暴露服务:

-

Higress网关负责暴露MCP工具的SSE(Server-Sent Events)链接,支持实时数据推送;

-

MCPO服务负责暴露标准化的OpenAPI接口,支持请求-响应模式交互;

-

整体服务访问通过统一的ApiKey进行鉴权,确保安全性;

部署和使用实战

部署流程

部署步骤

部署自定义MCP工具

['mcp-server-time', '--local-timezone=America/New_York']

AI助手使用示例

Cherry Studio使用示例

注意此处使用的是http协议,结尾是sse后缀。

Dify 使用示例

百炼使用示例

sudo systemctl r{"mcpServers":{"amap-maps":{"type":"sse","url":"http://47.xxx:8080/amap-maps/sse","headers":{"Authorization":"Bearer rBrrSh7ZhA"}}}}estart quickstart-mcp

Open WebUI使用示例

动态增减使用的MCP工具

如果想要修改要使用的MCP工具请参考下列操作。

问题排查

如果发现实例一直未部署成功,90%的概率是环境变量配置错误,可参考以下步骤排查:

cat /root/config.json

sudo systemctl restart quickstart-mcp

更多问题,请访问MCP官方了解如何使用:使用文档[8]

结语

MCP协议正以标准化接口的身份,重塑人工智能与现实世界的连接方式。它不仅是AI工具间的"通用语言",更是打通数字系统与物理世界的桥梁。通过定义统一的交互规范,MCP使AI模型能够自主调用气象卫星数据预测季风轨迹,在纳米尺度操控机械臂雕刻芯片,甚至解析敦煌壁画的矿物色谱与《荷马史诗》的韵律结构,揭示人类文明潜藏的认知规律!

服务优化新策略:AI大模型助力客户对话分析

在数字化时代,企业面临着海量客户对话数据的处理挑战,迫切需要从这些数据中提取有价值的洞察以提升服务质量和客户体验。本方案旨在介绍如何部署AI大模型实现对客户对话的自动化分析,精准识别客户意图、评估服务互动质量,实现数据驱动决策。

点击阅读原文查看详情。