南开大学提出HINT模型,通过分层多头注意力机制解决图像恢复中传统MHA的冗余问题,显著提升图像恢复质量和效率。

原文标题:CVPR 2025 | 魔鬼藏于统一性——即插即用分层多头注意力!

原文作者:数据派THU

冷月清谈:

怜星夜思:

2、QKCU模块通过增强头之间的交互来减少冗余,那么这种交互方式是否会引入新的计算负担?在计算资源有限的情况下,如何平衡交互的强度和计算效率?

3、文章提到HINT在极端低光条件下仍面临挑战,未来可以考虑收集大规模真实世界数据集进行进一步训练。那么,如何解决真实世界数据集的标注问题?是否存在一些半监督或者自监督的学习方法,可以用于提升模型在无标注数据上的性能?

原文内容

-

研究问题:在图像恢复领域,基于Transformer的方法已经显示出显著的性能,其中多头注意力(MHA)机制在捕获多样特征和恢复高质量图像方面起着关键作用。然而,MHA中独立的头从统一划分的子空间进行注意力计算,导致了冗余问题,限制了模型输出的满意度。本文旨在解决这一问题,提出一种改进的MHA机制,以提高图像恢复的质量。

-

研究难点:MHA机制的冗余问题主要表现在不同的头倾向于关注相同的区域,而忽略了对一些退化区域的恢复,导致输出结果不理想。此外,头之间缺乏协作加剧了冗余问题,限制了模型的表示能力。

-

文献综述:在图像恢复领域,从传统的手工制作方法到基于学习的CNN模型,研究者们见证了从低级任务到高级任务的范式转变。近年来,基于Transformer的模型被应用于低级任务,并在各种图像恢复任务中取得了显著进展。然而,这些模型仍然依赖于传统的MHA,存在冗余问题,限制了模型的性能。为了解决这一问题,研究者们提出了各种高效的模块和先进的架构设计,例如残差特征学习、编码器-解码器架构和注意力机制等。尽管这些注意力机制成功缓解了计算负担,但它们仍然依赖于传统的MHA,存在冗余问题,限制了模型的表示能力。

-

Hierarchical Multi-head Attention (HMHA):提出了一种分层多头注意力机制(HMHA),通过在不同大小和包含不同信息的子空间中学习,鼓励每个头学习不同的上下文特征,从而缓解了标准多头注意力(MHA)中的冗余问题。(本推文介绍重点)

-

Query-Key Cache Updating (QKCU) 模块:引入了QKCU机制,包括层内和层间方案,通过增强注意力头之间的交互来减少冗余问题。QKCU模块通过门控机制选择性地保留信息流中最关键的元素,从而提高模型学习不同上下文表示的能力。

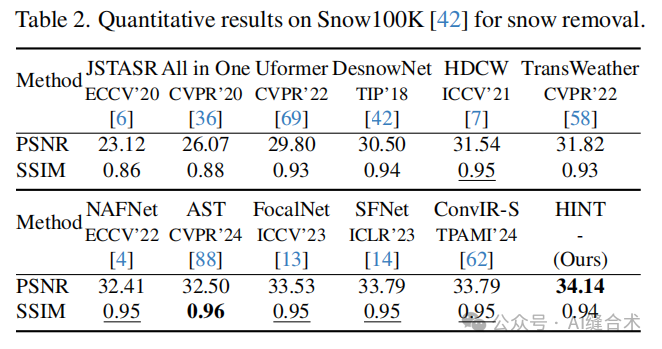

2. 训练细节:使用AdamW优化器进行训练,并采用广泛采用的损失函数来约束模型训练。模型训练时采用的超参数α被实验性地设置为0.9。HINT模型采用编码器-解码器架构,包含4个级别的编码器和解码器,以及4个基本块。在第4级,编码器和解码器块被统一为一个瓶颈层。此外,还包含一个细化阶段,由4个基本块组成。3. 结果与分析:

3. 未来工作方向:尽管HINT在图像恢复方面取得了显著成果,但在极端低光条件下恢复输入图像时仍面临挑战。未来工作可以考虑收集大规模真实世界数据集进行进一步训练,以解决这一问题。