字节跳动Seedream 3.0文生图模型霸榜,技术报告揭秘其在数据、预训练和后训练上的多项升级,部分性能超越GPT-4o。

原文标题:Mogao=Seedream 3.0?霸榜数天,神秘文生图模型曝光(附技术报告)

原文作者:机器之心

冷月清谈:

怜星夜思:

2、文章提到 Seedream 3.0 在人像生成方面能有效消除“AI 感”,生成的皮肤质感接近专业摄影水平。那么,你认为“AI 感”具体体现在哪些方面?如何进一步提升 AI 生成人像的真实感?

3、Seedream 3.0 技术报告中提到,团队使用了缺陷感知型训练范式,保留了部分带有缺陷的样本。这种做法的优势是什么?在实际应用中,如何平衡数据质量和数据数量?

原文内容

编辑:泽南、Panda

霸榜数天的神秘文生图模型 Mogao,什么来头?

这两天,不少业内人已在询问「这个魔法般模型」的出处。

有人对模型效果颇为认可,好奇如何体验。

神秘模型 Mogao 的横空出世,始于近期它在盲测打分的 Artificial Analysis 文生图排行榜上迅速蹿升,一度排名第一,位列 GPT-4o、Recraft V3、Imagen 3、Midjourney v6.1 等模型之前。

从社交媒体也能看到,网友对该模型近乎一水的好评。

昨晚,Mogao 的神秘面纱终于被揭下。

它背后是图像生成基础模型 Seedream 3.0,来自字节跳动 Seed 团队。

在 Artificial Analysis 文生图榜单上,除了拿下总榜第一,Seedream 3.0 在真实、图形设计与数字渲染、动漫、卡通与插图、复古风、传统艺术等不同风格,以及文字、商务、人像、自然、幻想等不同维度均表现领先。

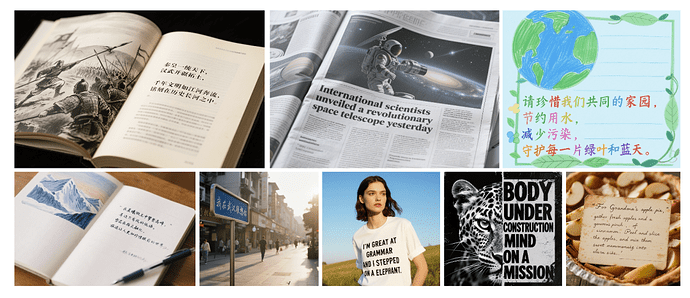

图片从左至右展示了在真实感、动漫、人像这三个细分项上的前 10 名。

尤其海报设计方面,Seedream 3.0 表现尤为突出,不仅小字崩坏率低,输出图像的设计感也很强。

众所周知,Seedream 3.0 已于 4 月初在字节自家的即梦和豆包平台上线,其在文字生成和排版上的出色能力备受关注。

而就在今天,字节跳动 Seed 团队也对外发布了 Seedream 3.0 技术报告,详细披露了模型的性能表现和技术细节。

机器之心带大家一睹为快。

-

技术报告:https://team.doubao.com/zh/tech/seedream3_0

-

arXiv:https://arxiv.org/abs/2504.11346

定性定量评估俱佳

文生图 SOTA 实至名归

Seedream 3.0 不久前开放使用时,我们已经专门体验了一番,参阅《》。

总结起来,相比于市面上其它同类产品,Seedream 3.0 优势体现在 —— 速度与质量兼备、文字准且美、原生支持 2K 图像输出三个方面。

根据官方披露的技术报告也能发现,模型在结构、指令遵循、美感、人像、文本可用性等多个维度均表现突出。

综合能力之外,团队还强调了密集文本渲染和逼真人像生成两方面能力。

具体来说,在生成结果中,Seedream 3.0 中文和英文字符的文本可用率均达到 94%,基本让文本渲染不再成为图像生成的掣肘。

除了可用率的整体提升之外,相比 2.0 版本,Seedream 3.0 渲染密集文本的能力也有重大提升,同时其小字符生成的准确率和文本布局的自然度也显著明显进步。

在人像真实感方面,团队为评估模型表现,专门构建了一个采用 Elo 竞赛机制、包含 100 个提示的人像评估新基准,囊括表情、姿势、角度、发质、肤质、服饰、配饰等人像生成的方方面面。

经过超过 50000 轮的公开评估,Seedream 3.0 与 Midjourney V6.1 同处第一梯队,相比其他模型优势明显。

从示例可以看到,Seedream 3.0 能有效消除人像生成的「AI 感」,可生成带有皱纹、绒毛和疤痕等真实特征的皮肤质感,逼真度已基本接近专业摄影水平。

机器之心还在实际评测发现,Seedream 3.0 不需要像之前一样执行超分辨率操作,而是可以一键直出 2K 分辨率图像。

对比其他模型,Seedream 3.0 也展现出极快的生成效率。

根据实测体验,Seedream 3.0 基本十几秒左右就能生成 4 张 2K 分辨率待选图像,生成高清图像(1K)时长更是短至数秒。相较之下,业界同类模型生成一张高清内容的耗时基本在 10 秒以上,而效果较好的 GPT-4o 生成一张高清图耗时往往超过 1 分钟。

从数据过滤到后训练

大量底层技术升级

Seedream 3.0 究竟是如何炼成的?在技术报告中,我们看到了 Seed 研究团队在数据、预训练和后训练上的多项工作。

数据准备阶段

在数据上,因之前偏保守的数据过滤策略会极大限制可用数据集大小,团队引入了一种全新的缺陷感知型训练范式。

该范式包含一个专门的缺陷检测器,可通过边界框预测精确定位缺陷区域。当检测到的缺陷总面积小于图像空间的 20%(可配置阈值)时,就会选择保留这些样本(之前会被丢弃),同时使用掩码隐含空间优化。

团队认为,这种创新方法的效果很好:在保证模型稳定性的同时,将有效训练数据集扩展了 21.7%。

为了优化数据分布,他们提出了一个双轴协同数据采样框架,可从视觉形态和语义分布两个维度进行联合优化。

团队还自主研发了一套跨模态检索系统,进一步增强数据生态系统的协调性,针对图像 - 文本对,建立了一个联合嵌入空间。该系统在所有基准测试中均取得了最佳性能。

预训练阶段

Seedream 3.0 的基本架构设计继承自 2.0 版,采用 MMDiT 来处理图像和文本 token ,并捕捉两种模态之间的关系。不过,在 Seedream 3.0 中,团队增加了基础模型的总参数,并引入了多项关键改进,提高了模型的可扩展性、泛化能力和视觉语言对齐能力,其中包括:

混合分辨率训练:每个训练阶段中,不同宽高比和分辨率的图像会被打包在一起,首先在平均分辨率为 256² 的图像上预训练模型,然后在更高分辨率的图像(从 512² 到 2048²)上对其进行微调。Seed 团队还采用了尺寸嵌入作为另一个条件,使模型能够感知目标分辨率。

跨模态 RoPE:Seedream 2.0 中的 Scaling RoPE 被扩展成了跨模态 RoPE,从而进一步增强了视觉文本 token 的对齐效果和文本渲染精度。其中,文本 token 被视为形状为 [1, L] 的二维 token,并对文本 token 应用二维 RoPE。

后训练阶段

Seedream 3.0 后训练流程则包含以下几个阶段:持续训练(CT)、监督微调(SFT)、人工反馈对齐(RLHF)和提示工程(PE)。各阶段效果对比如下图所示。

为进一步提升美感,在新模型上,团队专门训练了多个版本的描述模型。

这些模型能在审美、风格、排版等专业领域提供精准的描述,确保 Seedream 3.0 能够更有效地响应相关提示,不仅增强了模型的可控性,也提升了提示工程后模型的性能。

另外在奖励模型上,Seedream 3.0 使用了 VLM 作为奖励建模框架,而不再是 CLIP,并提升了其参数量。

团队借鉴语言模型中生成式 RM 经验,进行奖励建模,依靠 LLM 原本的 Scaling 能力,提升奖励准确性与鲁棒性;此外,团队还将奖励模型参数量从 0.8B 拓展至 20B 以上。

推理加速相关工作

为促使 Seedream 3.0 拥有更高生成效率,团队专门针对推理加速进行了优化。

框架方面,模型采用了 Hyper-SD 和 RayFlow。这使得生成路径得到了优化,每个数据点会被引导至特定实例的目标分布,从而实现每个样本的轨迹定制。这可显著减少路径碰撞,并提高生成稳定性和样本多样性。

该团队还引入一种重要性采样机制来提升效率,其可以学习在训练过程中关注最关键的时间步。此外,Seedream 3.0 的框架也支持高效的少步数采样,且不会影响生成质量。

打榜一时超越 4o

就比它更强?

看到这,相信不少人也会提问,Seedream 3.0 比起 GPT-4o 如何?打榜超过就一定强么?

在技术报告中,我们发现团队专门对比了 Seedream 3.0 与 GPT-4o 的表现。需要强调的是,GPT-4o 本质上是一款文本 + 图像的多模态模型,而这里的对比仅限于图像生成能力。不过,通过一些案例比较,该团队也找到了这两个模型各自的优势和短板。

例如密集文本渲染方面,团队发现 GPT-4o 在小英文字符的准确性和某些 LaTeX 符号的渲染方面表现出色。然而, GPT-4o 在渲染中文字体方面表现相对不足,相比之下,Seedream 3.0 可以轻松生成密集的中文文本,并且在排版和构图美感方面优于 GPT-4o。

下图给出了一些示例,其中上列来自 Seedream 3.0,下列来自 GPT-4o。

此外,团队还系统性地对比了包括颜色、纹理、清晰度和美观度在内的生成质量。

下图展示了多组示例,每组图像的左图来自 Seedream 3.0,右图来自 GPT-4o。

在生成质量方面,Seedream 系列模型色彩更为饱满,GPT-4o 生成图像部分伴有噪点。

值得一提的是,在连续性图片生成(比如:漫画、流程图)方面,GPT-4o 的能力依然让人感到惊艳,这也是 Seedream 3.0 需要进一步提升之处。

文生图开卷

全面落地时代已来

最近,文生图模型又开始卷到飞起,字节 Seedream 3.0 正式亮相的同时,仅在国内,就有好几家 Artificial Analysis 上榜模型同期发布。

从多模态对齐到高分辨率输出,再到密集文字渲染与人像真实感优化, Seedream 3.0、GPT-4o 等模型在这一波集体跃迁,MJ、Flux 等曾经的明星模型被逐渐淡忘。而背后的技术演进、系统设计哲学与产品化思路,也将越来越多地决定 AI 在真实世界中的落地路径与生态潜力。

一轮新竞赛已经悄然开场,这些新模型在吸引关注的同时,也有望催生出全新的创作范式。

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:[email protected]