上海交大发布口语对话情感大模型「交交」,支持多人对话、多语种、情感理解,性能媲美GPT-4o,学术界自研力量不容小觑!

原文标题:「交交」媲美GPT-4o!上海交大推出口语对话情感大模型,首个纯学术界自研!

原文作者:机器之心

冷月清谈:

怜星夜思:

2、文章提到「交交」具备情感理解和表达能力,并且可以模仿用户声音,你觉得这种技术在实际应用中会带来哪些伦理问题?我们应该如何防范这些风险?

3、「交交」在基准测试中表现出色,但实际应用场景可能更加复杂。你认为「交交」在哪些方面还需要进一步提升,才能更好地满足用户的需求?

原文内容

智能语音交互领域,学术研究也能如此酷炫。全球首个纯学术界自研的支持多人实时口语对话的语音情感大模型 ——“交交”,正式推出!

“交交” 由上海交通大学听觉认知与计算声学实验室倾力打造,它不仅是一个智能语音助手,更是一个多说话人、多语言、多角色、多情感的全能对话伙伴。

核心亮点

上海交通大学此次推出的 “交交” 口语对话情感大模型,除了在对话上下文内容上的强大理解和知识问答能力,还同时具备多人对话与身份辨识,多语种和方言感知,角色切换与实时模仿,情感实时理解和表达等多项能力。这在目前已知发布的语音对话大模型中,尚属首次。

1. 多人对话,无缝切换

无论是家庭聚会、团队会议,还是朋友闲聊,“交交” 都能同时与多位用户进行自然流畅的对话。它能精准识别每个人身份,各自的发言内容,并给出个性化的回应。还能准确地进行总结,让对话更加生动高效。

视频 1:上海交通大学校庆主题对话示例

视频 2:会议场景 5 人多轮对话示例

2. 语通五洲,方言无碍

“交交” 现已支持汉语、英语、日语和法语四大主流语言,让您无论身处何地都能用最熟悉的语言与模型进行互动。不仅如此,“交交” 具备跨语言回复能力,无论提问和回复采用同一种语言还是不同语言,都能轻松打破沟通壁垒,实现无缝交流。

针对中文,“交交” 进行了特殊优化,拥有强大的中文方言识别与理解能力。不论是四川话、山东话,还是其他地方特色方言,均可精准捕捉语意,让对话更加亲切自然,贴近您的生活语言习惯。

视频 3:中英日法对话示例

视频 4:四川话、山东话对话示例

3. 角色百变,情感丰富

“交交” 不仅能回答问题,还能根据对话内容和场景理解用户的情绪,同时生成富有情感的回应。无论是幽默调侃、暖心安慰,还是专业建议,它都能恰到好处地表达。“交交” 不仅能模仿多个角色的声音,还能实时学习并模仿用户本人的声音。无论是角色扮演、故事讲述,还是个性化互动,它都能轻松驾驭。

视频 5:音色实时克隆与角色扮演示例

视频 6:情感理解与表达示例

视频 7:丰富情感表达示例

4. 知识问答,无所不知

“交交” 不仅是一个对话伙伴,更是一个知识宝库。无论是古诗词背诵、科学原理讲解,还是文学名著解读,它都能信手拈来。结合超长上下文理解能力,无论是小学生的学习辅导,还是高中生的知识扩展,甚至是研究生的科研探索,交交都能满足您的求知欲。

视频 8:常见知识问答示例

视频 9:唐代历史主题多轮问答示例

技术突破

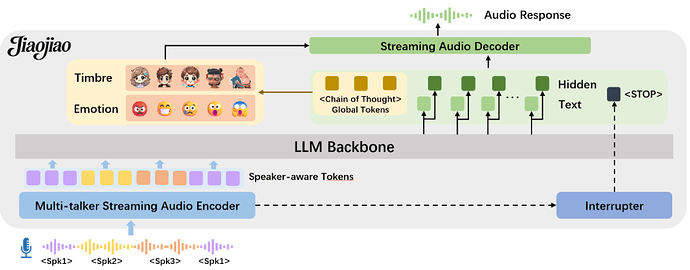

图 1: “交交” 口语对话情感大模型技术框架

1. 端到端语音对话

采用鲁棒的音频编码器,具有良好的抗噪能力和多人理解能力的同时,将音频输入流式编码器得到离散序列,并对齐到文本序列空间。无需大规模高质量数据微调,即可最大限度保持和利用文本大模型的基础泛化能力做到实时知识问答。

2. 多语言理解与生成

基于创新的跨模态对齐机制,将多语言语音信号与对应文本在特征空间实现精准映射,同时通过隐式表征学习保留语言特异性信息,结合深度语言模型的上下文建模能力,实现跨语言场景下的无缝切换与高效语义理解。

3. 多人对话建模

我们通过构造多人对话数据,模拟家庭聚会、团队会议等真实场景,增强模型的对话处理能力。利用端到端模型融合上下文信息,生成个性化的响应和总结,实现自然且连贯的多方互动。

4. 情感理解与表达

基于上下文信息,利用思维链技术生成符合对话场景的情感全局表征,用于生动的情感语音回复生成,提升对话交流的真实感。

5. 实时音色克隆与切换

提供高保真声音模仿技术,通过思维链技术进行控制信号推理,从而支持多角色语音扮演风格以及与用户自身声音之间的实时无感切换。

6. 灵活拓展

强大的对齐策略,支持文本与音频模态的任意方式拼接融合,不仅显著提升了多模态建模的灵活性,还为集成大规模文本大模型中的多种增强机制(如联网搜索、RAG 检索增强生成等)提供了统一且可扩展的接口。

基准测试

在语音对话大模型的赛道上,性能指标是衡量模型实力的关键。在相关测试中,“交交” 展现出卓越的表现,全面对标业内主流模型,部分指标甚至已实现逼近甚至超越,充分验证了其在语音理解与交互领域的强大潜力。

1. 通用性能测试:音频理解 + LLM 能力双重突破

随着大模型时代的到来,语音理解标准测试集 VoiceBench 为我们提供了一个全面评估语音对话大模型性能的重要平台。基于 VoiceBench 英文基准测试,我们对多款主流语音模型进行了全方位的评测,涵盖开放域问答、多选 QA、指令遵循等多个关键任务。

在整体评测中,“交交” 获得了 79.05 的平均分,仅次于 OpenAI 发布的 GPT-4o 模型。与业内领先的 GPT-4o-Audio 相比,我们的模型差距缩小到仅 8%,实现了从传统模式向端到端语音交互的重大突破。

针对音频输入的特殊性,我们优化算法,有效克服语义模糊问题,相较于其他端到端语音大模型,“交交” 显著提升复杂任务表现(如指令跟随,知识问答)等。使用同规模参数量与 Qwen2.5-7B 文本指令模型的差距大幅缩小,标志着我们在端到端语音交互理解模块达到和文本相近的能力!

评测结果显示,在通用知识、指令跟随、复杂问题理解、人工智能安全层面,“交交” 都展现了极强的竞争力,不仅全面对标当前主流 SOTA 模型,还在多个关键任务上实现超越.

2. 多语言测试:中英日法全面覆盖

在 VoiceBench 的中英日法基准测试中,我们的模型展现了极强的多语言处理能力,尤其是在中文、日文、法文上的表现均显著优于 Qwen2-Audio。我们的模型不仅支持多语言,还在不同语言环境下保持了稳定的高性能表现,真正实现了 "多语言,零差异"!

3. 真机中文实测:无惧设备场景难题,多领域表现优异

为了更全面地评估模型在实际场景中的表现,我们用丰富的设备录制了中文真实数据集,涵盖健康、人际关系、小学数学、生活常识、科学常识等多个领域知识的单轮问答,确保数据的复杂性、多样性。测试结果表明,我们的模型不仅在通用任务上表现优异,还在垂直领域展现了强大的专业能力。

4. 语义理解基准测试:衡量语音理解的基石

我们对 “交交” 在中英文语音识别、多语种语音识别(英语、汉语、法语、日语)及中英互译任务上的表现进行了全面评估,并与多款业界领先模型进行了对比,包括 Whisper-large-v3、Qwen2.5-Omni 与 Qwen2-Audio。

4.1 语音识别任务

-

在英文(Librispeech)、中文(WenetSpeech)以及中英日法多语种(CommonVoice)的测试集中,“交交” 整体性能优异,在英文和多语种识别中表现尤为突出,均已达到和目前 SOTA 相近的性能。

-

尤其在 CommonVoice 测试集中的多语言场景下,错误率显著低于 Whisper 和 Qwen 系列模型,展现出更强的语音理解与跨语言泛化能力。

4.2 中英互译任务

-

在中→英、英→中方向的语音翻译任务中,“交交” BLEU 值领先,尤其是对于英翻中,优于 Qwen2 系列模型,显示出良好的语义把握和翻译一致性。

“交交” 在多语言理解与翻译任务中表现出色,彰显了我们在传统语音理解任务上的出色实力。

5. 延迟表现对比

在语音对话大模型的实际应用中,对话延迟是影响用户体验的关键因素之一。为了验证我们的模型在真实场景下的表现,我们使用同一款手机,在同一公用网络环境下,对我们的模型与 GPT-4o、通义千问、喜马拉雅、阶跃星辰等主流 App 的最新版本进行了延迟测试。测试结果显示,我们的模型在延迟表现上展现了显著的竞争力。

视频 10:语音对话大模型回复延迟测试实录

图 2:语音对话大模型回复延迟对比图

团队介绍

“交交” 的研发团队来自上海交通大学计算机学院听觉认知与计算声学实验室(SJTU Auditory Cognition and Computational Acoustics Lab,AudioCC Lab),该实验室由语音对话和听觉处理领域知名学者钱彦旻教授领导,专注于完整的听觉人工智能与计算声学领域的前沿研究。

团队集结了一支由青年教师、博士生、硕士生、本科生及专职科研人员等组成的近 40 人科研团队,在语音、音频、音乐及自然声信号处理等领域积累了丰富的技术经验。实验室依托国家重点项目及企业合作支持,拥有数百块先进 GPU 计算资源,致力于解决产业级技术难题。

近年来,团队在国际顶级期刊和会议上发表了数百项学术成果,并在多项国际评测中斩获冠军。团队成员全面发展,毕业生均进入国内外顶级企业和研究机构,持续推动人工智能技术的创新与应用。

“交交” 项目团队合影,从左起:孙海洋,张乐莹,乐辰阳,钱彦旻,龚勋,李晨达,韩冰,王巍。

“交交” 项目团队合影,从左起:龚勋,乐辰阳,韩冰,李晨达,王巍,钱彦旻,孙海洋,张乐莹。

“交交” 项目团队合影,从左起:张乐莹,龚勋,王巍,李晨达,钱彦旻,韩冰,孙海洋,乐辰阳。

未来已来,对话无限可能!“交交” 不仅是语音助手,更是您的智能对话伙伴、知识导师和娱乐伙伴。它重新定义了人机交互的方式,让对话更加自然、智能、有趣。“交交” 的诞生,展现了在大模型时代,学术界在科技创新中依然具有无限的潜力。上海交通大学听觉认知与计算声学实验室用实力证明,学术研究不仅能推动科技进步,更能直接服务于社会,为人类生活带来便利与乐趣。

我们诚邀对前沿技术充满热情的您参与 “交交” 口语对话情感大模型的内测体验。由于资源有限,本次内测将面向部分用户优先开放。如果您希望提前体验并为我们提供宝贵的反馈,请访问 https://wj.sjtu.edu.cn/q/4FiP8hsB 填写内测申请表。您的参与将帮助我们不断优化,共同推动技术的进步!期待您的加入!

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:liyazhou@jiqizhixin.com