清华大学团队发布YOLOE,一款支持文本、视觉、无提示的开放场景物体实时检测与分割模型,让AI真正“看见一切”。

原文标题:在线教程丨YOLO系列重要创新!清华团队发布YOLOE,直击开放场景物体实时检测与分割

原文作者:数据派THU

冷月清谈:

怜星夜思:

2、YOLOE模型在实时性方面表现出色,但在哪些场景下,对实时性的要求会更高?这种高实时性会带来哪些挑战?

3、YOLOE模型在开放场景下的物体检测能力很强,你觉得它在哪些行业或领域有最大的应用前景?会给这些行业带来哪些变革?

原文内容

本文约1000字,建议阅读5分钟清华大学团队在 YOLO 的基础上,提出了开放物体探测与分割模型 YOLOE。

清华大学团队在 YOLO 的基础上,提出了开放物体探测与分割模型 YOLOE,既能听懂语言指令,又能看懂图像,甚至还能自主发现新事物,实现了真正的「实时看见一切」。

YOLO (You Only Look Once) 自 2015 年首次发布以来,已经成为计算机视觉领域中最具影响力的实时目标检测模型之一。这项基于单阶段 (One-Stage) 检测架构的端到端目标检测技术,在 10 年间已经更新了十余个版本,凭借高精度且高帧率图像的实时处理,广泛应用于自动驾驶、医疗影像分析、机器人视觉等多个领域。

然而,传统的 YOLO 系列模型虽然利用卷积神经网络实现了高性能的实时检测,但其依赖于预定义的目标类别,在实际的开放场景中缺乏灵活性。

针对这一问题,清华大学团队在 YOLO 的基础上,提出了开放物体探测与分割模型 YOLOE,支持文本提示 (text prompts)、视觉提示 (visual cues) 和无提示 (prompt-free) 三类场景,这一多模态能力使其既能听懂语言指令,又能看懂图像,甚至还能自主发现新事物,实现了真正的「实时看见一切」。

目前 HyperAI超神经官网的教程板块已经上线了「YOLOE:实时看见一切」的一键部署教程,感兴趣的小伙伴快来体验吧!

Demo 运行

1.登录 hyper.ai,在「教程」页面,选择「YOLOE:实时看见一切」,点击「在线运行此教程」。

2.页面跳转后,点击右上角「克隆」,将该教程克隆至自己的容器中。

3.选择「NVIDIA RTX 4090」以及「PyTorch」镜像,OpenBayes 平台上线了新的计费方式,大家可以按照需求选择「按量付费」或「包日/周/月」,点击「继续执行」。新用户使用下方邀请链接注册,可获得 4 小时 RTX 4090 + 5 小时 CPU 的免费时长!

4.等待分配资源,首次克隆需等待约 2 分钟左右的时间。当状态变为「运行中」后,点击「API 地址」旁边的跳转箭头,即可跳转至 Demo 页面。由于模型较大,需等待约 3 分钟显示 WebUI 界面,否则将显示「Bad Gateway」。请注意,用户需在实名认证后才能使用 API 地址访问功能。

效果展示

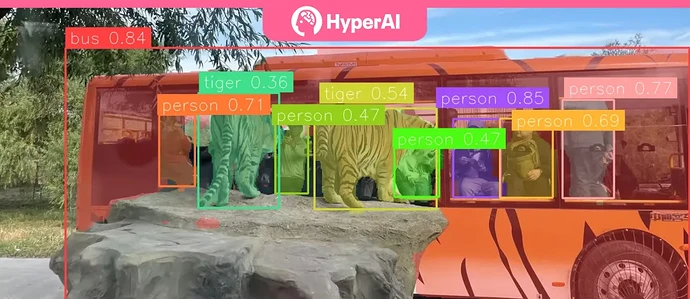

首先是文本提示检测,YOLOE 支持任意文本类别的文本提示检测与分割。下图输入的文本为「tiger, bus, person」,检测结果如右图所示,清晰识别出图中的老虎、观光巴士和游客。可以看到,即使是头部被遮挡和身处暗处的游客也被清晰识别出来了。

其次是视觉提示,通过框 / 点 / 手绘形状 / 参考图等方式指定检测目标后,即可精准识别同类检测对象,效果如下图所示:

最后是全自动无提示检测,能够自动识别场景对象,如下图所示:

以上就是本期为大家推荐的教程,快来上手亲自体验吧!