TRACE技术通过因果事件建模提升视频大模型时间定位能力,为长视频内容检索带来突破。

原文标题:TRACE:因果事件建模助力视频理解大模型的时间定位能力

原文作者:机器之心

冷月清谈:

怜星夜思:

2、TRACE模型中,时间和分数使用了专用的tokenizer,这种设计对模型性能有什么影响?如果不使用专用tokenizer,效果会差很多吗?

3、TRACE模型在zero-shot任务中表现出色,这意味着什么?在实际应用中,zero-shot能力有多重要?

原文内容

论文第一作者为香港中文大学(深圳)理工学院在读博士生郭永新,指导老师为通讯作者为香港中文大学(深圳)理工学院 / 人工智能学院助理教授唐晓莹,课题组研究方向包括大模型、联邦学习、充电智能优化与博弈等。

下班回家后你正深陷于一部两小时的综艺节目中,渴望找到那些让人捧腹的爆笑片段,却如同大海捞针。或者,在紧张刺激的足球赛中,你渴望捕捉到那决定性的绝杀瞬间,但传统 AI 视频处理技术效率低下,且模型缺乏泛化能力。为解决这些问题,香港中文大学(深圳)唐晓莹课题组联合腾讯 PCG 发布 TRACE 技术,通过因果事件建模为视频理解大模型提供精准的时间定位能力。

-

论文标题:TRACE: Temporal Grounding Video LLM via Causal Event Modeling

-

VTG-LLM: Integrating Timestamp Knowledge into Video LLMs for Enhanced Video Temporal Grounding

-

论文地址:https://arxiv.org/pdf/2410.05643

-

https://arxiv.org/pdf/2405.13382

-

Github:https://github.com/gyxxyg/TRACE

一. 背景

在长视频内容检索的研究领域中,用户常面临时间线导航效率低下的困境。传统的视频检索方法采用逐帧分析的线性处理策略,如同逐帧查字典,效率低下且泛化能力差。而现有的多模态大模型,虽然泛化能力更强,但是效果仍然差强人意。

我们认为这背后的矛盾本质上源于视频理解大模型的输出依然使用自然语言建模,无法清晰准确地描述视频本身的结构。TRACE 的绝妙之处是给视频事件构建结构化表征,将每个模型的输出表示为一系列事件,进一步把每个事件拆成三元组「时间戳 - 显著性分数 - 文本描述」,通过因果推理链重构视频逻辑骨架。

TRACE 技术突破了传统方法的局限,不再依赖没有清晰结构的文字描述,而是通过事件级别的因果建模,显著提升了时序理解与定位精度,为视频内容检索实现了 “大海捞针”。

二. 方法

TRACE 方法引入了结构化建模创新:把视频理解大模型的输出拆解成「时间戳 - 显著性分数 - 文本描述」三元事件单元,实现因果事件建模 —— 通过视觉输入、文本指令和已有事件预测下一个事件

I:文本指令,F:视频帧的输入,tk, sk 和 ck:时间戳、显著性分数和文本描述。

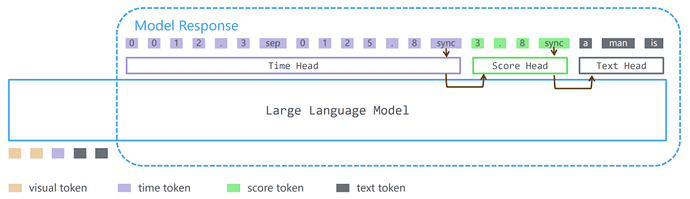

我们通过条件概率分解发现,因果事件建模可表示为自回归模型,具有特殊的 token 顺序。基于这一发现,我们提出了视频大模型 TRACE(Temporal grounding via Causal Event modeling)。而且,TRACE 还为时间和分数设计了专用的 tokenizer,就像给它们创建了特定的表征系统。这样,模型就能更准确地理解和生成时间戳和显著性分数了,并为每个任务设计不同的编码器和解码器头,解码器头能根据任务自动切换,从而提高整体性能和适应性。

针对时间和分数的特殊编码器

我们为时间和分数设计专用 tokenizer:时间用 6 位编码(例:[10.23, 125.37]→<0><0><1><0><.><2><sep><0><1><2><5><.><4><sync>),分数用 3 位编码(例:[4.5] →<4><.><5><sync>)。每个词库含 13个token,包括10个数字token以及三个特殊token:<.><sep><sync > ,通过组合实现精确数值表达。

通过切换 head 来生成不同的任务

在推理阶段,模型通过 < sync > 令牌切换任务专用解码器:依次生成时间→分数→描述,每个任务配备独立解码头。<sync > 出现时自动切换解码任务。

视频帧的特征编码

TRACE 使用 CLIP ViT-L 从每帧提取大量的原始 token,然后通过基于 slot 的 token 压缩方案将每一帧压缩为 8 个 token。这些精炼后的 token 既保留了关键视觉信息的完整性,又有效地将时间感知元素融入特征表征中。

训练策略和数据

模型 backbone 模型基于 Mistral-7B 架构,分两阶段训练:

-

第一阶段:训练视觉压缩模块 + 任务头(抽 128 帧,学习率 1e-3)

-

第二阶段:冻结上述模块,专注调 LLM 基座(同抽 128 帧,学习率 5e-6)

三. 评测

zero-shot

我们在三大 zero-shot 任务测试表现:

-

Dense video caption:Youcook2

-

Moment retrieval:Charades-STA

-

Video highlight detection:QVHighlights

从表中可以看出,TRACE 模型都取得了 “碾压” 其他通用 video LLM 的效果,比 Temporal grouding LLM 有更大优势。

Ablation study

在 zero-shot 模式下,我们测试了 causal event modeling 和 independent encoder/heads 等关键模块在消融实验下的结果,如下表所示。

实验结果验证了我们提出的因果事件建模以及对时间 / 分数使用独立的编解码器的有效性。另外,从结果中我们还可以发现,随着采样帧数的增加,模型的效果随之增加。

Fine tune

在实验中,我们还比较了 TRACE 与其他模型在 finetune 之后的效果。

在评测中,TRACE 相比 TimeChat 等模型有了巨大的提升,在 Youcook2 数据集上取得了 SOTA 效果。无论是 zero-shot 任务还是 finetune 后的效果,TRACE 都取得了优于其他模型的成绩。

四.结语

总之,TRACE 用 “因果事件建模” 撕开了长视频的迷雾,以 “任务分治” 策略破解了效率与精度的不可能。它为 AI 理解视频的方式提供了一种新的可能 —— 不是囫囵吞枣,而是逻辑推演 。

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:[email protected]