VAST和北航开源MIDI模型,无需繁琐流程,仅凭单张图像即可端到端生成高质量三维组合场景,为虚拟现实等领域带来新工具。

原文标题:CVPR 2025 | VAST和北航开源MIDI,从单张图像端到端生成三维组合场景

原文作者:机器之心

冷月清谈:

怜星夜思:

2、MIDI 模型目前主要关注静态场景的生成,未来是否有可能扩展到动态场景的生成?如果可以,会面临哪些新的技术挑战?

3、MIDI 模型在生成三维场景时,如何保证各个物体之间的功能性和语义一致性?例如,如何确保桌子旁边放置的是椅子,而不是其他不相关的物体?

原文内容

本文的主要作者来自 VAST、北京航空航天大学、清华大学和香港大学。本文的第一作者为北京航空航天大学硕士生黄泽桓,主要研究方向为生成式人工智能和三维视觉。本文的通讯作者为 VAST 首席科学家曹炎培和北京航空航天大学副教授盛律。

在 Sora 引爆世界模型技术革命的当下,3D 场景作为物理世界的数字基座,正成为构建动态可交互 AI 系统的关键基础设施。当前,单张图像生成三维资产的技术突破,已为三维内容生产提供了 "从想象到三维" 的原子能力。

然而,当技术演进到组合式场景生成维度时,单物体生成范式的局限性开始凸显:现有方法生成的 3D 资产如同散落的 "数字原子",难以自组织成具有合理空间关系的 "分子结构"。这导致几个核心挑战:① 实例分离困境(如何从单视图准确解耦交叠物体)② 物理约束建模(如何避免穿模的不合理交互)③ 场景级语义理解(如何保持物体功能与空间布局的一致性)。这些瓶颈严重制约着从 "数字原子" 到 "可交互世界" 的构建效率。

最近,来自北航、VAST 等机构的研究团队推出了全新的模型 —— MIDI,它能够从单张图像生成高几何质量、实例可分离的 3D 组合场景,在单视图 3D 场景生成领域取得了突破性进展,为可交互世界生成奠定基础。

-

论文链接:https://arxiv.org/abs/2412.03558

-

项目主页:https://huanngzh.github.io/MIDI-Page/

-

代码仓库:https://github.com/VAST-AI-Research/MIDI-3D

-

在线 Demo:https://huggingface.co/spaces/VAST-AI/MIDI-3D

技术突破:从单张图像到三维组合场景的关键创新

传统的组合式 3D 场景重建技术往往依赖于多阶段的逐个物体生成和场景优化,流程冗长且生成的场景往往几何质量低、空间布局不准确。为解决这些问题,MIDI (Multi-Instance Diffusion Model)创新性地利用了三维物体生成模型,将其扩展为多实例扩散模型,能够同时生成具有精确空间关系的多个 3D 实例,实现了高效高质量的 3D 场景生成:

-

单物体到多实例生成的跨越:通过同时去噪多个 3D 实例的潜在表示,并在去噪过程中引入多实例标记之间的交互,MIDI 将 3D 物体生成模型扩展至同时生成有交互建模的多实例,而后直接组合为 3D 场景。

-

多实例自注意力机制:通过将物体生成模型的自注意力扩展至多实例自注意力,MIDI 在生成过程中有效捕获实例间的空间关联和整体场景的连贯性,而无需逐场景的布局优化。

-

训练阶段的数据增强:通过使用有限的场景数据监督 3D 实例间的交互,同时结合物体数据进行增强训练,MIDI 有效建模场景布局的同时保持了预训练的泛化能力。

效果展示

基于单张图像,MIDI 可以生成高质量的组合式 3D 场景:

在线演示

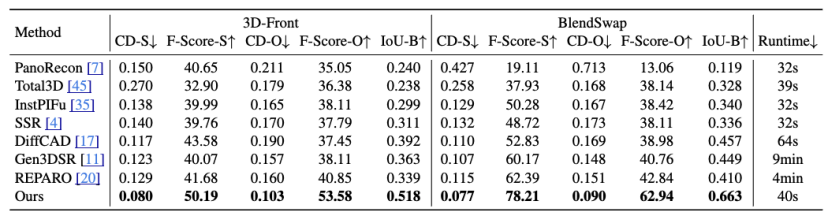

卓越性能:在几何质量和空间布局等多个维度上表现突出

MIDI 的主要特点在于其精确的空间布局建模、卓越的几何生成质量、生成的高效性和广泛的适用性。实验结果显示,该模型在多个数据集上的表现超越现有方法,包括 3D 实例间的空间关系、3D 实例生成的几何质量、以及端到端的生成速度均取得了优异的表现。

应用场景:3D 场景内容创作的新工具

MIDI 的出现为 3D 场景的创作提供了一种崭新的解决方案。在建筑设计、虚拟现实、影视特效以及游戏开发等领域,该技术展现了广阔的应用潜力。通过具备高准确度、高几何质量的 3D 场景生成能力,MIDI 能够满足复杂场景中对高质量内容的需求,为创作者带来更多可能性。

未来展望

尽管模型表现优异,MIDI 研发团队深知仍有许多值得提升和探索的方向。例如,进一步优化对复杂交互场景的适配能力、提升物体生成的精细度等,都是未来努力的重点。希望通过不断改进和完善,让这一研发思路不仅推动单视图生成组合 3D 场景技术的进步,也能为 3D 技术在实际应用中的广泛普及贡献力量。

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:[email protected]