作者:张拳石、陈鹭

近些年,大模型的发展可谓是繁花似锦、烈火烹油。从 2018 年 OpenAI 公司提出了 GPT-1 开始,到 2022 年底的 GPT-3,再到现在国内外大模型的「百模争锋」,DeepSeek 异军突起,各类大模型应用层出不穷。

然而,无论在学术界还是在工业界,目前对大模型应用的评测都是单纯在模型输出层面判断结果的准确性,而没有从大模型内在精细决策逻辑的角度来分析模型的可靠性。类比到人类社会,「实现内在精细逻辑对齐」才是实现人与人互信的基础。

无法在内在逻辑上与人类认知沟通,也恰恰是黑盒智能模型无法取得信任的本质——在可信问题上的「人」「机」有别,其主要问题并不在哲学、社会学方面,而是一个数学问题:能否严格地证明神经网络在单个样本上输出背后的千万种不同变换,都可以在数值上严格表示为一个简单的逻辑图模型。

但是,因为神经网络的复杂结构与所需要的清晰逻辑解释是天然冲突的,所以「从数学上严格地解释大模型内在的精细决策逻辑」长期以来被认为是一个不可能完成的问题。好在沉舟侧畔千帆过,柳暗花明又一村。我们构建了等效交互理论体系,发表了几十篇论文,在一定程度上证明并成功实现了对大部分神经网络的符号化解释。

相关链接:

https://zhuanlan.zhihu.com/p/693747946

https://mp.weixin.qq.com/s/MEzYIk2Ztll6fr1gyZUQXg

大模型金玉其外,败絮其中

一旦有了严谨的解释性理论工具,当我们可以清晰地解构出大模型的内在决策逻辑时,我们惊讶地发现,哪怕大模型在特定任务上展现出再高的准确率,其内在的决策逻辑表征可谓是一塌糊涂,甚至一半以上都是混乱的、完全与正常推理逻辑不沾边的。

很多应用需求是创造出来的。比如,在新的研究 [3] 中,我们以法律大模型为例,目前几乎所有的法律大模型应用仅仅关注判案结果的正确性,而忽视了法律推理过程中可能潜在的不公平和伦理风险。

然而,当你第一次确切地解构出一个法律大模型所使用的大量复杂、却又一塌糊涂的决策逻辑时,当你在各种情景中验证了这些错误逻辑的客观存在及其数值严谨性时,很多认知就回不去了,就像见过元素周期表以后,五行炼丹也就回不去了。

我们发现,法律大模型经常错误地将与案件无关的时间、位置信息视为法律判决的理由,或者「张冠李戴」地将一个被告的行为引为其他被告的判案依据。

时代洪流滚滚向前,让我们看看都发生了什么。

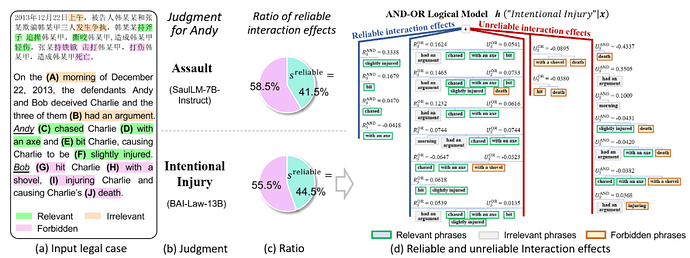

图 1. 对 SaulLM-7B-Instruct 在案例 1 的解释

让我们考虑一个输入案例 ,它包含

,它包含 个输入变量(这里可以是案例中的各个短语),我们用集合

个输入变量(这里可以是案例中的各个短语),我们用集合 表示这些输入变量的全集。由大模型生成的一个包含

表示这些输入变量的全集。由大模型生成的一个包含 个 tokens 的自然语言序列,

个 tokens 的自然语言序列, 。这样,大模型输出结果的置信度得分

。这样,大模型输出结果的置信度得分 可以定义为:

可以定义为:

其中, 表示在生成第

表示在生成第 个 token 之前的前

个 token 之前的前 个tokens 组成的序列。

个tokens 组成的序列。 表示给定输入句子

表示给定输入句子 和前

和前 个tokens 的条件下生成第

个tokens 的条件下生成第 个token的概率。

个token的概率。

这样,我们可以构造出一个「与或交互逻辑模型」。

这个逻辑模型中包含「与交互」和「或交互」两类操作。触发函数 表示一个「与交互」,当且仅当集合

表示一个「与交互」,当且仅当集合 中全部输入变量都被包含(没有被遮挡)在样本

中全部输入变量都被包含(没有被遮挡)在样本 时,函数

时,函数 被激活,并返回 1;否则返回 0。

被激活,并返回 1;否则返回 0。

类似地,触发函数 表示一个「或交互」,当集合

表示一个「或交互」,当集合 中任一输入变量被包含(没有被遮挡)在样本

中任一输入变量被包含(没有被遮挡)在样本 时,函数

时,函数 被激活,并返回 1;否则返回 0。

被激活,并返回 1;否则返回 0。

无限拟合性:我们证明,无论我们如何随机遮挡 个输入单元,得到

个输入单元,得到 个不同的遮挡输入,构造出的与或交互模型总可以精确近似出神经网络在这所有

个不同的遮挡输入,构造出的与或交互模型总可以精确近似出神经网络在这所有 个遮挡状态下对生成目标的输出置信度得分。

个遮挡状态下对生成目标的输出置信度得分。

这里 表示遮挡输入样本

表示遮挡输入样本 中属于集合

中属于集合 中的输入单元,仅保留属于集合

中的输入单元,仅保留属于集合 中的输入单元的遮挡样本。

中的输入单元的遮挡样本。

图 2. 与或交互的无限拟合性

需要注意的是,与或交互解释显示,不同于惊艳的应用性能所展示的对大模型推理能力的想象,大模型的大部分决策逻辑并不是严密的、清晰的、层次化的逻辑链条,大部分交互概念仅仅表示词汇之间的统计关联性。类似于「词袋」模型,当大模型基于输入 prompt 生成下一个单词或 token 时,其所依赖的交互效用大部分并没有利用输入上下文之间的逻辑关系,大部分决策依赖于词汇间最浅表的统计关联性来「盲猜」目标单词。

比如,在上文案例中,大模型仅仅根据「chased」为生成的判决结果「Assault」给出了 0.3811 的置信度,而单独一个「with an axe」短语也会为「Assault」判决增加 0.4632 的置信度。

固然这些单词与判决结果有统计意义的强相关性,但是大模型的决策依据并没有试图建模这些单词与犯罪嫌疑人之间的切实关系,并没有理解哪些犯罪嫌疑人做了什么事儿,也就导致了大模型可能产生一些看似正确的结果,但是其推理过程中可能潜在巨大的伦理风险。

例如,在下面的案例中我们将展示大模型常常将不同犯罪嫌疑人的行为进行张冠李戴,使其他犯罪嫌疑人的行为影响到目标犯罪嫌疑人的判罚。

案例:张冠李戴,根据其他犯罪嫌疑人的行为做出判决

模型:BAI-Law-13B [1]

输入:On the morning of December 22, 2013, the defendants Andy and Bob deceived Charlie and the three of them had an argument. Andy chased Charlie with an axe and bit Charlie, causing Charlie to be slightly injured. Bob hit Charlie with a shovel, injuring Charlie and shovel causing Charlie's death.

输出:Intentional Injury,输出置信度数值 2.3792

图 3. 对 BAI-Law-13B 模型和 SaulLM-7B-Instruct 模型在案例 1 上的解释

法律 LLM 很大一部分交互模式错误地使用了犯罪嫌疑人的行为来对另一个无关的犯罪嫌疑人做出判决,显示出大模型存在的一种典型缺陷——张冠李戴。

大模型倾向于记忆敏感词语(如武器)与输出结果之间的相关性,而不是理解输入 prompt 中真正的逻辑,例如识别谁做了哪些行为。

案例显示,Andy 咬伤 Charlie,构成伤害罪,随后 Bob 用铁锹击打 Charlie,导致 Charlie 死亡。案例经由法律专家将与判决相关的实体行为标记为相关词语,与判决不相关的词语标记为不相关词语,以及将不应影响判决的不正确的实体行为标记为禁止词语。

在这起案件中,当法律大模型判决 Andy 行为的后果时,「hit」「with a shovel」「injuring」和「death」等描述 Bob 的行为和后果的词语应被标记为禁止词语,与Andy没有直接关系。

在英文法律大模型 SaulLM-7B-Instruct 前 50 个最突出的 AND-OR 交互模式中,有 26 个 AND 交互模式和 24 个 OR 交互模式。如图 1,可以看出 AND 交互模式 ,AND 交互模式

,AND 交互模式 ,OR 交互模式

,OR 交互模式  分别对 Andy 的判决贡献了显著的可靠交互效应 = 0.47、= 0.33、= 0.09。然而,大模型也使用了描述 Bob 的行为和后果的禁止词语得出对 Andy 的判决,例如,AND 交互模式

分别对 Andy 的判决贡献了显著的可靠交互效应 = 0.47、= 0.33、= 0.09。然而,大模型也使用了描述 Bob 的行为和后果的禁止词语得出对 Andy 的判决,例如,AND 交互模式 ,

, ,

, 等对 Andy 的判决产生不可靠的交互效应 = -1.04、= 0.93、= 0.19。

等对 Andy 的判决产生不可靠的交互效应 = -1.04、= 0.93、= 0.19。

在中文法律大模型 BAI-Law-13B 前 50 个最突出的 AND-OR 交互模式中,有 17 个 AND 交互模式和 33 个 OR 交互模式。如图 3,可以看出 AND 交互模式  ,AND 交互模式

,AND 交互模式 ,OR 交互模式

,OR 交互模式  分别对 Andy 的判决贡献了显著的可靠交互效应 = 0.33、= 0.17、= 0.06。然而,大模型也使用了描述 Bob 的行为和后果的禁止词语得出对 Andy 的判决,例如,AND 交互模式

分别对 Andy 的判决贡献了显著的可靠交互效应 = 0.33、= 0.17、= 0.06。然而,大模型也使用了描述 Bob 的行为和后果的禁止词语得出对 Andy 的判决,例如,AND 交互模式  ,OR 交互模式

,OR 交互模式 ,

, 等对 Andy 的判决产生不可靠的交互效应 = -0.43、= -0.09、= -0.04。

等对 Andy 的判决产生不可靠的交互效应 = -0.43、= -0.09、= -0.04。

这里大模型用的不可靠交互比例为 55.5%-58.5%。

图 4.交互概念解释率先揭示了大模型精细表征逻辑的隐患。大模型没有建模「长链推理」逻辑,而使用大量「张冠李戴」的局部信息来生成判决结果,引起了不容忽视的伦理问

图 4 展示了 BAI-Law-13B 模型在中文案例上的解释,判案所依据的大部分交互概念都是与目标犯罪嫌疑人无关的张冠李戴的交互概念。

参考文献

[1] Baiyulan Open AI Research Institute. 2023. Baiyulan Open AI. (2023). https://baiyulan.org.cn

[2] Pierre Colombo, Telmo Pessoa Pires, Malik Boudiaf, Dominic Culver, Rui Melo, Caio Corro, Andre F. T. Martins, Fabrizio Esposito, Vera Lúcia Raposo, Sofia Morgado, and Michael Desa. SaulLM-7B: A pioneering Large Language Model for Law. arXiv preprint arXiv:2403.03883 (2024)

[3] Lu Chen, Yuxuan Huang, Yixing Li, Yaohui Jin, Shuai Zhao, Zilong Zheng, Quanshi Zhang, "Alignment Between the Decision-Making Logic of LLMs and Human Cognition: A Case Study on Legal LLMs" in arXiv:2410.09083, 2024.

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:liyazhou@jiqizhixin.com

,它包含

,它包含 表示这些输入变量的全集。由大模型生成的一个包含

表示这些输入变量的全集。由大模型生成的一个包含 。这样,大模型输出结果的置信度得分

。这样,大模型输出结果的置信度得分 可以定义为:

可以定义为:

表示在生成第

表示在生成第 个tokens 组成的序列。

个tokens 组成的序列。 表示给定输入句子

表示给定输入句子 个tokens 的条件下生成第

个tokens 的条件下生成第

表示一个「与交互」,当且仅当集合

表示一个「与交互」,当且仅当集合 中全部输入变量都被包含(没有被遮挡)在样本

中全部输入变量都被包含(没有被遮挡)在样本 时,函数

时,函数 被激活,并返回 1;否则返回 0。

被激活,并返回 1;否则返回 0。

表示一个「或交互」,当集合

表示一个「或交互」,当集合 中任一输入变量被包含(没有被遮挡)在样本

中任一输入变量被包含(没有被遮挡)在样本 时,函数

时,函数 被激活,并返回 1;否则返回 0。

被激活,并返回 1;否则返回 0。

中的输入单元,仅保留属于集合

中的输入单元,仅保留属于集合 中的输入单元的遮挡样本。

中的输入单元的遮挡样本。

,AND 交互模式

,AND 交互模式 ,OR 交互模式

,OR 交互模式  分别对 Andy 的判决贡献了显著的可靠交互效应 = 0.47、= 0.33、= 0.09。然而,大模型也使用了描述 Bob 的行为和后果的禁止词语得出对 Andy 的判决,例如,AND 交互模式

分别对 Andy 的判决贡献了显著的可靠交互效应 = 0.47、= 0.33、= 0.09。然而,大模型也使用了描述 Bob 的行为和后果的禁止词语得出对 Andy 的判决,例如,AND 交互模式 ,

, ,

, 等对 Andy 的判决产生不可靠的交互效应 = -1.04、= 0.93、= 0.19。

等对 Andy 的判决产生不可靠的交互效应 = -1.04、= 0.93、= 0.19。

,AND 交互模式

,AND 交互模式 ,OR 交互模式

,OR 交互模式  分别对 Andy 的判决贡献了显著的可靠交互效应 = 0.33、= 0.17、= 0.06。然而,大模型也使用了描述 Bob 的行为和后果的禁止词语得出对 Andy 的判决,例如,AND 交互模式

分别对 Andy 的判决贡献了显著的可靠交互效应 = 0.33、= 0.17、= 0.06。然而,大模型也使用了描述 Bob 的行为和后果的禁止词语得出对 Andy 的判决,例如,AND 交互模式  ,

,