自 OpenAI 发布 Sora 以来,视频生成领域迎来爆发式增长,AI 赋能内容创作的时代已然来临。

去年 4 月,生数科技联合清华大学基于团队提出的首个扩散 Transformer 融合架构 U-ViT,发布了,打破国外技术垄断,支持一键生成 16 秒高清视频,展现出中国科技企业的创新实力。Vidu 自去年 7 月上线以来,已服务数千万用户,极大促进了视频内容的智能创作。近期,、等开源视频生成模型相继亮相,可生成 5-6 秒视频,进一步降低了视频创作门槛。

尽管如此,海内外社区仍有不少用户抱怨现有开源模型受限于生成 5-6 秒的短视频,时长不够用。

今天,Vidu 团队带来了一个简洁优雅的解决方案 ——RIFLEx。新方案仅需一行代码、无需额外训练即可突破视频生成模型现有长度限制,打破「短视频魔咒」。目前该项目已经开源,体现了团队对开源社区的积极回馈和贡献。

RIFLEx适用于基于RoPE的各类Video Diffusion Trasnsformer,例如CogvideoX、混元(链接到之前推送)以及最新发布的通义万相(链接到之前的推送)。

下列为开源模型无需任何训练直接时长外推两倍至10s效果:

prompt: 一只棕白相间的动画豪猪好奇地审视着缎带装饰的绿色盒子,灵动的眼神与细腻的3D动画风格营造出温馨而精致的视觉体验。

prompt: 荒凉空地上的简易营地散布着无人机与物资,军人与平民共处,一名男子绝望抱头,女子忧虑注视,沉重氛围暗示刚经历重大事件,镜头稳定细腻,突出紧张与不安感。

sora的经典长毛猛犸象prompt

在短视频微调几千步可进一步提升性能。

prompt: 蓬乱头发、穿棕色夹克系红色领巾的男子在马车内严肃端详硬币,与女子交谈,广角与中近景结合展现历史剧风格与戏剧氛围。

prompt: 动画中的兔子和老鼠,身穿探险装备正处于险境之中。它们急速坠入一个黑暗而未知的空间,紧接着便漂浮并游动在宁静的水下世界里。紧张而坚定的表情通过中景与特写展现,高质量3D动画风格增强电影感与沉浸感。

prompt: 留着胡须、穿格子衬衫的男子坐着弹奏原声吉他,沉浸于激情演唱。他所在的室内环境简洁,背景是一面纯灰色墙壁,左侧放置着一个吉他音箱和麦克风架,右侧摆放着一叠书籍。

除此之外,RIFLEx 不仅支持视频的时间维度外推(如基于已有帧生成未来帧或延长视频时序长度),还可扩展至空间维度外推(如通过局部画面超分辨率重建、修复缺失区域或扩展视频边界内容),以及可同时进行的时空外推(如生成未来高分辨率视频序列或动态扩展视频的时空内容,兼顾时间连续性与空间一致性)。

左图为训练尺寸,右图为外推结果

左图为训练尺寸,右图为外推结果

左图为训练尺寸,右图为外推结果

训练尺寸:480*720*49

外推结果:960*1440*97

该研究成果一经发布,获得了广泛关注。

知名博主 Ak 第一时间转发,海外科技公司和博主称赞其为「视频扩散模型领域的突破性创新」。

Diffusers 核心贡献者 sayakpaul 和 a-r-r-o-w 也收藏了代码并留言点赞:

目前 RIFLEx 已被社区用户集成到各类知名视频生成仓库:

揭秘 RIFLEx:化繁为简,直击本质

长度外推问题在大型语言模型中早有研究,但这些方法在视频生成中却屡屡碰壁,导致时序内容重复或慢动作效果。

直接外推导致视频内容重复,红色框表示开始和视频开头重复

同时结合外推和内插的Yarn导致慢动作效果

为破解这一难题,Vidu 团队深入挖掘 RoPE 的频率成分,揭示了其每个频率成分在视频生成的作用:

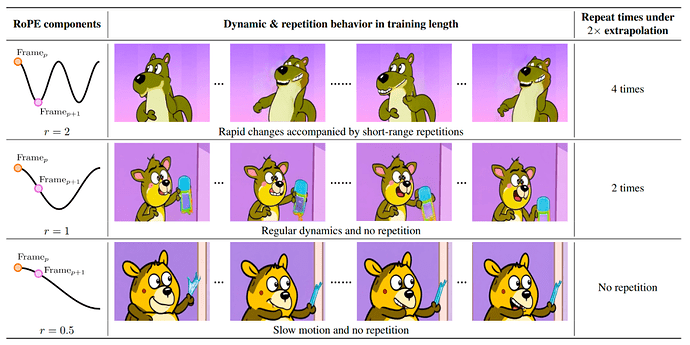

1. 时间依赖距离:不同频率成分只能捕捉特定周期长度的帧间依赖关系。当帧数超过周期长度时,周期的性质导致位置编码重复,从而使视频内容也会出现重复。

2. 运动速度:不同频率成分捕捉不同的运动速度,由该频率的位置编码变化率决定。高频成分捕捉快速运动,低频成分捕捉慢速运动。

当所有频率成分结合时,存在一个 「内在频率」,即周期距离首次观测重复帧最近的成分,它决定了视频外推时的重复模式。

基于此,团队提出 RIFLEx:通过降低内在频率,确保外推后的视频长度在一个周期内,从而避免内容重复。该方法仅需在经典 RoPE 编码中加入一行代码即可实现。

这一方案为视频生成领域提供了新的思路,有望推动长视频生成技术的进一步发展。

团队介绍

论文第一作者赵敏为清华大学TSAIL 团队博后研究员,研究方向为基于扩散模型的视觉内容生成。赵敏是生数科技视频生成大模型Vidu的核心开发者之一,此前以第一作者发表在NeurIPS、ICLR、ECCV等顶级会议和期刊发表论文数篇,并入选2024年清华大学“水木学者”。个人主页:https://gracezhao1997.github.io/。

清华大学 TSAIL 团队长期致力于扩散模型的研究,代表性工作包括Analytic-DPM(ICLR 2022 杰出论文奖)、U-ViT、DPM-solver、ProlificDreamer等,并研制了首个对标Sora的高动态、长时长的视频生成大模型Vidu。论文其他作者均为TSAIL 课题组学生,其中何冠德和朱泓舟也参与了Vidu的开发,陈亦逍为清华大学计算机系大三本科生,李崇轩已经毕业,现任中国人民大学高瓴人工智能学院副教授。

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:liyazhou@jiqizhixin.com