DeepSeek 利用 GRPO 提升大型语言模型推理能力,该方法无需价值网络,采用群组采样和相对优势估计,更高效稳定。

原文标题:DeepSeek 背后的技术:GRPO,基于群组采样的高效大语言模型强化学习训练方法详解

原文作者:数据派THU

冷月清谈:

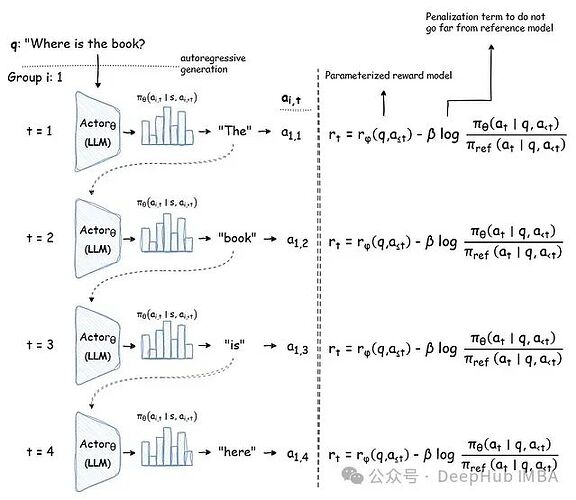

GRPO 将语言模型作为策略网络,输入问题,输出词元序列作为动作。每个词元的生成都依赖于之前的序列,策略网络维护并更新上下文信息。在奖励计算方面,GRPO 根据词元序列的质量给予奖励,并通过群组采样对奖励进行归一化处理,以此来估计优势值。最终,GRPO 通过最大化目标函数来优化策略模型,该目标函数包含策略梯度项、裁剪项和 KL 散度惩罚项,以确保策略更新的有效性和稳定性。

DeepSeek-Math 和 DeepSeek-R1 模型的成功应用案例证明了 GRPO 在提升语言模型数学推理和问题解决能力方面的有效性。GRPO 的出现为语言模型训练提供了新的思路,未来研究方向包括改进优势估计方法、自适应超参数调整以及更深入的理论分析。

怜星夜思:

2、文章中提到了 GRPO 的一些局限性,比如对参考策略的依赖。那么如何选择合适的参考策略以及如何降低这种依赖性呢?

3、GRPO 在其他类型的 NLP 任务中,例如文本分类、机器翻译等,是否有应用潜力?

原文内容

来源:Deephub Imba本文约2100字,建议阅读8分钟本文将深入分析 GRPO 的工作机制及其在语言模型训练领域的重要技术突破,并探讨其在实际应用中的优势与局限性。

强化学习(Reinforcement Learning, RL)已成为提升大型语言模型(Large Language Models, LLMs)推理能力的重要技术手段,特别是在需要复杂推理的任务中。DeepSeek 团队在 DeepSeek-Math [2] 和 DeepSeek-R1 [3] 模型中的突破性成果,充分展示了强化学习在增强语言模型数学推理和问题解决能力方面的巨大潜力。

这些成果的取得源于一种创新性的强化学习方法——群组相对策略优化(Group Relative Policy Optimization, GRPO)。该方法有效解决了将强化学习应用于语言模型时面临的特殊挑战。本文将深入分析 GRPO 的工作机制及其在语言模型训练领域的重要技术突破,并探讨其在实际应用中的优势与局限性。

PPO 与 GRPO 的对比分析

近邻策略优化(Proximal Policy Optimization, PPO)[1] 一直是语言模型强化学习微调的主流算法。PPO 的核心是一种策略梯度方法,通过裁剪(clipping)机制来限制策略更新的幅度,从而防止策略发生过大的破坏性变化。PPO 的目标函数可表示为:

GRPO 首次在文献 [2] 中提出,它在 PPO 的基础上引入了多项关键创新,使其在语言模型训练中具有更高的效率和适用性:

-

无需价值网络,显著降低了内存占用和计算开销;

-

采用群组采样方法,实现更高效且稳定的优势估计;

-

通过强化目标函数和奖励的惩罚机制,实现更保守的策略更新。

更详细的对比:

GRPO 技术深析

语言模型作为策略网络

在 GRPO 框架中,语言模型充当策略网络(actor),将问题 q 作为输入观察 s,输出一系列词元(tokens)作为动作。策略分布在词元序列上进行分解:

注: 原始论文 [2] 使用 o_t 表示时间步 t 的输出词元,而本文采用 a_t 以符合强化学习中动作的标准记号。

序列化词元生成

基于 Transformer 架构和语言模型的自回归特性,生成过程具有严格的序列性:

-

每个词元的生成都依赖于之前生成的词元序列;

-

策略网络(语言模型)维护持续更新的上下文信息;

-

每个词元生成步骤都可视为强化学习框架中的一个动作 a_t。

奖励计算与优势估计

GRPO 对每个生成序列中的词元奖励计算如下:

GRPO 摒弃了传统的价值网络,转而通过对参考策略产生的多个输出样本进行群组奖励归一化来估计基线优势值 A。这些输出样本都是针对同一输入问题生成的:

优势估计的详细步骤:

-

群组采样: 对于每个问题,使用旧策略生成多个不同的输出序列。

-

奖励计算: 计算每个输出序列的累积奖励。

-

奖励归一化: 对群组内的奖励进行归一化处理,例如减去均值并除以标准差。

-

优势估计: 使用归一化后的奖励作为优势函数的估计值。

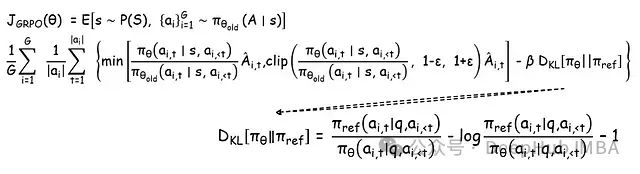

GRPO 目标函数

对于每个问题 𝑞,GRPO 从旧策略 𝜋𝜃𝑜𝑙𝑑 中采样一组输出 {𝑜1, 𝑜2, · · · , 𝑜𝐺},然后通过最大化 GRPO 目标函数来优化策略模型。完整的 GRPO 目标函数综合了以下要素:

该目标函数的特点:

-

同时在群组和序列长度维度上进行平均;

-

使用裁剪机制确保策略更新的保守性;

-

引入 KL 散度估计作为惩罚项,防止策略与参考模型产生过大偏离。

目标函数的详细解释:

-

第一项: 策略梯度项,鼓励模型生成更高奖励的动作序列。

-

第二项: 裁剪项,限制策略更新的幅度,防止策略崩溃。

-

第三项: KL 散度惩罚项,防止新策略与旧策略偏离过大,保证训练的稳定性。

GRPO 的优势与局限性

优势:

-

高效性: 无需价值网络,降低了计算和内存开销。

-

稳定性: 群组采样和 KL 散度惩罚提高了训练的稳定性。

-

适用性: 特别适用于大规模语言模型的微调。

局限性:

-

对参考策略的依赖: GRPO 的性能受到参考策略质量的影响。

-

超参数敏感: 目标函数中的超参数(如裁剪范围和 KL 散度系数)需要仔细调整。

-

理论分析的缺乏: 相比于 PPO,GRPO 的理论分析还不够完善。

实际应用案例

DeepSeek-Math 和 DeepSeek-R1 是 GRPO 在实际应用中的成功案例。这些模型在数学推理和问题解决能力方面取得了显著的提升,证明了 GRPO 在增强语言模型推理能力方面的有效性。

DeepSeek-Math: 通过 GRPO 训练,DeepSeek-Math 在数学问题解决能力上超越了许多其他大型语言模型。

DeepSeek-R1: DeepSeek-R1 利用 GRPO 提高了在复杂推理任务中的表现,例如阅读理解和逻辑推理。

总结

GRPO 在将强化学习应用于语言模型方面取得了重要突破。通过取消价值网络依赖并引入群组相对优势估计,该方法实现了更高效和稳定的训练过程。DeepSeek-Math 和 DeepSeek-R1 的成功实践充分验证了这种方法的实际效果。

GRPO 的核心创新——群组采样、相对优势估计以及价值网络的简化——为语言模型训练的未来发展提供了重要的技术参考。随着语言模型能力边界的不断拓展,GRPO 等创新技术将在充分发挥语言模型潜力方面发挥关键作用。未来的研究方向包括:

-

改进优势估计方法: 探索更精确和高效的优势估计方法。

-

自适应超参数调整: 开发自动调整 GRPO 超参数的算法。

-

理论分析: 加强对 GRPO 算法的理论分析,理解其收敛性和泛化能力。

参考

[1] Schulman, John, et al. Proximal Policy Optimization Algorithms. arXiv:1707.06347

[2] Shao, Zhihong, et al. DeepSeekMath: Pushing the Limits of Mathematical Reasoning in Open Language Models. arXiv:2402.03300,

[3] DeepSeek-AI, et al. DeepSeek-R1: Incentivizing Reasoning Capability in LLMs via Reinforcement Learning. arXiv:2501.12948,