随着 AI 能力的提升,一个常见的话题便是基准不够用了——一个新出现的基准用不了多久时间就会饱和,比如 Replit CEO Amjad Masad 就预计 2023 年 10 月提出的编程基准 SWE-bench 将在 2027 年饱和。

也因此,为了更加准确地评估 AI 模型的能力,不断有研究团队构建出新的数据集和基准,比如我们前段时间报道过的 和 ,它们都带有大量当前的 AI 模型难以解决的难题。

近日,谷歌也发布了一个高难度基准:BIG-Bench Extra Hard,简称 BBEH。从名字也能看出来,这个基准非常难(Extra Hard)并且与久负盛名的 BIG-Bench 和 BIG-Bench Hard(BBH)关系密切。

-

论文标题:BIG-Bench Extra Hard

-

论文地址:https://arxiv.org/pdf/2502.19187

-

数据地址:https://github.com/google-deepmind/bbeh

正如其论文一作 Mehran Kazemi 指出的那样,相比于 BIG-Bench Hard,BBEH 中每个任务都更加困难,给当前所有模型都创造了进步空间。

另一位作者、DeepMind 著名研究科学家 Yi Tay 也建议 AI 研究者在自己的下一篇论文中使用该基准。

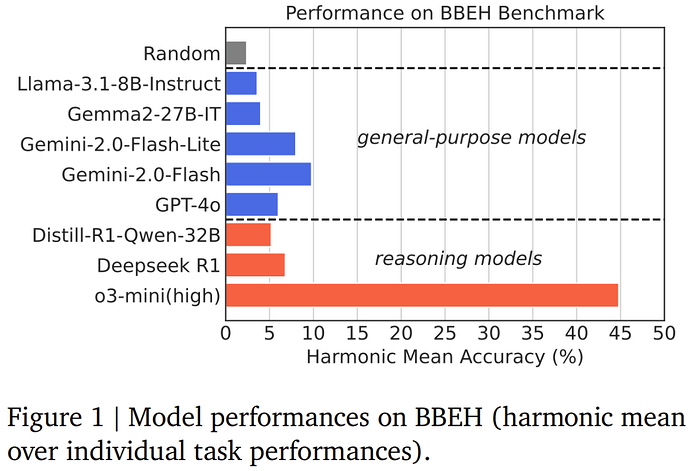

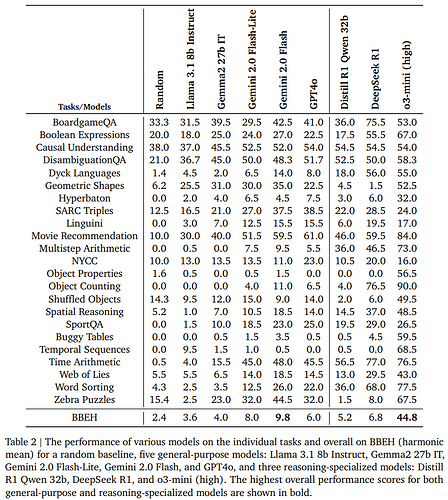

那么,BBEH 究竟有多难呢?当前能力最强的 o3-mini (high) 得分也仅有 44.8 分,不及格。而其它被测模型的得分均不超过 10 分!DeepSeek-R1 仅有 6.8,谷歌自家的 Gemini-2.0-Flash 也只有 9.8。遗憾的是,该团队并没有给出近期发布的 Grok-3 与 Claude 3.7 Sonnet 的表现。

该团队在论文中解释了构建 BBEH 基准的动机,其中指出目前对推理模型的评估大都依赖数学、科学和编程基准,而涉及到更多方面的 BIG-Bench 及其更难的子集 BIG-Bench Hard(BBH)基准则正趋向饱和 —— 当前领先的模型在 BBH 上的准确度都已经超过 90%。因此,BBH 已经无力评估前沿模型的推理能力。

BBEH 便应运而生,其设计目标是「评估高阶推理能力」。

BIG-Bench Extra Hard

BBEH 是基于 BBH 构建的——将 BBH 中的 23 个任务中的每一个都替换成了另一个在类似推理领域中并测试类似(或更多)技能的任务,当然,新任务的难度要大得多。这种替换方法可以确保新数据集保留了原始 BBH 数据集的高度多样性。

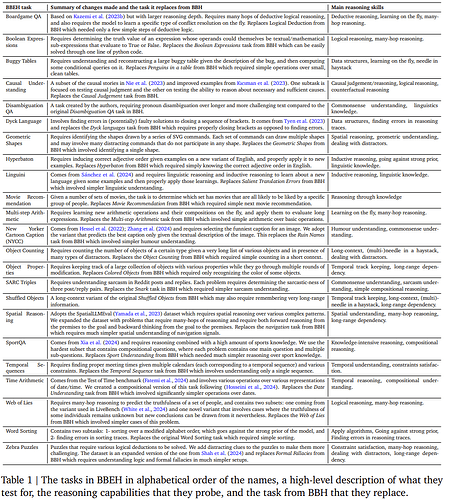

表 1 给出了 BBEH 中新任务的高层级描述,包括它们是如何构建的以及它们替换了 BBH 中的哪个任务,以及它们针对哪些推理技能。

该基准中,每个任务包含 200 个问题,但 Disambiguation QA 任务例外,有 120 个问题。

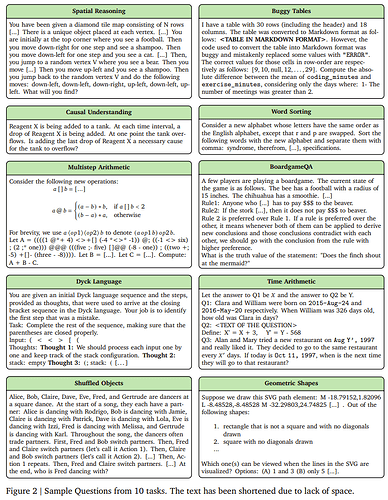

下图展示了一些具体任务示例:

该论文的详细创建过程以及对 BBEH 数据集的分析请参阅原论文,下面我们重点来看看前沿模型在该基准上的表现以及相关分析结果。

模型表现及分析

首先来看各家前沿模型的表现如何,下表是准确度分数详情。

根据此结果,该团队得出了几个有趣的观察:

-

模型在各个任务上都有很大的进步空间,在 BBEH 整体上也是如此。

-

通用模型的最佳性能为 9.8% 的调和平均准确率。推理专用模型在该基准上的表现优于通用模型(符合预期),但这些模型在 BBEH 上的最佳性能仍只有 44.8%。

-

尽管采用了对抗性结构,但参考 Thinking 模型在 BBEH 上的调和平均准确率仍只有 20.2%。

-

一些模型的准确率甚至低于随机性能。经检查,他们发现原因大多是模型无法在有效输出 token 长度内解决问题并在某个点之后开始退化,因此无法从其解答中提取出最终答案。

另外,还能看到不同模型擅长不同类型的推理。例如,DeepSeek R1 在 BoardgameQA 上的表现明显优于其他模型,o3-mini (high) 在 Temporal Sequences 和 Object Properties 上的表现明显优于其他模型,GPT4o 在 NYCC 上的表现明显优于其他模型,GPT4o 和 Gemini 2.0 Flash 在 SARC Triples 上的表现明显优于其他模型。

该团队还进行了进一步的结果分析。

通用模型与推理模型

推理模型可以利用更多测试时间计算进行思考,因此在涉及数学和编码的推理任务上实现了巨大的性能飞跃。例如,在 AIME2024 数据集上,GPT4o 的性能为 13.4%,但 o1 模型将其提高到 83.3%,o3-mini (high) 将其进一步提高到 87.3%。

在这里,该团队检查了不同类型的一般推理是否也是如此。

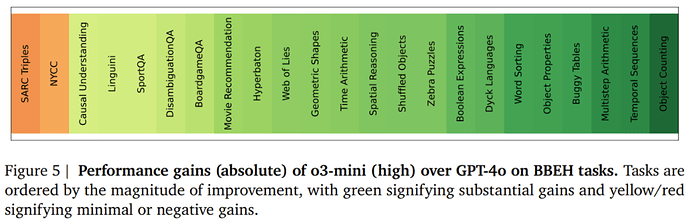

如图 5 所示,该团队分别将 o3-mini (high) 和 GPT4o 作为推理和一般模型的模范,在 BBEH 的每个任务上进行了比较,并根据 o3-mini (high) 相对于 GPT4o 的增益程度对任务进行升序排序。

可以观察到,增益最大的任务是那些涉及计数、规划、算术以及数据结构和算法的任务。而增益最少(有时为负值)的任务大多涉及常识、幽默、讽刺和因果关系。

结果表明,推理模型在解决形式化问题时会取得最显著的收益,而在处理复杂的现实场景时(通常需要软推理技能)则收益有限。

模型大小的影响

该团队还探讨了模型大小对模型性能的影响。

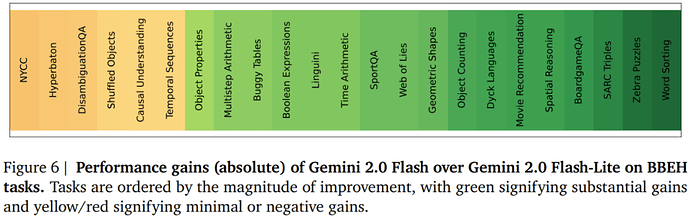

如图 6 所示,他们在 BBEH 的不同任务上比较了 Gemini 2.0 Flash 和 Gemini 2.0 Flash-Lite,并根据 Flash 相对于 Flash-Lite 的收益按升序方式对任务进行排序。

虽然信号不如将一般模型与推理模型进行比较时那么清晰,但仍然可以观察到与幽默、常识和因果推理相关的任务收益最少,而需要多跳推理或应用算法的任务收益最大。

一个特殊的例外是 SARC Triples 任务,这是一个讽刺理解任务,并且收益很大。这可能部分是由于 SARC Triples 中的每个样本都是三个子问题的组合,而较大的模型可能更擅长处理这种复合问题。

上下文长度和所需思考的影响

BBEH 中的任务具有不同的平均上下文长度,并且可能需要不同的思考量。基于此,可以了解上下文长度和所需思考对推理与一般模型以及较大模型与较小模型的影响。

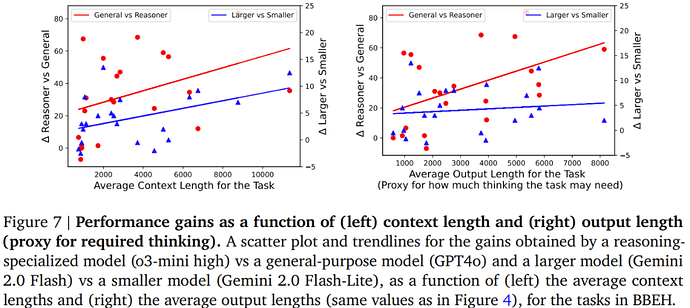

图 7 比较了 o3-mini (high) 与 GPT4o 以及 Gemini 2.0 Flash 与 Gemini 2.0 Flash-Lite 的性能,这里使用了任务平均上下文长度和平均输出长度作为所需思考的代理。

可以观察到,无论是在上下文长度增加时,还是在所需思考增加时,o3-mini 的收益都比 GPT4o 更高;这表明与一般模型相比,推理模型在两个方向上都可能有所改进。对于 Gemini 2.0 Flash 与 Gemini 2.0 Flash-Lite,可以看到当上下文长度增加时,收益也有类似的增长,但思考增加时,曲线基本保持平坦。

参考链接:

https://x.com/kazemi_sm/status/1894935166952349955

https://x.com/YiTayML/status/1894939679943991661

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:liyazhou@jiqizhixin.com