清华北大联合发布FreEformer模型,利用频域Transformer提升多元时序预测效果,解决注意力矩阵低秩问题。

原文标题:清华&北大联合发布:频域多元时序预测Transformer模型

原文作者:数据派THU

冷月清谈:

与传统时域模型相比,频域模型能够更好地捕捉时间序列的全局信息,例如不同时间片段的频域表征具有一致性,以及不同变量之间的相关性在频域中更为显著。

FreEformer模型首先对原始时间序列进行归一化和维度扩展,然后使用离散傅里叶变换将其转换到频域。转换后的实部和虚部分别输入到两个独立的多层Transformer模型中进行处理。处理后的输出再经过线性变换和逆向离散傅里叶变换转换回时域,最终得到预测结果。

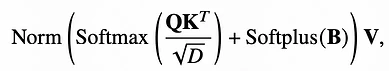

研究人员发现,在频域中使用Transformer时,生成的注意力矩阵存在低秩问题,这意味着提取的特征信息存在冗余。为了解决这个问题,他们对注意力机制进行了改进,在QK内积和softmax操作之后添加了一个可学习的矩阵B。这种改进相当于将注意力机制和MLP进行了融合,能够有效提升注意力矩阵的秩,从而提高特征多样性。

实验结果表明,FreEformer在长短周期的时间序列预测任务中均取得了显著的效果。

怜星夜思:

2、文章中提到Transformer在频域建模的attention矩阵具有低秩性,导致特征多样性较差。除了文中提出的方法,还有什么其他方法可以解决这个问题?

3、FreEformer 模型主要应用于哪些场景?相比于其他时序预测模型,它有哪些局限性?

原文内容

来源:圆圆的算法笔记本文约1000字,建议阅读5分钟

本文提出了一种基于频域Transformer的时间序列预测模型,并通过改造attention计算逻辑提升频域特征多样性。

论文标题:FreEformer: Frequency Enhanced Transformer for Multivariate Time Series Forecasting

下载地址:https://arxiv.org/pdf/2501.13989v1