NeurIPS 2024论文提出TGA-ZSR方法,利用文本引导注意力提升视觉语言模型零样本鲁棒性,显著增强对抗攻击防御能力。

原文标题:NeurIPS 2024 | 文本引导注意力在视觉-语言模型零样本鲁棒性中的关键作用

原文作者:数据派THU

冷月清谈:

怜星夜思:

2、TGA-ZSR 方法主要针对 CLIP 模型,这种方法能否推广到其他视觉语言模型,例如 ALBEF 或 BLIP?

3、除了文中提到的方法,大家觉得还有哪些策略可以提高视觉语言模型的零样本鲁棒性?

原文内容

一、前言概要

基于这一现象,作者提出了基于文本引导注意力的方法——Text-Guided Attention for Zero-Shot Robustness(TGA-ZSR),利用文本信息增强模型的对抗鲁棒性。

论文贡献总结如下:

-

首次引入文本引导注意力机制:创新性地引入文本引导注意力机制,以增强视觉-语言模型的零样本对抗鲁棒性,同时保持在干净示例上的高性能表现。

-

提升可解释性:通过文本引导的注意力机制,显著提高了对抗攻击在视觉-语言模型上零样本鲁棒性的可解释性,揭示了对抗示例与干净示例之间细微但关键的区别。

-

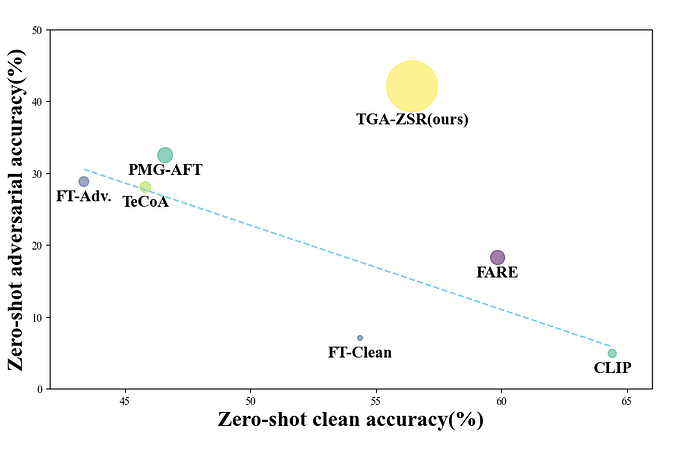

实验验证与新基准:实验结果显示,TGA-ZSR 超越了先前的方法,在模型的零样本对抗鲁棒性上建立了新的性能基准。

二、研究内容

具体观察发现,对抗示例的文本引导注意力发生了明显变化,表现为注意力向其他物体或背景偏移,甚至在某些情况下出现了注意力消失的现象。

基于这一现象,作者提出了基于文本引导注意力的方法 —— Text-Guided Attention for Zero-Shot Robustness(TGA-ZSR),旨在充分利用文本引导的注意力图来提升模型的对抗鲁棒性,同时保持在干净示例上的高性能。TGA-ZSR 的总体框架图如下所示:

▲ 图 2: TGA-ZSR 总体框架具体而言,主要的组件包含:

该模块专门设计用于校正对抗示例的文本引导注意力,这种注意力的偏差常常导致预测结果的改变。通过将对抗示例的注意力图与干净示例的注意力图对齐,该模块确保对抗示例能够获得与干净示例同样准确的注意力分布。这一简单而有效的策略有效地减轻了对抗扰动对于模型性能的影响。

虽然注意力精炼模块提升了模型的对抗鲁棒性,但可能会因为参数的变化而导致干净示例的准确性发生下降。为了保持视觉-语言模型的泛化能力,作者引入了基于注意力的模型约束模块。该模块的目标是避免干净图像性能下降,以确保模型的整体有效性和可靠性。

三、实验结果

3.1 实验细节

-

广泛使用的分类数据集:CIFAR-10、CIFAR-100、STL-10、ImageNet、Caltech-101、Caltech-256

-

细粒度分类数据集:StanfordCars、Flowers102、Food101、FGVCAircraft、OxfordPets

-

场景识别数据集:SUN397

-

医疗图像数据集:PCAM

-

卫星图像数据集:EuroSAT

-

纹理识别数据集:DTD

3.2 主要实验结果(Main Results)

表 3 显示,在 AutoAttack 上,所有方法的性能都有所下降。尽管 TGA-ZSR 也表现出一定的性能下降,但仍明显优于其他方法,实现了 30.86% 的零样本对抗鲁棒准确性,证明了它在面对更强有力的攻击时的有效性。

CW 实验结果:表 4 表明, TGA-ZSR 在对抗示例上的表现显著优于当前最佳的方法 PMG-AFT,实现了 40.50% 的最佳零样本对抗鲁棒准确性。

为了验证文本引导注意力的重要性,作者将其替换为根据 Grad-CAM 生成的基于视觉的注意力进行实验。表 5 显示,即使替换后,模型的零样本鲁棒准确性和干净准确性仍然可以与当前最佳的方法 PMG-AFT 相媲美,这一发现验证了该方法框架的有效性。

3.5 鲁棒性与干净准确性的权衡(Trade-off between Robust and Clean Accuracy)

四、研究总结

这一策略不仅防止模型漂移,还显著增强模型的对抗鲁棒性。大量的实验验证了 TGA-ZSR 的有效性,表明其在多种攻击类型下均表现出色,在鲁棒性和泛化性之间实现了优越的平衡。

编辑:黄继彦