AIxiv专栏是机器之心发布学术、技术内容的栏目。过去数年,机器之心AIxiv专栏接收报道了2000多篇内容,覆盖全球各大高校与企业的顶级实验室,有效促进了学术交流与传播。如果您有优秀的工作想要分享,欢迎投稿或者联系报道。投稿邮箱:liyazhou@jiqizhixin.com;zhaoyunfeng@jiqizhixin.com

在自然界中,好奇心驱使着生物探索未知,是生存和进化的关键。人类,作为地球上最具智能的物种,其探索精神引领了科技、文化和社会的进步。1492 年,哥伦布怀揣探索未知的理想,勇敢地向西航行,最终发现了新大陆。

正如人类在面对未知时展现出的探索行为,在人工智能领域,尤其在大型语言模型(LLMs)理解语言和知识中,研究人员正尝试赋予 LLM 类似的探索能力,从而突破其在给定数据集中学习的能力边界,进一步提升性能和安全性。

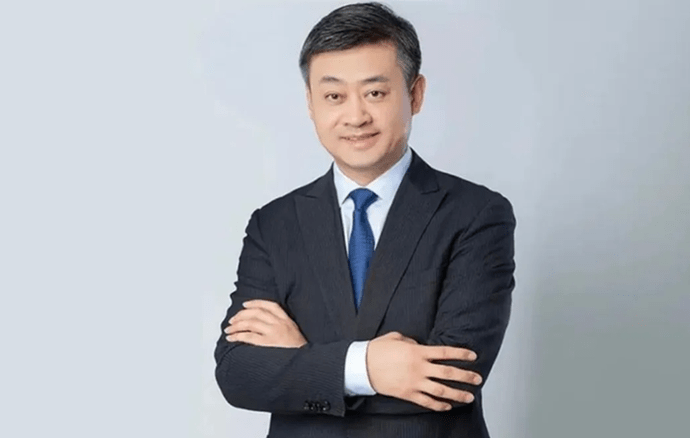

近期,中国电信集团 CTO、首席科学家、中国电信人工智能研究院(TeleAI)院长李学龙教授带领团队在全模态星辰大模型体系深耕的基础之上,联合清华大学、香港城市大学、上海人工智能实验室等单位提出了一种新的探索驱动的大模型对齐方法 Count-based Online Preference Optimization(COPO),将人类探索的本能融入到大语言模型的后训练(Post-Training)中,引导模型在人类反馈强化学习(RLHF)框架下主动探索尚未充分理解的知识,解决了现有对齐框架受限于偏好数据集覆盖范围的问题。

这一创新成果为智传网(AI Flow)中 “基于连接与交互的智能涌现” 提供了重要技术支撑,使得模型在动态交互中不断学习和进步,在探索的过程中实现智能的持续涌现。论文被国际表征学习大会 ICLR 2025 录用,实现了大模型多轮交互探索中的能力持续提升。TeleAI 研究科学家白辰甲为论文的第一作者。

-

论文标题:Online Preference Alignment for Language Models via Count-based Exploration

-

论文地址:https://arxiv.org/abs/2501.12735

-

开源代码:https://github.com/Baichenjia/COPO

研究动机

虽然大型语言模型(LLM)在进行多种语言任务中已经有出色的表现,但它们在与人类价值观和意图对齐方面仍面临着很多挑战。现有的大模型 RLHF 框架主要依赖于预先收集的偏好数据集进行对齐,其性能受限于离线偏好数据集对提示 - 回复(Prompt-Response)的覆盖范围,对数据集覆盖之外的语言难以进行有效泛化。然而,人类偏好数据集的收集是较为昂贵的,且现有的偏好数据难以覆盖所有可能的提示和回复。

这就引出了一个关键问题:是否可以使 LLM 在对齐过程中对语言空间进行自主探索,从而突破离线数据集的约束,不断提升泛化能力?

为了解决这一问题,近期的大模型相关研究开始由人类反馈强化学习驱动的离线对齐(Offline RLHF)转向在线对齐(Online RLHF),通过迭代式地收集提示和回复,允许大模型在与语言环境的互动中不断学习和进步,从而在偏好数据集的覆盖之外进行探索。

本研究旨在解决在线 RLHF 过程中的核心问题:如何使 LLM 高效在语言空间(类比于强化学习动作空间)中进行探索。具体地,强化学习算法在进行大规模的状态动作空间(类比于 LLM 中的语言生成空间)中的最优策略求解时,系统性探索(Systematic Exploration)对于收集有益的经验至关重要,会直接关系到策略学习的效果。在 LLM 对齐中,如果缺乏有效的探索机制,可能会导致模型对齐陷入局部最优策略;同时,有效的探索可以帮助大模型更好地理解语言环境的知识,从而在广阔的语言空间中找到最优回复策略。

本研究的目标在于解决在线 RLHF 中的探索问题,即如何在每次迭代中有效地探索提示 - 回复空间,以扩大偏好数据覆盖范围,提高模型对人类偏好的学习和适应能力。具体地,COPO 算法通过结合基于计数的探索(Count-based Exploration)和直接偏好优化(DPO)框架,利用一个轻量级的伪计数模块来平衡探索和偏好优化,并在线性奖励函数近似和离散状态空间中提供了理论框架。

实验中,在 Zephyr 和 Llama-3 模型上进行的 RLHF 实验结果表明,COPO 在指令遵循和学术基准测试中的性能优于其他 RLHF 基线。

理论框架

研究的理论框架基于大模型奖励的线性假设,将奖励函数简化为参数向量和特征向量的内积形式。在此假设下,可以将复杂大模型对语言提取的特征作为一个低维的向量,将 RLHF 过程中构建的显式或隐式的大模型奖励视为向量的线性函数,具体地:

在此基础上,给定大模型偏好数据集 ,在现有 Bradley-Terry (BT) 奖励模型的基础上可以通过极大似然估计来估计奖励模型的参数,即:

,在现有 Bradley-Terry (BT) 奖励模型的基础上可以通过极大似然估计来估计奖励模型的参数,即:

随后,根据统计学中的相关理论,可以定量地为奖励模型提供了一个明确的误差界限,并得到关于奖励模型参数的置信集合(confidence set),从而使估计的参数以较大概率落在置信集合中。具体地:

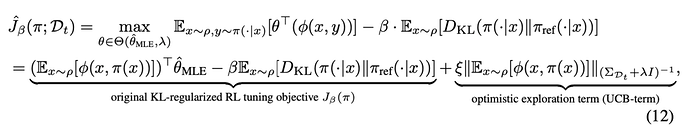

随后,在参数集合中可以使用乐观的期望值函数来获得值函数估计的置信上界,从而实现了强化学习探中的乐观原则(Optimism), 使大模型策略向乐观方向进行策略优化。

在上述目标中,最终的优化项包含两个部分:第一部分对应于经典的两阶段 RLHF 方法,在 BT 模型的基础上估计奖励,通过最大化奖励来学习策略,同时保持和原始大模型策略的接近性约束。第二部分为新引入的置信区间上界(UCB)项,用于测量当前数据集对目标策略生成的状态分布的覆盖程度,鼓励模型探索那些尚未充分探索的语言空间。

具体来说,UCB 项通过增加对较少产生的提问 - 回答的组合的对数似然,从而鼓励大模型生成新的、可能更优的回答。这将有助于大模型在最大化奖励和探索新响应之间的权衡,即著名的强化学习探索 - 利用权衡(exploration-exploitation trade-off)。

最终,研究证明了采用 COPO 算法的在线学习范式能够在 T 次迭代后,将总后悔值限制在 O (√T) 的量级内,显示了算法在处理大规模状态空间时的效率和稳定性。

算法设计

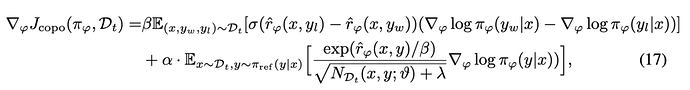

在理论框架下,具体的算法设计中结合了直接偏好优化(DPO)的算法框架。其中第一项对奖励的构建和奖励最大化的学习具象化为 DPO 的学习目标,而将乐观探索的 UCB 项转化为更容易求解的目标。具体地,在有限状态动作空间的假设下,乐观探索项可以表示为基于状态 - 动作计数(Count)的学习目标,即

从而,最终的学习目标表示为 DPO 奖励和基于提示 - 回答计数的探索目标。具体地,

上式中第二项通过在偏好数据中对模型产生的提示 - 回答进行计数,可以鼓励增加对之前出现次数较少的提示 - 回答的探索来鼓励大模型突破离线数据集的覆盖,使模型主动探索新的、可能更优的回复,从而在迭代过程中扩大数据覆盖范围并提高策略的性能。

进而可以通过求解梯度的方式进一步的解析 COPO 优化目标的意义:

由两部分组成:第一部分负责优化模型以最大化偏好数据上的预期奖励;第二部分对应于探索项的梯度,它根据提示 - 回复对的历史访问次数来调整模型的优化方向。当某个回复的历史访问次数较少时,该项会推动模型增加生成该回复的对数似然,从而鼓励模型探索那些较少被访问但可能带来更高奖励的区域,使算法能够在最大化奖励的同时有效地平衡探索与利用,实现更优的策略学习。

然而,在对大模型进行上述目标优化中,往往无法在大规模语言空间中实现对 “提示 - 回复” 的准确 “计数”。语言空间的状态通常是无限的,且完全相同的回复很少被多次产生,因此需要一种方法来估计或模拟这些提示 - 回复对的 “伪计数”,以便算法能够在探索较少访问的区域时获得激励。在此基础上,COPO 提出使用 Coin Flipping Network(CFN)来高效的实现伪计数。CFN 不依赖于复杂的密度估计或对模型架构和训练过程的限制,而是通过一个简单的回归问题来预测基于计数的探索奖励。

具体地,CFN 基于的基本假设是,计数可以通过从 Rademacher 分布的采样来估计来得到,考虑从 {-1,1} 的集合中近似随机采样得到的分布,如果进行 n 次采样并对采样结果取平均,则该变量的二阶矩和计数的倒数呈现出等价的关系,即

进而,CFN 通过在每次遇到状态时进行 Rademacher 试验(即硬币翻转),并利用这些试验的平均值来推断状态的访问频率。在实现中,CFN 表示为一个轻量化的网络,它通过最小化预测值和实际 Rademacher 标签之间的均方误差来进行训练。

在实现中,CFN 接受由主语言模型提取的提示 - 回复对的最后隐藏状态作为输入,并输出一个预测值,该值与状态的 “伪计数” 成反比。通过这种方式,CFN 能够为每个提示 - 响应提供一个探索激励,鼓励模型在探索迭代中扩大数据覆盖范围,提高模型对齐的性能。

实验结果

在实验中使用 UltraFeedback 60K 偏好数据集来对 Zephyr-7B 和 Llama3-8B 模型进行微调,数据集中包含丰富的单轮对话偏好对的数据。实验中使用了一个小型的奖励模型 PairRM 0.4B 来对多轮迭代过程中模型模型生成的回复进行偏好排序,从而在探索中利用不断更新后的大模型来产生不断扩充的偏好数据,提升了数据集的质量和覆盖率。

此外,实验中使用轻量化的 CFN 网络实现对提示 - 响应对的伪计数,大幅提升了在线 RLHF 算法的探索能力。

实验结果表明,COPO 算法在 AlpacaEval 2.0 和 MT-Bench 基准测试可以通过多轮探索和对齐来不断进行性能提升。具体地,相比于离线 DPO 算法,COPO 显著提升了 Zephyr-7B 和 Llama3-8B 模型的 LC 胜率,分别达到了 18.8% 和 7.1% 的提升,验证了 LLM 探索能力提升对获取更大数据覆盖和最优策略方面的优势。

此外,COPO 超越了在线 DPO、SELM 等当前最好的在线对齐方法,以 8B 的模型容量超越了许多大体量模型(如 Yi-34B,Llama3-70B)的性能,提升了大模型在语言任务中的指令跟随能力和泛化能力。

团队负责人介绍:李学龙,中国电信集团 CTO、首席科学家、中国电信人工智能研究院(TeleAI)院长,主要关注大模型、智能光电、临地安防、智传网(AI Flow)。

© THE END

转载请联系本公众号获得授权

投稿或寻求报道:liyazhou@jiqizhixin.com

![]()

,在现有 Bradley-Terry (BT) 奖励模型的基础上可以通过极大似然估计来估计奖励模型的参数,即:

,在现有 Bradley-Terry (BT) 奖励模型的基础上可以通过极大似然估计来估计奖励模型的参数,即: